機械学習

| TOP | 車山高原お知らせ | 車山高原ブログ | 歴史散歩 | 旅ネット信州 |

| 14Cによる年代測定で、日本列島の土器が約1万6000~1万5000年前まで遡り、世界最古の土器の一つとなった。 | ||

|

|

|

| 車山の古代の狩人は、このオオウバユリをどう調理していたのだろうか! | ||

| 目次 |  |

| 1)クラウドとは | |

| 2)「学習」と「推論」 | |

| 3)アジャイル開発 | |

| 4)次元削減 | |

| 5)新たな時代を呼び込む基幹技術 | |

| 6)エッジコンピューティング | |

| 7)クラウドコンピューティング | |

| 8)IoTシステムの開発の実態 | |

| 9)セキュリティー情報とイベント管理 | |

| 10)概念実証 | |

| 11)スピントロニクス(量子の世界) |

『古事記』は偽書にあらず

古代メソポタミア

古代メソポタミア史

ヒッタイト古王国時代

ヒッタイトと古代エジプト

ギリシア都市国家の興亡

細胞化学

DNA

遺伝子発現の仕組み

ファンデルワールス力

生命の起源

アポミクシス

植物の色素

植物の運動力

遺伝子の発現(1)

遺伝子の発現(2)

元素の周期表

デモクリトスの原子論

相対性理論「重力」

相対性理論「宇宙論」

相対性理論「光と電子」

素粒子の標準理論

太陽系の物理

半導体

AI半導体

AIチップ

機械学習

植物の進化史

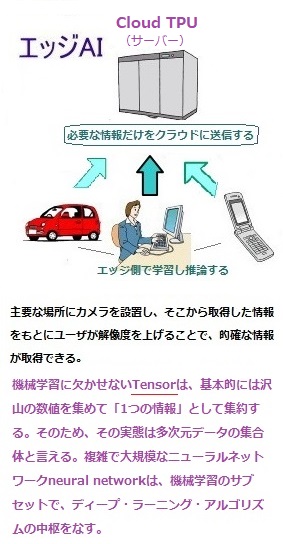

クラウドとは、ユーザーがサーバーserverやストレンジStorage(スマートフォンやパソコンなどのデバイスにデータを保管する場所、HDD・USBメモリ・microSDカード、そしてUSBメモリーと同じように内蔵しているメモリーチップにデータの読み書きをするSSD【ソリッドステートドライブ】)などのインフラやソフトウェアを持たなくても、インターネットのネットワーク経由で、ユーザがサービスを必要な時に必要な分だけ利用できるシステムのことである。クラウド・コンピューティングと呼ばれることもあるサーバーとは、そのサービスを提供するコンピュータを指す。

通常、その機能を提供するパソコンは、自身のパソコンがWindowsであれば、画面のすぐ近くに黒い箱のような機械に備わっている。その黒い機械の箱がパソコンの本体である。

通常パソコンを使って、ホームページを見たり、メールサービスやゲームをしたり、さまざまなインターネットサービスを利用している。そのサービスが利用できるのも、サービス提供会社が、個々別々に保有すパソコンにサービスをのせて送信しているからである。我々のパソコンの向こう側にはグーグル・LCVなどサービスを提供しているコンピュータがある。そのサービスを提供しているコンピュータのことをサーバーと呼ぶ。

通常パソコンを使って、ホームページを見たり、メールサービスやゲームをしたり、さまざまなインターネットサービスを利用している。そのサービスが利用できるのも、サービス提供会社が、個々別々に保有すパソコンにサービスをのせて送信しているからである。我々のパソコンの向こう側にはグーグル・LCVなどサービスを提供しているコンピュータがある。そのサービスを提供しているコンピュータのことをサーバーと呼ぶ。そのサーバーが、インターネットなどのネットワークに接続されたコンピューターから提供するサービスを、そのユーザがネットワーク経由で個々のパソコンやスマートフォンで活用する。

これまではハードウェアを購入し、ソフトウェアやデータを個々のPCにインストールして利用するのが主流であったが、クラウドの登場により、オンライン上でソフトウェアの利用やデータの保存や送受信が可能になった。

インターネット(雲)の向こう側のサービスを利用していることから、クラウド(cloud=雲)と呼ばれるようになったといわれている。

この他にもcrowd(クラウド)と書いて、集約したシステムという意味でクラウドと呼んだとも言う。しかしながら、「クラウド」の由来には諸説がある。この他にもcrowdには、「群集」や「閲覧」する意味もあるようだ。

クラウド・コンピューティング以前は、企業の多くは、大企業であればあるほど、サーバーを含むソフトウェアなどの情報システムを使用者が管理する社内にホストコンピュータ(メインフレームmainframeとも呼ぶ)を設置し、それ自体を誇りにしていた。

その後のネット社会により、コスト削減効果が際立つため、より多くのユーザをクラウドへの初期移行へ誘発したが、当初、そのユーザの殆どがパブリックやプライベートに関わらず、クラウドインフラストラクチャにより多くのメリットが実現すると期待していた。

従来は一般的なサーバー運用形態に依存していたが、インターネットに接続された「クラウドコピューティング」といった外部のサーバーリソースをオンデマンドで利用する新たな形態が普及するにつれて、従来の形態を「オンプレミスon-premises」という言葉が使われるようになった。「オンプレミス」とは、サーバーやソフトウェア、送受信などの情報を、使用者が管理している企業内のホストコンピュータで運用することに由来する。

クラウドに対するオンプレミスのメリットには、利用するサーバーやネットワーク機器やデバイスなどを自由に選定できることにある。また、大規模な人工知能の学習などに利用する極めて高い処理能力が求められるシステム、あるいはシステムが停止すると大きな支障が生じることから高可用性High Avlity(可用性availabilityが高い状態のことで、システムが提供している機能やサービスが停止・中断する頻度や時間を極力少なく抑えること)が求められている。

企業や組織の事業において、自らにとってその欠落が致命的損害となりうる要素のことをミッションクリティカルmission criticalと呼ぶ。システムなどでは、クラウドでは構築が難しいケースもあるため、オンプレミスが選択されることが少なくない。

目次へ

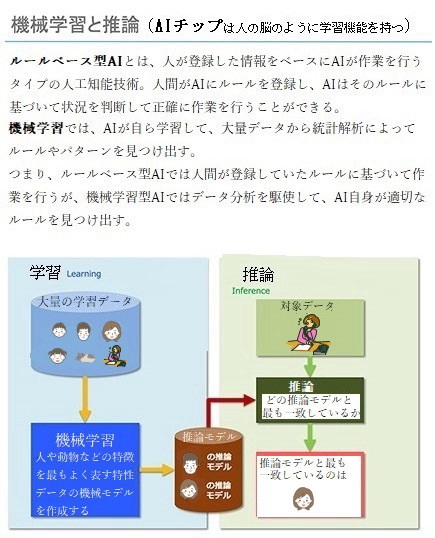

人工知能とは人間が行っている音声・映像・言語などの理解や分類などの学習や、それから導かれる問題解決や推論inferenceなどの自立した知的な活動を行えるように技術開発されたコンピュータである。しかし、現段階での機械学習は、人工知能のように人間の知的活動すべてを対象にはしていない。機械学習は、ある特定の分野を、一つの主要な課題として、膨大なデータに基づいて学習し、データの分類とそこに潜む規則性を見出し、その学習効果で生成されたパターンを「法則化=推論モデル化」に当てはめて推論を導き出す。

例えば、音声や映像を始めとする大量のデータを分析する方法では、さまざまなデータを反復学習をして、学習した事象の特徴や傾向などを捉え、「法則化=推論モデル化」を達成する。その法則化した特徴や傾向を「自動化」し、それ以降はその法則に則って推論できるようにする。

例えば、音声や映像を始めとする大量のデータを分析する方法では、さまざまなデータを反復学習をして、学習した事象の特徴や傾向などを捉え、「法則化=推論モデル化」を達成する。その法則化した特徴や傾向を「自動化」し、それ以降はその法則に則って推論できるようにする。警視庁は、リアルタイムで民間の監視カメラを一元管理し、顔認証システム(「法則化=推論モデル化」)で識別するシステムを持っている。全国の警察でも、民間の防犯カメラやSNSの画像を顔認証システムで照合している。「顔認証」は、2Dや3D画像情報から目・鼻・口など形や各部位の位置関係などの情報を認識し、あらかじめ膨大な顔情報を登録したデータベースと照合して特定の人物を認証する技術である。コロナ禍以降では、マスク着用でも認識できる機能を備えている。

人体の頭・首・手などの詳細な部位情報を認識して、人体の骨格や姿勢を検知する技術では、ディープラーニングの技術が使われている。かつて骨格検知や姿勢検知には、奥行きを推定できる高価なカメラが必要であったが、AI技術の進歩により、普通の単眼カメラでも検知可能になっている。

機械学習モデルの一般的なタイプの 1 つである「回帰regression」は極めて重要で、機械学習では、regressionとは、「連続する入力値に対する次の出力値を予測する」ことを言う。例えば、結果に対する原因を推測するために、宣伝広告内容と費用と来店者数の関係を数式化して分析する際などに活用する。

アプリ開発の世界では、プログラム機能の追加・修正で、他の箇所に予想外の不具合が発生していないかを確認するテストを「回帰テストregression test」と言う。「回帰分析regression analysis」では、顧客の過去の購買行動や商品の需要予測、プロモーションするとどのくらい来店者数が増えるかなど、ある結果に対する要因と効果を推測するために数式化する。IT技術の発展で集まった大量のデータは、「回帰分析」などの統計手法でデータ分析され、マーケティングに幅広く活用されている。

一方、「分類」では、購買行動データから顧客が新商品を「気に入るかどうか」の二択で予測する。

「回帰分析」を用いれば将来の需要や企業売上だけでなく、そのビジネスの展望も予測できればと、期待されている。しかしながら、これは回帰分析に限ったことではないが、データ分析にはIT分野の専門技術者ばかりでなく、開発分野に関わる「製造技術」・「経営」・「経済」・「法律」・「数学」などの専門的な知識が求められる。

データ分析基盤の構築・運用となれば、高い専門性と汎用性が欠かせない。そのため、広範な専門スキルを持った一部のデータエンジニアの主導に偏りがちとなる。そうした属人化した状態となれば、担当者の退職や異動にともなう引き継ぎがうまくいかず、データ分析の継続が困難になる可能性が高い。

機械学習は未だ発展途上にあり、答えが間違っていることもある。そのニュアンスを含み「問題を解く」ではなく「推論する」と表現する。英語で「inference」とか「prediction」を使うのは、いろいろな意味合いがある。「inference」とは「既知の事柄を元にして未知の事柄について予想し、論じる事」、「prediction」となれば「将来何が起こるかについての予測」である。また、推論結果をチェックすることをvalidation(妥当性確認【試験をして開発製品が規格や要求を満たしているかを確認する】)とか、testとか、evaluation(評価)などの英語が使われる。

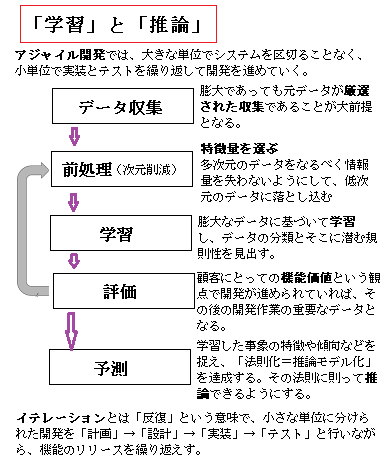

機械学習では、「推論」とは回帰・分類・区分・物体検出・自然言語処理などに限らず、開発が進むにつれ、天気予報や市場経済予想など時系列情報予測の領域まで広がり、その精度も高まっている。今や、「推論」は、元となる膨大なデータから未知の情報を示すこともある。そのため、膨大であっても元データが厳選された収集であることが大前提となる。

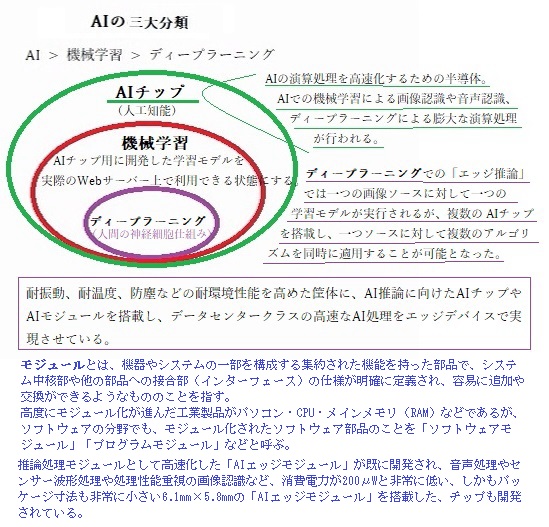

機械学習による画像認識や音声認識や、ディープラーニングレベルとなると膨大な演算処理がAIチップで行われる。「機械学習」で使用されるAIチップは、AIの演算処理を高速化するための半導体でもある。一般的にAIの演算処理には、識別や分類したい膨大なデータから、各種の特徴の組み合わせパターンを作り出す『学習プロセス』と、それのよる結果を導く『推論プロセス』に分けられる。そのため、それを処理するAIチップにも、それぞれのプロセスに応じた学習用と推論用の2種類が存在する。

ディープラーニングされたAIチップでは、動画や画像から個人の顔を読み取り、目、鼻、口などの特徴的な形や位置関係、顔領域の大きさなどをもとに、登録された情報と本人照合を行う仕組みになっている。デパートや銀行では、顧客が入口から入ってきただけで、その顧客の営業担当者に連絡が入るようなシステムまであるから、最近では、高いセキュリティが求められる企業や施設の出入り管理での利用も進んでいる。

機械学習では、与えられたデータからデータに潜む規則性を自動的に発見し、そのデータの分類や未知のデータの予測までして数式化し、コンピュータの計算手法「回帰」までも行う。データから予測を行うとき、扱うデータによっては膨大な規則を用いたり、見つけることが難しい規則が存在したりする。それらをコンピュータの計算に落とし込むことで予測への信頼が一層高まる。

目次へ

ソフトウェアのアジャイル開発プロセスで、利用者の視点から見たソフトウェアやシステムの持つ機能・特徴のことをフィーチャー featureということがある。「次元数」では、データセットのフィーチャーfeaturesの数を示す。

アジャイルAgileとは、直訳すると「素早い」「機敏な」「頭の回転が速い」という意味である。アジャイル開発は、システムやソフトウェア開発におけるプロジェクト開発手法のひとつで、大きな単位でシステムを区切ることなく、小単位で実装とテストを繰り返して開発を進めていく。従来の開発手法に比べて開発期間が短縮されるため、Agile(素早い)と呼ばれている。

従来のソフトウェア開発は、ウォーターフォールモデルによる開発が主流であった。ウォーターフォール開発は、最初に全体の機能設計・計画を決定し、この計画に従って開発・実装していく手法である。機械製造や造船業、ソフトウェア開発などさまざまな開発に応用できる手法として、広く活用されていた。

従来のソフトウェア開発は、ウォーターフォールモデルによる開発が主流であった。ウォーターフォール開発は、最初に全体の機能設計・計画を決定し、この計画に従って開発・実装していく手法である。機械製造や造船業、ソフトウェア開発などさまざまな開発に応用できる手法として、広く活用されていた。アジャイル開発では、「開発途中に仕様や設計の変更があることは当たり前」という前提があるから、ソフトウェアの計画段階で厳密な仕様を決めずに、だいたいの仕様と要求だけを決める。おおまかな計画のみでは、その後の実装フェーズで問題が起こりそうだが、仕様が決まっていないと途中で変更があっても臨機応変に対応できるため、顧客のニーズに最大限応えることが可能となる。

「イテレーション」

だいたいの仕様と要求を決めたら、イテレーションiterationと呼ばれるサイクルを繰り返して開発を進める。イテレーションとは「反復」という意味で、小さな単位に分けられた開発を「計画」→「設計」→「実装」→「テスト」と行いながら、機能のリリースを繰り返えす。

イテレーションは1週間~2週間ごとが一般的で、イテレーションごとに毎回機能をリリースreleaseする。ITの分野ではソフトウェアの公開や発売のことをリリースということが多い。アジャイル開発では、初めに「いつまでにどの機能をリリースできるか」というプロジェクト全体を管理するためのリリース計画を立てる。そのため、「イテレーション1」「イテレーション2」「イテレーション3」と繰り返しながら、細かく開発を進めていく。

アジャイル開発は、開発の途中で仕様の変更や追加が予想されるプロジェクトに向いている。ノートPC・携帯電話・スマートフォン・PDA・UMPCやネットブックなどのような持ち運び中に使用可能な電子機器や、モバイルmobile分野などの日進月歩で技術や仕組みが進化している産業では、開発の途中で仕様の変更や追加が容易に予想できる。アジャイル開発では、計画段階で厳密な仕様まで決定しないため、途中変更の多いプロジェクトと相性が良い。

「スクラム」

スクラム開発は、アジャイル開発の中でも重要な手法で、開発を進めるためのプロジェクト管理フレームワークを組織する。スクラムとはラグビーで肩を組んでチーム一丸となってぶつかり合うフォーメーションformationのことである。その名の通り、チーム間のコミュニケーションを重視する。

チームが一連の価値観、原則、実践を通して作業を構造化して管理するのに役立つ。大事な試合に向けて練習を積むラグビー チームと同じように、スクラムがサポートするのは経験を通じて能力を高め、問題に取り組みながら自己管理し、過去の成功と失敗を振り返って継続的に改善するチーム作りである。 メンバーが協力し計画を立案し、イテレーションごとに開発の進行に問題や支障がないか、制作物の計画通りの性能検査や動作検査するなど、メンバー間でのコニュニケーションが重要となる。コミュニケーションに真剣に取り組まないと、イテレーションの制作物としてリリースができなくなり、やがてリリースしても機能が正常に働かないなどの問題が重なる。スクラムを組むように、チーム全員が協力して開発を進めることが大切である。

「エクストリーム・プログラミング(XP)」

エクストリーム・プログラミングExtreme Programmingとは、事前に立てた計画よりも途中変更などの柔軟性を重視する手法である。

アジャイル開発では、最初に綿密な計画を立てず、臨機応変に進める開発方法であるため、設計・実装・テストを短期間で何度も繰り返しながら、顧客の意見や要望をその都度取り入れて開発を進める。エクストリームプログラミングは、継続的な成長に主眼を置いている。設計・実装・テストの1サイクルをイテレーションと呼びが、開発チームでは「コミュニケーション」「シンプル」「フィードバック」「勇気」の4つの価値を共有することで推進していく。中でも「勇気」は、開発途中の仕様変更や設計の変更に立ち向かう勇気を指す。初期の計画よりも技術開発を重視しているため、プログラマー中心の開発手法と言える。

「コミュニケーション」

プロジェクトが失敗する原因の多くはコミュニケーション不足である。エクストリームプログラミングでは開発チーム内だけでなく、顧客とのコミュニケーションも重視する。

「シンプル」

最初の設計は極力シンプルにする。基本的な機能だけを盛り込み、そのほかの機能が当然必要になるから、その都度対応できる準備はしておく。

「フィードバック」

ソフトウェア開発において、不要な機能を盛り込むのは大きな無駄と障害になる。顧客からのフィードバックを得て、必要な機能を洗い出すことが重要となる。

IT用語として、ソフトウェアやシステムの持つ機能・特徴のことをフィーチャーfeatureと言う。ユーザー機能駆動開発Feature Driven Developmentは、実際に動作するソフトウェアを適切な間隔で検討し、それを繰り返す手法でもあるため、反復的ソフトウェア開発工程の重要な要素となる。それらは全て、顧客にとっての機能価値featureという観点で駆動される。その主な目的は、実際に動作するソフトウェアを繰り返し、適切な間隔で提供する手法であれば、実際に動作する機能を駆動させるには、ユーザー側のビジネスの見える化を行い、そのため、事前にビジネスモデリングを開示する必要がある。

顧客にとっての機能価値featureという観点で開発が進められていれば、全体モデルの開発過程に伴う顧客の機能面での合理的な要求仕様は、その後の開発作業の重要なデータとなり、しかも、基本的に設計やモデルを理解することを容易にする最良の技法にもなる。実際に動作するソフトウェアを繰り返し、適切な間隔で提供することが新たなノウハウを開発する切っ掛けになる。但し、ユーザー側の安直な提案は、丁寧に阻止すべきである。

「勇気」

最初に綿密な計画を立てないという特性上、途中で大胆な変更が求められる場合がある。それに応えることが、機能価値featureを高めることになり、次のビジネスモデルとなる。

「尊重」

チームで開発する以上、ほかのメンバーとの協調する姿勢が欠かせない。お互いの手法と立場を理解し尊重しなければならない。

目次へ

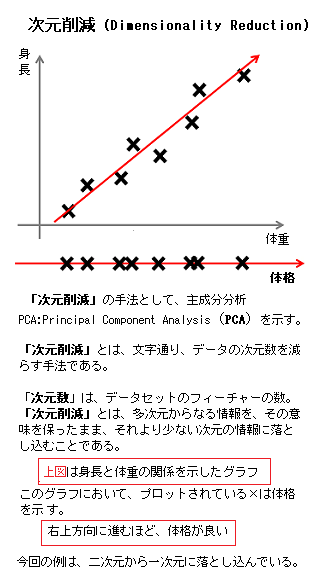

次元削減Dimensionality Reductionは、多次元のデータをなるべく情報量を失わないようにして、低次元のデータに落とし込む技法で、本質的なデータ構造(特徴features)を獲得し、データの圧縮やデータの可視化に繋げる「機械学習用語」である。

次元削減Dimensionality Reductionは、多次元のデータをなるべく情報量を失わないようにして、低次元のデータに落とし込む技法で、本質的なデータ構造(特徴features)を獲得し、データの圧縮やデータの可視化に繋げる「機械学習用語」である。正解の無いデータからグループ分けやデータの次元削減することで、データの隠れた構造を見つけ出す技法でもある。複数の観測変数それぞれに適切な重み付けした上で融合し、ひとつの潜在変数にまとめる手法により、データセットの次元数を減らすことができる。

次元削減では、多次元のデータが持つ情報はなるべく保持しながら、低次元のデータに変換する手法であれば、データの量を節約できるので計算を高速化でき、またデータの様子がより解釈しやすくなる。またデータの次元が多いと、学習にかかるコスト・時間・労力が増え、そして消費メモリーが増えるなどの問題が生じる。

その一方、例えば観測データに「身長」と「食事量」がある場合、潜在変数として「体重」を導入し変数をまとめたとする。データ数の減少により計算が高速化し、学習に用いる情報量が減少するが、場合によっては精度が下がる可能性も生じる。

次元削減は、データセットの次元数を減らすことであるから、複数の観測変数をそれぞれに適切な重み付けをした上で融合し、ひとつの潜在変数にまとめるという手法を用いる。この手法を用いる際に重要なのが、最も適切な選択肢を1つ選ぶことである。ただ、変数統合後の潜在変数の意味の解釈が主観になりがちになる。

一般に高次元のデータの計算にかかる計算コストと時間は少なくない。次元削減を行うと、メモリの節約につながり、学習コストの低下や処理速度の高速化につながる。 その解決策として、統計や機械学習の分野でよく使われる手法が、主成分分析Principal Component Analysis(PCA)である。つまり、主成分Principal Componentの分析作業で、高次元の生データセットが大量である場合、ほとんどの場合、一貫性のない冗長な特徴がたくさん含まれ、データとしてはあまり役立たない。むしろ、計算時間が長くなるだけでなく、探索的データ分析中の複雑さが増す可能性が高くなる。この情報処理現象を「次元の呪いThe curse of dimensionality」と呼ぶ。言わば、空間の次元が増えるのにつれ問題の算法が指数関数的に大きくなることを示す。この問題を克服するために、重要ではない特徴を削減・削除する必要がある。この「次元削減手法Dimensionality reduction technique」を使用して実現するPCAが、最も単純な次元削減手法の1つと見なされている。

主成分分析では、特徴量を抽出することによって、データセット内の次元を削減する。それによって、3次元以下に次元を削減することが出来れば、データを可視化することもできる。主成分分析では、特徴量を「選択」するのではなく、新しい特徴量を非可逆的に「抽出」するため、一度抽出したら、元のデータセットの特長量には戻らない。それにより失われる情報は少なからず生じる。

主成分分析では、特徴量を抽出することによって、データセット内の次元を削減する。それによって、3次元以下に次元を削減することが出来れば、データを可視化することもできる。主成分分析では、特徴量を「選択」するのではなく、新しい特徴量を非可逆的に「抽出」するため、一度抽出したら、元のデータセットの特長量には戻らない。それにより失われる情報は少なからず生じる。主成分分析とは、データセットの次元を削減するための手法であるが、主成分分析をした後の次元数を何個にしなければならない、といった規定はない。数多くある次元数の中から、「重要な次元」のみをピックアップすれば、次元を減らすことが出来ると言う意味合いである。

集団の中心的傾向を示す値を「代表値」と言う。代表値としては、一般に平均値が使われるが、分布の形によっては最頻値や中央値を代表値にする場合もある。ただ、データ集団は代表値のみでは捉え難い。代表値のそれぞれは、どれも平均値からの散らばり具合が大きく異なるのに、それぞれが違う特徴をもったデータであったことが理解され難い。データを捉えるためには中心的な傾向だけではなく、データの散らばり具合にも着目しなければ、その本質や傾向は伝わらない。

偏差(平均偏差)とは、各変量の平均からの隔たりの大きさを表す値である。しかし、偏差では、個々のデータの散らばりを示す事ができるが、データ全体の散らばり具合を見る時、単純に偏差の平均を求めるだけでは、データの散らばり具合を比較することができない。

そこで、それぞれの偏差に含まれるマイナスの値を無くした上で、2乗し全てを足し合わせた値(偏差二乗和)の平均を求めることで、データの散らばりの程度が分かるようになる。これを「分散」と言う。分散が大きくなれば、データ全体の散らばりが大きいことを意味する。主成分分析は「教師なし学習」なので、正解がないため、分散によって次元の重要度を決める。分散は、データのばらつきを表す指標の一つなので、分散が大きければ大きいだけデータのバラつきは大きく、分散が小さければ小さいだけデータのバラつきが小さくなる。また、分散が大きければデータの値ごとの差も見つけやすくなるが、分散が小さければデータの値ごとの差が見つけにくくなる。

また、多変数のデータを扱う上で、平面に可視化できるのは最大3次元までである。図として描くことができるのは3次元までで、4次元のデータを可視化するとなると一工夫が必要となる。 主成分分析PCAは、次元削減アルゴリズムの中でも最も有名な手法である。その手法を要約すれば、元のデータと比較し次元削減後の情報損失がなるべく小さくなるような軸を探し、その軸に向か

ってデータをマッピングする。

IT関連の「マッピングmapping」では、ある項目に対して、別の項目を位置づけたり、割り当てたりする。例えば「何かと何かを対応させて関連付けること」などで、異なるデータ項目を同一項目として関連付ける作業をマッピングと言う。

情報損失がなるべく小さいとは、統計学的には変換後のデータの広がり、すなわち分散を維持することを示す。ただ、元々、離れていたデータ同士が近い位置でマッピングされたら、それは分散を維持しているとは言い難い。

目次へ

画像処理やAIエッジモジュールにおいて、現在、高性能なGPU(画像処理装置)が必要となっており、学習用では、GPU(画像処理装置)がほぼ標準化されている。

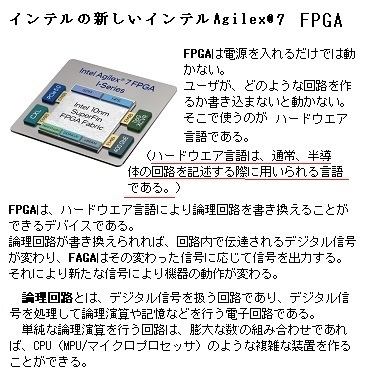

画像処理やAIエッジモジュールにおいて、現在、高性能なGPU(画像処理装置)が必要となっており、学習用では、GPU(画像処理装置)がほぼ標準化されている。一方で、学習用と推論用とでは、使われる素子のソフトウェアの機能や性能、動作などのspecスペック(specification【仕様】)が異なるが、推論用のAIチップにはGPU以外にもFPGAやASICでも実現が可能となっている。

FPGA とは Field Programmable Gate Array の略で直訳すると、「(現場で)ユーザによって書き換え可能な論理回路の多数配列(Field Programmable;【現場で】ユーザによってプログラミングが可能)」となる。つまり、FPGAは、購入後に回路構成を変更できる集積回路である。Gate Array(ゲートアレイ)とは、集積回路の製造手法の一種で、汎用的な回路素子を基板上に配置しておき、配線などの細かな仕様に関しては受注後に決定されるので、設計の自由度や集積度は劣るが、開発・製造に要する期間が短く、製造コストも大幅に抑えることが可能となる。

最近では、スマートフォンやタブレット、ネットワーク機器から自動車、医療機器まで幅広い分野で活用されている。簡単に言うと論理回路設計を間違えても即座にその場でハードウェア言語にて修正が出来るデバイスなので、「即座にその場で」出来るというのが FPGA の特徴である。

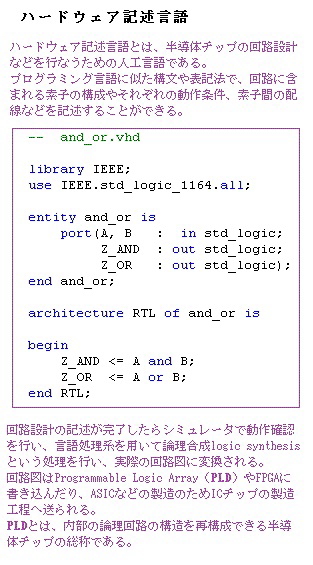

ハードウェア記述言語Hardware Description Languageとは、半導体チップの回路設計などを行なうための人工言語で、プログラミング言語に似た構文や表記法で、回路に組み込まれる素子の構成やそれぞれの動作条件、素子間の配線などを記述することができる。なお、ソースコードの前半が入出力関係、 後半がその間の論理(ANDとOR)を記述する。

回路設計の記述が完了したらシミュレータで動作確認を行い、言語処理系を用いて論理合成logic synthesisという処理を行い、実際の回路図に変換される。

しかしながら、一般的に使用されている電子デバイスでありながら、FPGAの設計手法を熟知しているエンジニアは多くはない。

繰り返しになるが、エッジ向けの推論用のAIチップは、IoTの現場で、AIを処理するデバイスとして展開されるため、「演算処理のパフォーマンス」だけではなく、「小さい消費電力」、「広い動作保証温度」、「長い供給期間」と言った採用検討の軸が、デバイスへの組込み実装の際には欠かせない。

繰り返しになるが、エッジ向けの推論用のAIチップは、IoTの現場で、AIを処理するデバイスとして展開されるため、「演算処理のパフォーマンス」だけではなく、「小さい消費電力」、「広い動作保証温度」、「長い供給期間」と言った採用検討の軸が、デバイスへの組込み実装の際には欠かせない。デバイスは、それ単体だけでも動作するパソコンや、タブレット・スマートフォンなどの「情報端末」と、パソコンなどにつなぐことで特定の機能を発揮する「周辺機器」の2種類がある。

ディスプレイ・プリンター・ハードディスクドライブ・フロッピーディスクドライブ・フラッシュメモリ・デジタルカメラなどが代表的な周辺機器にあたる。周辺機器は、外付けのハードディスクドライブHard Disk Drive(HDD)などの外部記憶装置、ディスプレイやプリンターなどの出力装置、キーボードやマウス、スキャナーなどの入力装置、モデムやLANボードなどの通信装置などに大別することができる。

(HDDは、磁性体を塗布したアルミニウムなどを原料とする金属性のディスクを、モーターで高速に回転させ、磁気ヘッドにデータを記録し読み出す補助記憶装置である。

モデムmodemは、元々パソコンと電話回線を使ってインターネットに接続するためには欠かせない装置であった。パソコンが理解できるデジタル信号と、電話回線などのアナログ信号とを、相互に変換するための装置であるため、コンピュータが標準の電話回線を介して、別のコンピュータに情報を長距離送信ができるための電子デバイスと言える。

Wi-Fiを使ってスマートフォンやタブレット、携帯ゲーム機をインターネットに繋ぐ時に必要になるのがルーターである。ルーターは異なるネットワークを接続するための装置で、Local Area Network (LAN)とWide Area Network(WAN)を繋ぐと、LAN側の複数の端末がインターネットに接続できるようになる。この場合のLANは宅内のネットワークを指す。WAN(ワン)はWide Area Networkであるから、インターネット自体がWANで、しかもLANとLANを繋ぐワイドなネットワークと言える。

LANケーブルは「インターネットに有線で接続する際に必要なケーブルのことで、インターネットをするときにパソコンが繋ぐ線」である。)

新たな時代を呼び込む基幹技術、モジュールAIチップの開発競争が激化し、本格的なAI時代が到来しようとしている。その影響は、基盤製造技術の開発発展はもとより、その成果が医療・金融・物流・交通・農業など広範囲に及ぶ革新的な技術開発を誘発した。

AIチップは350種以上のアメリカ食品医薬品局Food and Drug Administration(FDA)認可機器を含め、現在、数えきれないほどの医療機器の開発では、医療データをリアルタイムで処理・予測・可視化するなど、医療環境には不可欠な装備となり、運営上の人や経費など多くの合理化の促進に貢献してきた。

その一方で、AI機能を実装したInternet of Things(IoT)の研究者やエンジニアの多くから、モジュールAIチップの迅速な業務適用を妨げる3つの壁が指摘されている。

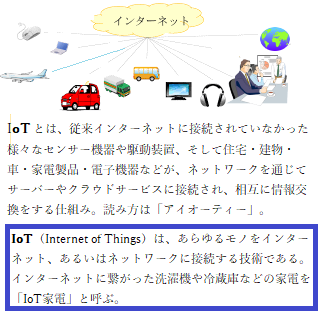

IoT(アイ・オー・ティー)とは、Internet of Thingsの略、直訳すれば、「モノのインターネット」であるが、本来は、Industrial Internet of Things(IIoT)の略で、Industrial IoTと表記されることもある。「製造業における、モノのインターネット」、製造現場の生産・加工機器やそれらを含むシステムと、各工程に関する情報をセンサやカメラなどで収集し、それらの情報をインターネットで共有する技術やサービス、ビジネスモデルなどを指す。

現在では、あらゆる産業分野で活用され、すべてのモノがインターネットにつながり、効率化や統合化が促進し、新たな付加価値が創出されている。インターネットに関連する機器が、通信を通じて、データ活用の高度化や自動化を図る動きが、総じて「インダストリー4.0」と呼び、昨今のトレンドにもなっている。

現在では、あらゆる産業分野で活用され、すべてのモノがインターネットにつながり、効率化や統合化が促進し、新たな付加価値が創出されている。インターネットに関連する機器が、通信を通じて、データ活用の高度化や自動化を図る動きが、総じて「インダストリー4.0」と呼び、昨今のトレンドにもなっている。インダストリー4.0

「インダストリー4.0」により、生産現場に「モノとサービスのインターネット(Internet of Things and Services : IoT・IoS)」が導入され、機械同士のコミュニケーションを可能にした。その結果、機械同士が自律的に製造工程を最適化し、生産性や生産工程の柔軟性を高め、多品種少量生産などの能力を飛躍的に向上させた。そうした新しい「ものづくりネット革命」の潮流の中で、強い国際競争力を持ち経済成長を促進する製品に搭載されるセンサーが集めた膨大なデータが集約され、新たなビッグデータ市場を産み出した。

IoT・IoSでは、エッジデバイスedge device・クラウドcloud・アプリケーションapplicationの3要素が、基本となって構成されている。

エッジデバイスとは、IoTの分野では「末端edge」にあたる機器を総称するので、インターネットに接続された製品全てを含む。その代表例がスマホで、スマホにはデータを加速度送信するシステムやGPS、カメラなどの各種センサが多数搭載されている。近年のエッジデバイスでは、CPUの機能を果たすプロセッサを核として構成され、これにコントローラ回路やメモリを統合し、複雑な制御も行える機能を持たせている。ニューラルネットワークneural network処理、ネットワークアダプタnetwork adapter(コンピュータなどの機器を通信ネットワーク【LAN】に接続するための装置)なども、ひとつのチップに集約され、これをシステム・オン・チップSystem-on-a-chip(SoC)と呼ぶ。

(neural networkを直訳すれば、人間の脳内にある神経細胞【neuronニューロン】とそのつながり、つまり神経回路網。IT用語では、ニューラルネットワークを、パターン認識・識別・分類・音声・映像・制御システムなど、さまざまな分野で複雑な機能が働き、従来のコンピューターや人間には困難な問題を解くことができる自律的学習を進める「ネットワーク」を指す。)

複数の集積回路を組み合わせてシステムを実現するのではなく、チップ上に回路を組み込むだけでもなく、システムとして統合された働きを示すAIチップの開発が進み、これまでの半導体の進化の歴史における、「小さく」「速く」を突き詰めた結果、1つのチップにIoT・IoSに関わる機能を詰め込み「小さく」「速く」を実現したものが、システム・オン・チップである。

AIの演算処理を高速化するための半導体チップ「エッジAIモジュール」では、AIでの機械学習による画像認識や音声認識、ディープラーニングによる膨大な演算処理が行われている。一般的にAIの演算処理には、膨大なデータの統計から、特徴の組み合わせパターンを作り出す『学習プロセス』と、識別や分類したいデータを、学習で生成したパターンの推論モデルに当てはめて結果を導く『推論プロセス』に分けられる。それを処理するAIチップにも、それぞれのプロセスに応じた「学習用」と「推論用」の2種類がある。

その一方では、画像処理やAI処理において、現在、高性能なGPU(画像処理装置)が必要となっており、学習用のGPUがほぼ標準化されつつある。一方で、学習用と推論用とではspecification仕様書(スペックspec)も異なるが、推論用のAIチップはGPU以外にも「現場でプログラムできる集積回路IC」を備えるField Programmable Gate Array(FPGA)や、ある特定の機器や用途のために、必要な機能を組み合わせて設計、製造された「カスタムIC;Application Specific Integrated Circuit(ASIC)」でも実現が可能になっている。産業用途で利用するAIチップも、その用途により選択の幅を広げている。

「スペック」とは、仕様(書)・明細(書)・諸元表・設計書などの意味を持つ英単語であるが、特にエッジ向けの推論用のAIチップは、IoTと共に現場でAI処理する重要なデバイスであるため、「演算処理のパフォーマンス」だけではなく、デバイスへの組み込採用の際には、「重要視される小さい消費電力」・「広い動作保証温度」・「長期安定供給」と言った検討軸が選択基準となる。既に開発済みのAIアプリケーションでの学習済みデータが存在すれば、そのデータとの完全なコンパチビリティcompatibility(互換性)を重要視する。つまり、コンパチビリティとは、ハードウェアやソフトウェアが、仕様の異なるものに置き換えられた上でも、元通りの動作をするという状態のことである。

アプリケーションソフトは、バージョンアップの度合いが激しいので、新旧の差があり過ぎる。同じ製品目的を共有しているとは言え、必ずしも優れたコンパチビリティがあるとは限らない。

そのため、開発した学習モデルを、「エッジAIモジュール」にデプロイメントdeployment(配置する)するためにメーカーから提供されているソフトウェア開発キットsoftware development kit (SDK)の使い勝手や、既存の自社開発環境へ適合するかどうかも重要になる。

(SDKは、ソフトウェアを開発する際に必要なプログラムやApplication Programming Interface 【API】・文書・サンプルなどをまとめてパッケージ化したもの、日本語ではソフトウェア開発キットとも呼ばれている。主にWEBサービスやアプリケーションソフトウェアの開発場面において利用され、特定のシステムに順応したソフトウェアを開発するために必要なプログラムや文書などがパッケージ化されている。それには、開発作業に必要なツールが一式含まれているため、効率的に開発を進めることができる。

2つの異なる機器やシステムやソフトウェア間で情報のやり取りがなされる際、その間を繋ぐインターフェースの提供だけにとどまると、その開発時に利用しづらい局面が生じる。

APIは既存のサービスやソフトウェアの一部を公開・提供することで、さまざまなサービスやアプリケーションとの連携を進める。ソフトウェアやサービスを利用して欲しい企業側は、APIを通して自社の製品を導入する環境が整えられる。一方、利用者にとっても、開発中のサービスに他社の機能を簡単に埋め込むことができるようになる。効率よく短期間で完成度の高い製品の提供が受け取れる。)

「エッジAIモジュール」は、AIの演算処理を高度化し高速化するための半導体チップである。「エッジAIモジュール」により機械学習の画像認識や音声認識、そしてディープラーニングによる膨大な演算処理をこなす。「エッジAIモジュール」においても、現在、高性能なGPU(画像処理装置)が必要となっており、学習用で採用されたGPUの能力は、採用される「エッジAIモジュール」の優劣に決定される。

AI推論処理で必要となる、GPUやAIチップにおいても、ストレージStorage(スマートフォンやパソコンなどのデバイスにおける、データを保管する場所や、HDD・SSD・USBメモリ・microSDカード)とメモリー同様に、民生品を主力としている製品や、産業用途での利用を想定した製品が販売されている。特に画像AIやエッジAIでの推論処理は、データセンターやオフィスだけではなく、様々な現場での設置を想定するため、画像処理から派生したGPUだけではなく、産業グレードindustrial gradeでは、AI推論に特化した「エッジAIモジュール」が選択肢として、既に登場している。

「エッジAIモジュール」向けに最高性能のAIプロセッサを開発しているチップメーカーでは、AI処理に特化した高い演算能力のある動画処理に適したAI コンピューティング デバイスを組込み、卓越したスピードと電力効率を提供し、低遅延・低消費電力による自己完結型の処理を実現させている。例えば、エッジ推論では、一つの画像ソースに対して一つの学習モデルが実行される。そのため複数のAIチップを搭載することで、複数のソースに対して複数のアルゴリズムを同時に適用することが可能となる。

そのため、複数の機器や装置、回路などを接続して通信するハードウェアインターフェースhardware interfaceを備えず、外部からデータや信号を入力(input)したり、外部に出力(output)したりすることもない。

目次へ

IT用語の「エッジ」とは、現実世界とサイバー空間との「境界」を意味する。エッジコンピューティング構想は、ユーザが直接使うエッジサーバ上でアプリケーションを実行することにより、現実世界のリアルタイム情報を瞬時に演算しデジタル化して、すぐにその場で再度現実世界へフィードバックするにことにある。これこそがエッジコンピューティングである。

エッジコンピューティングは、「端末の近くにサーバーを分散配置する」ネットワーク技法を特長にする。ネットワークの末端にあるエッジサーバーが、さまざまなセンサー関連の機器から送られてきたリアルタイム情報を、その手元で画像処理・音声処理、そして演算処理をし、ローカル5Gなど大容量データの高速伝送技術の普及により、工場内のあらゆる処理を自動化・高度化し、複数のロボットを往来させることも普通の実装光景となる。現在普及しているクラウドコンピューティングで、必然のサーバーへのアクセスによる「約100ミリ秒のずれ」を縮められる技術としても優れている。

エッジコンピューティングは、「端末の近くにサーバーを分散配置する」ネットワーク技法を特長にする。ネットワークの末端にあるエッジサーバーが、さまざまなセンサー関連の機器から送られてきたリアルタイム情報を、その手元で画像処理・音声処理、そして演算処理をし、ローカル5Gなど大容量データの高速伝送技術の普及により、工場内のあらゆる処理を自動化・高度化し、複数のロボットを往来させることも普通の実装光景となる。現在普及しているクラウドコンピューティングで、必然のサーバーへのアクセスによる「約100ミリ秒のずれ」を縮められる技術としても優れている。言わば、エッジコンピューティングは「端末の近くにサーバーを分散配置する」ネットワーク技法であれば、分散処理の仕組みが広域化され、しかも、それぞれの分野で必要最低限の処理に特化するプログラム化により動作速度が高まれば、実にその用途は広大無辺に広がる可能性が潜んでいる。

ヒトの平均的な反射反応時間は約250ミリ秒(1/4秒)、訓練を積んだトップアスリートでも200ミリ秒(1/5秒)だと言われている。そのため、制御の世界における100ミリ秒(1/10秒)では遅すぎる感覚が生じる。特に、職場の現場のエッジコンピューティングのレベルで.は、一瞬の判断を要する場面は少なからずある。そのため、極めて有効な技術であるため用途は広い。

(「ローカル5G」とは、通信事業者【キャリア】に頼らず、企業や自治体などが「自己の建物内」「自己の領域内」などで利用可能な独自の5Gネットワークを構築する自営無線を指す。5Gの特徴である「超高速・大容量」「多数同時接続」「超低遅延・高信頼」をキャリアに依存することなく局所的に実現することができる。

無線局免許が必要であるが、電波の干渉がないため通信の安定性が高く、接続端末が移動しても社内システムが維持され、しかも広範囲なエリア展開が実現されるなど、業種分野を問わず活用されている。

海外でも、アメリカ・ドイツ・フランス・イギリスなどでもローカル5Gの活用が進んでおり、いくつか事例が報告されている。ローカル5Gは自エリア内で独自のネットワークを構築できるため、外部ネットワークと切り離して運用することが可能である。また、周波数によってはサービスエリア外への電波の漏洩が少ないため、高度なセキュリティが保たれる。

また、無線LAN アクセスポイントと接続する際のSubscriber Identity Module【SIM】認証により、無線LANアクセスポイントのエリアに入ると、自動的にユーザー認証され無線LANに接続されるため、よりセキュリティは向上する。)

電子デバイスが小型化、高性能化し、「端末」が小型のプロセッサーやインテリジェントなセンサに置き換わったことで、極めて微細な世界でも、より早く正確なセンシングsensing(センサーなどを使用して様々な情報を計測して数値化する)が可能となり、加えて、センシングへの要求水準もまた高まっている。

電子デバイスが小型化、高性能化し、「端末」が小型のプロセッサーやインテリジェントなセンサに置き換わったことで、極めて微細な世界でも、より早く正確なセンシングsensing(センサーなどを使用して様々な情報を計測して数値化する)が可能となり、加えて、センシングへの要求水準もまた高まっている。かつて、センサ・プロセッサー・メモリー・電源機構などは、それぞれの機能を持つ半導体部品が個別に作られていた。高密度集積回路large scale integration(LSI)技術の進歩によってあらゆる機能を一つのチップに統合したシステム・オン・チップ(SoC)化が進み、センシングデバイスが小型化し、この流れに乗り、エッジコンピューティングも、人が端末へ入力してデータを取得する方法から、デバイス上でダイレクトにセンシングするなどデータ取得方法の自由度が高まった。しかも、センサ感度自体も高度化し、その技術と組み合わせることで、今欲しいデータを柔軟に取得するシステムも開発されている。

同時に、速くて軽く、電力消費も小さいAI搭載のプロセッサーにより、センサが取得した情報から意味のあるものだけを瞬時に選択し、周囲のコンピュータと連携して処理や学習を行い、より複雑で高度な成果を幅広い分野で実現している。

エッジコンピューティングでは、それぞれのコンピュータが自分の計算に必要なデータだけをそれぞれが保持する。そのため、ハードウエアに障害が生じても、全データの消失には繋がらないなど、セキュリティ面での利点も大きい。

エッジコンピューティングでは、インターネットを経由せずデータの処理と保持を行うため、個人情報保護が維持されたまま、よりパーソナルなデータを大量に扱うことも可能になった。しかも、伝送に要するエネルギーの削減や処理の高速化などの副次的効果も高い。

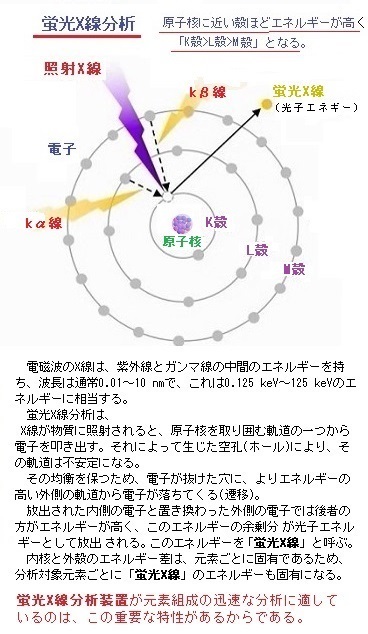

「奈良文化財研究所」では、14Cの年代測定に代表される放射線を用いた絶対年代の特定、X線透過試験などによる遺物の非破壊調査、放射化分析Activation Analysisや蛍光X線分析などによる遺物の材質調査、そして遺物に含まれる元素の特定分析による産地や流通経路などの解明がなされている。

(放射化分析は、元素や同位体の定量を分析方法で、少量および主成分元素の定量が分析できる。分析対象元素は単一あるいは複数の同位体からなる原子から構成されている。この原子に中性子・荷電粒子・光子【光量子】などからなる放射線を照射して、核反応により放射性核種を生成させる。

この放射性核種が壊変するときにα線,β線(β+線とβ-線)やγ線などの放射線が放出される。また、核反応時にも即発γ線といわれるγ線が放出される。生成する放射性核種が測定対象となる核種となり、放出する放射線のエネルギーやその強度を測定することで測定対象核種の量を決定し、元素量に換算して定量解析を行う。

この放射性核種が壊変するときにα線,β線(β+線とβ-線)やγ線などの放射線が放出される。また、核反応時にも即発γ線といわれるγ線が放出される。生成する放射性核種が測定対象となる核種となり、放出する放射線のエネルギーやその強度を測定することで測定対象核種の量を決定し、元素量に換算して定量解析を行う。特に、多くの場合、放射性核種からのγ線は、核種固有のエネルギーを持つから、放出する放射線としてはγ線が利用される。

放射化分析の名称は、照射する放射線の種類により大別できるが、また、放射線のエネルギーによって区別することもできる。

X線も電磁波であるが、その波長が100Åから0.1Åと非常に短いだけ放射エネルギーが強い。そのため、一般の電磁波に比べX線は容易に物質を透過し、その程度は物質に含まれる原子の原子番号【原子核の中にある陽子の個数】が小さくなるほど強くなる。

蛍光X線分析は、X線を物質に照射し発生する蛍光X線を利用する方法である。その蛍光X線とは、照射したX線が物質構成原子の内殻電子を外殻にはじき出し、その際、余ったエネルギーが光子として放射される。その蛍光X線の発生図を左図に示す。これら、蛍光X線は、元素固有のエネルギーを持っているので、そのエネルギーの定性分析が、そのエネルギーのX線強度(光子の数)から定量解析が可能になる。

蛍光X線分析も、X線領域の分光分析であると言える。蛍光X線もそれらの手法と同じように試料中の元素をX線で励起させて情報を得る。)

一般のX線透過写真では、前後の象嵌が重なって写り分離しにくいが、1回の撮影で数百~数千枚の透過像を取得するX線CTスキャナーでは、三次元で立体的に捉えられる。医学関係ではコンピュータ断層写真に利用されている。これを文化財に応用するため、国立歴史民俗博物館や奈良国立文化財研究所に機材を設置し、出土金属器や土器の研究解析に多くの成果を上げている。特に錆に被われた刀の柄頭や鍔などにある象嵌は、一般のX線透過写真では、前後の象嵌が重なって写り分離しにくい。CTスキャナー(Computer tomography scanner)の画像処理では分離も可能で、明確に立体的に表示される。

Tomographyとは、断層撮影、または断層撮影法とも言う。現在ではX線や陽電子などの粒子線などを利用し、多方向からの、その投影量を測定し、コンピュータにより断面像を得る方法が普及している。

遺跡から出土する遺物には、木製・鉄製・銅製・ガラス製など様々な材質があり、中には、金属製の遺物が土製と間違われていた例もある。しかも、遺物は、土に埋もれている間に劣化が進む。そのため発掘後の保存処理が重要であるが、金属と土では保存処理の方法が全く異なる。そのため、保存処理前の状態や材質の調査は不可欠である。

貴重な文化財は「壊さない」「汚さない」「触らない」が大原則である。エックス線撮影は、サビの下に隠れた金属製品の本来の姿や構造を知るのに役立つ。エックス線成分分析により、遺物に含まれる元素の種類やその含有量から、遺物の材質や製法が解析される。

目次へ

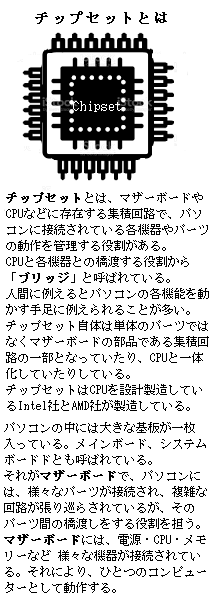

マザーボードは、画像処理に特化して演算を行うGPU用AIチップを搭載しているグラフィックボードや、CPU・メモリなどの各種パーツを取り付ける電子回路の基板である。CPUをマザーボードに設置するCPUソケットも実装されている。

このAIチップセットは、CPUからSATAやUSBなどのデバイスを接続する「モジュールAIチップ」である。マザーボードに実装されている。

SATA(Serial ATA;サタ)は、HDD・SSD・光学ドライブなどを接続するインタフェース規格で、チップセットによって管理・制御される。接続される機器の端子の形状や通信速度の上限などがある程度決まっている。

SATA(Serial ATA;サタ)は、HDD・SSD・光学ドライブなどを接続するインタフェース規格で、チップセットによって管理・制御される。接続される機器の端子の形状や通信速度の上限などがある程度決まっている。Advanced Technology Attachment(アタATA)とは、コンピュータ本体に、ハードディスクHDDなどのストレージ装置を繋いで通信するための接続方式の標準規格の一つである。

(モジュールmoduleとは、「単独でも機能するが、通常は他のものと組み合わせて使うような部品」。高度にモジュール化が進んだ工業製品の代表としてはパソコンがあり、CPUやその命令によて動く半導体記憶装置のメインメモリRandom Access Memory(RAM)、マザーボード・ストレージ・入出力装置などがある。その機能単位ごとに専門のメーカーがいくつもあり、購入時に好きな部品を選んで組み込むか、後から最新の部品に交換して機能や性能を向上させることもできる。)

クラウドコンピューティングでは、常にネットワークアクセスが必要であるが、システム全体の処理速度を上げることができるという利点がある。しかも、現在普及しているクラウドコンピューティングでは、高性能な演算資源やデータ プールdata poolをクラウド上に持ち、利用者はサービスを受ける度にサーバーへのアクセスが可能になる。

IoTデバイスの増加だけでなく、取り扱われるデータが画像や音声など容量の大きなデータになり、データセンターやクラウド上で処理されるデータが大量となるばかりで、これに伴いクラウドサービスでは、ユーザー側のデータがサーバーへアクセスするために「約100ミリ秒(1/10秒)」の時間が掛かる。その一方、エッジコンピューティングでは、この「約100ミリ秒」を短縮できる。

ヒトの平均的な反射反応時間はおよそ250ミリ秒(1/4秒)、一方、制御の世界でも100ミリ秒(1/10秒)では遅すぎる場面が、日常的に多く存在する。

エッジコンピューティングでは、このような一瞬の判断を要する場面に有効な技術となる。例えば、普及が期待されている自動運転には、エッジコンピューティングが不可欠な技術となる。障害物検知や衝突回避の急ブレーキなどは既に実用化が進んでいるが、100ミリ秒の反応遅延が人間の生命を脅かす事態となる。さらにエッジコンピューティングによる、自動運転に伴う道路環境設備と自動車双方のセンシングsensingの連携が前提となるため、瞬息な安全確保のため「エッジAIモジュール」などの開発の促進が大前提となる。

運転支援システムから自動運転システムへの進化など、自動車産業には大きな変革が訪れようとしている。「第4次産業革命」と呼ばれるIoTやAIチップを用いた技術革新により、自動車の自動運転を実現するうえで、目の機能を果たすカメラをはじめ、走行する車両や人などの位置と速度を瞬時に検知する「ミリ波センサー」や、レーザー光を照射して、その反射光のデータをもとに対象物までの距離や対象物の形などを計測する「LiDAR(ライダー)」といった高度なセンシング技術が活用される。

(センシングとは、英語で「感覚」や「感知」を意味する「sense」を、現在進行形にした「sensing」に由来しており、日本語では「感知機能」や「センサー機能」と訳されている。それには、現地現場の突発的な事態に即応する機能が期待されている

センシング技術は「スマートセンシングsmart sensing」と「リモートセンシング」の2つに機能分類される。「スマートセンシング」は、衝撃や温度、光量などの情報を検出し数値化する処理機能が組み込まれたセンサ(スマートセンサ)によるセンシング技術の総称である。スマートセンサーによる計測情報は非常に幅広く、血液で将来の疾病の発症確率を予測する医療検査や、ビッグデータを活用し異常反応を検知し、早期に知らせる仕組みによるプラント事故の防止、そして分析対象物の現状を変えず、その成分・品質などの特性を「非破壊分析」することにより、考古学や食品・化学など、さまざまな分野において多くの成果を上げている。

「リモートセンシングremote sensing」は、物質に接触することなく測定対象の情報を、主に電磁波を利用して検知できる技術である。例えば、人工衛星や航空機などにセンサーを搭載し、自然災害や環境問題、地質や資源探査といった地球規模のデータを収集分析する。気象衛星から雲や気圧、台風の進路などを予測する。GPSによりカーナビの位置情報や車両の追跡、野生動物の観察、人員管理など、その用途は限りない。)

IT分野でのクラウドとは、ソフトウェアやデータ、あるいはそれらを提供するための機器や回線といった技術的な機能を、原則的にインターネットなどのネットワークを通して必要に応じて利用者に提供する方式を意味する。クラウドのユーザーは、ハードやソフトを所有せずに、インターネットを通じて必要な機能を持ったサービスを利用する。そのため、自前のインフラを整備する必要がなくなるので、導入コストを抑えることができる。

一方、従来のオンプレミスon-premisesでは、サーバーやソフトウェアなどの情報システムなどを自社内で保有することになる。ただ、オンプレミスは導入にコストが掛かるが、カスタマイズに制約がなく、しかも社内で運用するのでセキュリティ面では自前の強化が図れる。

クラウドの目的は、主にエッジデバイスで収集したデータの集約である。そのメリットは、解析用のプログラムも、ほとんどの場合クラウド上で動かされているため、「導入コストの抑制」「優れた拡張性」「情報共有が容易」「メンテナンスが不要」「運用コストの削減」「エッジデバイスの所在が限定されない」「セキュリティ面の強化」などが挙げられる。ネットワークの発展により手軽に利用可能なクラウドサービスが急速に普及している。何よりも、自社でサーバーを導入するよりも格段に、コストと人、諸々の管理負担が抑えられる。

クラウドのアプリケーションは、主にエッジデバイスで取得したデータの処理や、処理したデータを可視化するために使われる。Webアプリやスマホアプリなどにより、PCに限らずスマートフォンからアクセスできることで、ユーザーの利便性を高めている。

クラウドコンピューティングでは、多発するアプリケーションの不具合や使用しにくい操作画面、クラウドとの通信・表示の問題などが開発の過程でよく発生する。しかも、運用後に気づかされる諸問題への対応能力などが、特に注意が必要となる。

IoT活用が有効に実現できれば、事業のさまざまな課題に対してアプローチが可能になり、実際に、IoTを活用して事業が改善し、新たな事業展開が可能となった事例も数多くある。その一方、アイデアのひらめきはあるものの、実際にIoT開発となると、技術面でキャッチアップができないまま、初動からつまずく事例も少なくない。

センサSensorとは、ある対象の情報を収集し、機械が取り扱うことのできる信号に置き換える素子や装置を指す。人間が視覚・聴覚・味覚・嗅覚・触覚などによって得た情報に基づいて行動するが、機械も同様にセンサから得た情報を基に、制御や処理を行う。特にIoTシステム内でのセンサなどを搭載した製品は、システムの末端に位置するため、エッジデバイスと呼ぶ。

目次へ

IoTシステムの開発は、一般的にその目的の明確化とそれを達成するための課題とそれに伴う必須要件の定義化と、その後に派生する、想定される諸問題に対する具体的な対策と、その諸条件設定に最適な設計・開発・検査・納品の流れの中で緻密に進む。最初に、どのようなIoTシステムが必要かについて要件を、現場だけに任せず経営陣が明確にしておくことが企業経営の未来を左右する。

エッジデバイスに関しては、試作の要件と量産の要件を明らかにする。その要件に基づいて、設計・開発・検査・納品の手順で、それぞれの実施する内容と役割分担を詳細に決定していく。また要件定義の段階では、要件の実現性をテスト機などで詳細に確認し修正を繰り返すことで、実施段階での完成度をより高め、後に想定される現場での混乱を最小化する。

検査は、システムの個々の機能の動作を想定しながら、各エッジデバイスの動作のテスト段階から詳細に検証し、関連する素子相互間で不具合が生じていないか、システムの個々の機能が設計通り連携動作するか、それらの問題が解決すれば各素子間の連携テストを実施し検討を重ねる。そのエッジデバイスが試作段階であれば、その検査の結果を反映した上で、再度、連携テストを重ねて問題があれば設計をし直し、再度、ユーザーが新たに設計されたIoTシステムで運用テストを実施する。これらを現実に、誠意を持って対応出来れば、完成度がより充実し、クラウドビジネスcloud business の将来のみならず、各導入企業の未来が決定されるかもしれない。

クラウドアプリケーションは、さまざまなソフトウェアの機能の中からユーザーが必要とする機能や機器だけを選んでインターネットや、閉域ネットワークで利用するサービスである。

閉域網とは、インターネットおよびインターネットに接続されている機器には接続せず、外部から直接アクセスすることが不可能にする通信ネットワークのことを指す。

ネット経由の攻撃・通信傍受・データ改ざんなどのリスクを回避し、限定した利用者だけが相互利用するネットワークが構築されるため、ウイルス感染のリスクの回避が期待でき、さまざまな分野で利用されている。

そのため、システムの実行とモニタリングmonitoring、常にプロセスと手順の継続的な改善に焦点を当てる変更の自動化と柔軟性、イベントへの対応、そして日常業務を管理するために、複数に分かれている業務マニュアルを統一して管理・活用する一元化と標準化などが最重要である。

ITの分野では、システムや通信機器などの状態をソフトウェアなどによって自動的に、定期的に調べ、結果を時系列にモニタリングすることが多い。そのデータにより問題発生時の詳細な原因調査が、性能向上などに貢献する。

期待通りの機能を実行するワークロードと、その要求に応えられなかった場合に迅速に回復する方法などの解答を共有することも、クラウドシステムの信頼性の大きな柱となる。また、分散システムの設計、復旧計画、および変化する要件への処理方法が含まれていなければならない。企業経営に重要な持続可能性の柱となるのは、実行中のクラウドワークロードによる企業環境を改善するだけでなく、戦略的なAIチップの活用により、新たな先端的戦術を生み出すレベルに達することで、次なる企業展開を目指す将来像が見えてくる。

ただ、時流に乗り便業する「詐欺的商法」に惑わされないことである。「詐欺的商法」は、ビジネスの世界では、通常に行われている。

不要なコストの回避に重点を置くコスト最適化の柱は、時間の経過に伴う支出の把握と資金配分の管理、適切なリソースresourceの種類と量の選択、および過剰な支出をせずにビジネスのニーズを満たすためのスケーリングの検証も極めて重要である。そのためには、企業が保有する資金や物質だけでなく、人材が最大のリソースであるため、経営陣を含めて有能な人材こそが企業の大いなる未来像を保障してくれる。

IoTのセキュリティがよく話題になるのが、特にネットワークに流れることで、データが盗まれる「スニッフィングsniffing(ネットワーク上を流れるデータを傍受すること)」による情報漏洩が、その対策を含めて極めて至難となっているのが実態である。本当に、誰が防御できているのかが分からないほど「大きな障害と迷惑なコスト要因」となっている。加害者は多いけれども「対策責任者不在」の状況である。

「スニッフィング」とは、インターネット上のデータを捕らえて、内容を解析して盗み見る行為である。暗号化されずに流れているデータは、「スニッフィング」により、すべて見ることができ、ユーザー名やパスワード、場合によっては個人情報やクレジットカード番号、メールなどの個人的なメッセージのやり取りなどを、本人に感知されずに読み取られる。

「スニッフィング」とは、インターネット上のデータを捕らえて、内容を解析して盗み見る行為である。暗号化されずに流れているデータは、「スニッフィング」により、すべて見ることができ、ユーザー名やパスワード、場合によっては個人情報やクレジットカード番号、メールなどの個人的なメッセージのやり取りなどを、本人に感知されずに読み取られる。一般的な通信において、データは細かな「パケット通信」に分割して送信される。受信するときは「パケット通信」を集約して復元し、データを見る。スニッフィングはそれらの「パケット通信」を途中で盗み見る行為である。インターネット通信で使われる「パケット通信」を不正に盗み、ユーザーの個人情報を入手するサイバー攻撃である。

パケット通信の仕組み

データを送信する場合、そのままの状態ではサイズが大きすぎるので、一度圧縮が行われる。次に、データは一定の大きさに分けられパケットになる。こうして完成したパケットは、いくつもの伝送経路をバラバラに通りながら相手先に届けられる。

途中、通信障害などによって一部の伝送が妨げられても他のルートに切り替えられ、しかもパケットの到着順序が変化しても、「ヘッダ情報」により正しい順番に組み立てられ、元の一つのデータ通りに復元することができる。こうした柔軟なデータのやりとりが、パケット通信であり、そのため、「ヘッダ情報」と呼ばれる送信先や送信元の情報などが、パケットの先頭部分に記述される。

Webページを閲覧してる間は、HTTP通信と呼ばれる通信が行われることで、指定のWebページが表示されるが、HTTP通信における情報はWebページに表示されるデータ本体だけではない。実は裏側で、「HTTPヘッダHTTP header」とよばれるテキストデータも送受信されている。

「ブラウザの種類やOS情報」、「検索エンジンクローラーの名前」、「どのページから生じたリクエストなのか」、「ブラウザを特定するための小さなデータ(クッキーCookie)」などが、HTTPヘッダに含まれてサーバーに送信されている。

(クローラーとは検索エンジンが検索の順位を決めるための要素を、サイトを巡回して収集してくるロボットbotのことを言う。「這い回る」という意味の【crawl】から、このように呼ばれている。

クローラーの巡回が一度も無く、ファイルが収集されないサイトは、当然のことながら検索エンジンにより表示される機会はない。このような場合は、いくらSEO対策に努めても意味がない。SEO対策の第一歩は、クローラーに検索されやすいサイトを作ることにある。)

目次へ

データの機密性と安全性、ユーザー許可の管理、セキュリティー情報とイベント管理 Security Information and Event Management (SIEM; シーム)などが、「セキュリティの柱」であれば、情報とシステムの保護のために常に、それらに焦点が当てられていなければならない。

セキュリティに関する概念には、SEM (セキュリティイベント管理Security Event Management) とSIM (セキュリティ情報管理Security Information Management) がある。SIMではログlogやその他のセキュリティデータの収集と管理に重点が置かれ、SEMではリアルタイムの操作分析とレポート作成を実行する。一般的に、SIEMは、これら2つのセキュリティ情報管理機能を組み合わせたシステムと言える。

クライアントPC上でのユーザーの操作や、外部との通信、ファイルへのアクセス状況など、PCのさまざまな動作をログとして記録し、その膨大なデータから必要な情報を抽出することで、「いつ」「誰が」「何をしたのか」を正確に把握し、情報漏洩リスクの素早い発見を支援する。

コンピューターや情報システムの世界では、さまざまな機器やソフトウェアの、ひとつひとつの操作や動作を「イベントevent」という。

例えば、キーボードのキーを押したりマウスでクリックすることもイベントだし、サーバーに命令を送ったり、それに反応してサーバーが情報を送り返すこともイベントと言う。そうして残された記録をログと呼ぶ。

「ログ」とは、ある機器のソフトウェアやシステムについて、その起動や停止、エラーや障害の発生、利用者による操作や設定の変更、外部との通信など、稼働中に起こったシステム上のイベントの内容を日時などとともに時系列に記録したものである。また、コンピュータやネットワークを介して複数の人の間で交わされたメッセージの内容を時系列に記録したものもログということがある。「log」の原義は船の航海記録(日誌)、何かトラブルがあった場合、ログで確認することで原因を突き止め、以後の対策を立てたりする。

ログは、サーバーやネットワーク機器、セキュリティ機器などに対して、いつどんなアクセスや操作があったか、あるいはそれらの機器がどんな動きをしたか、自動的に記録される。稼働状況の確認や集計、不具合の原因調査などのためによく参照される。

セキュリティイベント管理(SEM)は、情報システムのイベントを管理して安全性を確保することと、そのためのソフトウェアやサービスを言う。しかし、今日では、日々生成されるログは膨大な量になっている。その中から問題を探すのも大変だし、そうしている間にトラブルが拡大することも起こりうる。また、ひとつの機器のログだけでは分からない問題が、複数の機器のログを突き合わせることで判明することもある。

こうした状況から、さまざまな機器のログを統合的に管理して情報システムを守るソフトウェアやサービスが利用されるようになってきた。これをセキュリティ情報管理security information management(SIM)という。情報セキュリティ管理責任者の主な任務は、情報資産に対する管理責任者で、対策の指示や社内の指導、緊急時の対応、事故後の指示などがある。大規模組織であれば、経営者が決めた方針の通りに情報セキュリティ対策が行われているかを調査するため、内部監査責任者を立てている。内部監査を外部の専門家に依頼することもある。一般的には、経営者を情報セキュリティ組織のトップに置き、その下に情報セキュリティ管理責任者や情報セキュリティ内部監査責任者を配置する。

同じように、情報システムのイベントに着目して問題を監視したり見つけ出したりするソフトウェアやサービスも「セキュリティイベント管理(SEM)」である。

さらに今は、SIM とSEM を合わせたセキュリティ情報イベント管理Security Information and Event Management(SIEM;シーム)するサービスが増えている。

SIEMとは、事業運営が中断される前に、潜在的なセキュリティーの脅威や脆弱性を組織が察知するために役立つセキュリティー・ソリューションsecurity solutionとして働く。組織のネットワーク全体にわたる幅広いソースからイベントデータを取り込み、ユーザー・アプリケーション・資産・クラウド環境、およびネットワークからのログとフローデータflowdataなどがリアルタイムで収集、保存、分析され、SIEMのチームが、ネットワークのイベントログとネットワーク・フロー・データを1か所で一元管理する。

(フローデータとは、システムやプロセスに一定期間に流れるデータの変化量などを表す。その流れをグラフィカルに表現したものをデータフロー図Data Flow Diagram【DFD】と呼ぶ。システムにおけるデータ全体のflowを表す図であるため、システムを開発するうえで、フローデータを整理してデータフロー図を作成することで、認識のずれや不具合の防止にもなる。

大規模なソフトウェアを作るときは、メモ程度の設計書でソフトウェアの作成を進めることは、極めて困難で、しかも、ソフトウェアの作成を依頼する側と、ソフトウェアを作る側に認識のズレが起こる可能性が高い。 DFDはソフトウェア制作を依頼する側と作る側の開発メンバが、システムのイメージを共有する有効なツールであるため、機能の漏れや重複を防ぐ対策にもなる。)

脆弱性vulnerabilityとは、コンピュータのoperating system(OS)やソフトウェアにおいて、プログラムの不具合や設計上のミスが原因となって発生した情報セキュリティ上の欠陥のことを言う。脆弱性があるままコンピュータを利用していると、不正アクセスに利用されたり、ウイルスに感染したりする危険性が高まる。そのため脆弱性は、セキュリティホールとも呼ばれる。 このような脆弱性が発見されると、多くの場合、ソフトウェアを開発したメーカーが更新プログラムを作成して提供する。しかし、脆弱性は完全に対策を施すことが困難であり、しかも、次々と新たな脆弱性が発見されているのが現状である。

脆弱性が放置されていると、外部から攻撃を受けたり、ワームWormの感染に利用されたりする危険性があるため、インターネットに接続しているコンピュータにおける情報セキュリティ上の大きな課題のひとつになっている。 ワーム(ミミズや芋虫のような線形の虫)は、ネットワークや電子メールを介して他のコンピュータに送り込まれ自己増殖を繰り返し、更に自身が感染した経路や手段を繰り返して次々と他のコンピュータへ感染侵入する。ネットワーク負荷やCPU負荷の増大といった経過被害をもたらす。

ワーム自体がが独立したプログラムであるから、あるシステムからあるシステムに感染する過程には、宿主となるファイルを必要としない。 USBメモリなどを介して感染するタイプや携帯電話のOSに感染するタイプが猛威を振るい、早急のウィルス対策が喫緊の課題となっている。

脆弱性はクライアントとサーバ双方のコンピュータに関わる重要な問題である。特にインターネットに公開しているサーバの場合には、脆弱性を利用した不正アクセスによって、ホームページが改ざんされたり、他のコンピュータを攻撃するための踏み台に利用されたりなど、ウイルスの発信源にされる可能性があるため、脆弱性は必ず塞いでおかなければならない。 脆弱性を塞ぐには、常にOSやソフトウェアのアップデートが不可欠である。Windowsの場合には、サービスパックservice pack(font-size : 80%; ">これまでに生じたWindowsの製品に関するバグbugや脆弱性が確認された場合に、それを修正するプログラムを全部組み込んだ無償の「更新プログラム詰め合わせたソフトウェア」を指す。)やWindows Updateによって、それまでに発見された脆弱性を塞ぐことができる。>バグには「害虫・ばい菌」を意味する。IT用語では、ソフトウェアの不具合のことを指していたが、現在では不具合だけでなく、プログラムが作成者の意図した動きと違う動作をする原因を総称して「バグ」という。 不具合が表面化せず、プログラムの中に潜んでいるものを「潜在バグ」、仕様書の内容に矛盾や間違いがあるものを「仕様書のバグ」という。

バグには、プログラマーが「自分のせいではない」というような責任回避のニュアンスがあるため、「構造化プログラミング」の提唱者であるオランダ人の計算機科学者エドガー・ダイクストラ(1972年、今日のコンピュータプログラミングに必要不可欠な「構造化プログラミング」の基礎研究によりチューリング賞を受賞)は、プログラマーの自覚を喚起するために、「バグではなく、エラーと呼べ」と主張している。 プログラムや仕様書のバグを取り除くためには、プログラムのバグを取り除く単体テスト、「デバッグdebug (害虫駆除)」が不可欠である。たった1つのバグが原因で企業の基幹系システムが停止する事態も招くこともあるので、デバッグの果たす役割は大きい。

ただし、一度脆弱性を塞いでも、また新たな脆弱性が発見される可能性があるため、常にOSやソフトウェアの更新情報を収集し、できる限り迅速なアップデートを行わなければならない。 なお、近年は「ゼロデイ攻撃」と呼ばれる脅威が増加している。ゼロデイ攻撃とは、OSやソフトウェアに対する脆弱性が発見されたが、メーカーが修正プログラムを配布するまでの間に、その脆弱性を利用して行われる攻撃である。脆弱性が公開されてから、メーカーが対応策を検討して修正プログラムを開発することが多いため、完全な対策は困難と言わざるを得ない。そのため、指摘された脆弱性の内容を確認し、危険となる操作を行わないなど、修正プログラムの適用が可能になるまで慎重に注意する。

これが脅威インテリジェンスサービスの主な目的である。セキュリティ更新プログラムが未公開の脆弱性(ゼロデイ脆弱性)を狙う攻撃や、機密情報を盗み取ることなどを目的として、特定の個人や組織を狙う標的型攻撃、その中でも特に企業に影響を与える可能性の高い脅威について、そのリスクを企業が理解して、保護を強化する手助けをする。企業間で問題に直結する脅威を迅速に把握できるようにすることで、セキュリティホールを積極的にブロックし、データ損失やデータ侵害、システム障害の回避措置を講じやすくする。

標的型攻撃は、業務関連のメールを装ったウイルス付きメール【標的型攻撃メール】を、組織の担当者に添付する手口がよく使われる。従来は府省庁や大手企業が中心に狙われてきたが、今では、地方公共団体や中小企業もそのターゲットとなっている。標的型攻撃は、狙われた組織向けに巧妙に作り込まれているため、完璧な防御対策を立てることは困難となっている。

一方で、昨今、ソフトウェアの脆弱性が発見されても、修正プログラムが作成されるまでに時間を要するケースが見受けられ、その間に未修正の脆弱性を狙った攻撃が行われる。

そのため、入口段階で攻撃を防げず、組織にウイルスが侵入した時に、組織内から重要な情報が外部に流出する被害を食い止める出口対策を設けておくことが極めて重要となる。

主な出口対策としては、

ウイルス感染による外部への不審な通信を見つけて遮断する。

サーバやWebアプリケーションなどのログを日常的に取得し、異常な通信を見つけるために定期的にチェックする、といった侵入の早期発見と迅速な対応が重要で有効な対策となる。

特にログの取得は、侵入の発覚後に被害内容の特定や原因の追及をするために重要な情報源となる。万が一データが流出しても、情報にアクセスできないようにデータを暗号化しておく事前の対策も重要となる。

脅威インテリジェンス

「脅威インテリジェンス」は、組織が直面する可能性のある攻撃と、その攻撃を検知して阻止する方策である。デジタルセキュリティ分野の用語で「脅威」とは、データが盗難・損失、または無断で変更される可能性がある悪意のある行為を指す。この用語は、潜在的な攻撃と実際の攻撃の両方を指す。

「技術的脅威インテリジェンス」によって、組織は単にデータを提供するだけでなく、脅威インテリジェンスの一つひとつが、攻撃の検知と防止に役立つ。攻撃が行われている具体的な痕跡、例えば、セキュリティ侵害インジケーターIndicator of Compromise(IOC;アイオーシー)である。「Indicator of Compromise」とは、日本語にすると侵害指標や痕跡情報となる。そのため「セキュリティ侵害インジケーター」と呼ばれる。サイバー攻撃の痕跡をデータベース化して技術仕様として活用することで、攻撃を受けていることを素早く察知し、その影響範囲の最小化を目指すのがIoCの基本的な考え方である。

脅威インテリジェンス ツールの中には、人工知能を使用してこのようなインジケーターを探索するものもある。例えば、フィッシング詐欺の E メールの内容、C2インフラストラクチャの IPアドレス(パソコンやタブレット、スマホなど、複数端末持っている場合には、それぞれ個別のIPアドレスが必要。メールアドレスは一人に1つで十分、使っている端末分は必要としない)、既知のマルウェア サンプルから得られたアーティファクトartifact(中間的な生成物を指す用、.IT用語では、プログラマーによって作られたプログラムのソースコードや、ソフトウェアの仕様書など非常に幅広い)などが、そのインジケーターとなる。

「攻撃者は、高度な権限を持つアカウントを利用しようとしたり、侵害したアカウントからさらにより高い権限を持つ別のアカウントへと移ろうとしたりすることが多くなっている。」

「攻撃者は、高度な権限を持つアカウントを利用しようとしたり、侵害したアカウントからさらにより高い権限を持つ別のアカウントへと移ろうとしたりすることが多くなっている。」「クレジット カード情報の収集ツールを発見することは容易ではないが、インストールされたツールで実行されたシステム ファイルの変更を発見することは、比較的簡単にできる。 」

「特定のホストからのDNSリクエストの急増や、外部ホストへのDNSリクエストのパターンの出現は、いずれも危険信号と言える。これらは、外部のだれかがコマンド & コントロール トラフィックを送信していることを意味する可能性が高い。」

「データベースの読み取り量が大幅に増加している場合、データベース内のすべてのクレジット カード番号などのデータを、何者かが異常なほど大量に抽出しようとしている可能性が高い。」

上記いずれも、人工知能にとて、大いに活躍できる領域と見られる。

(人間が読み取れる名前【www.example.com など】 が、コンピュータが相互接続に使用する数字の IP アドレス【192.0.2.1 など】 に変換される。名前と番号のマッピングで管理されている。Domain Name System(DNS)は、いわばインターネットの電話帳のようなもので、ユーザーは、オンラインで情報にアクセスする時に、「nytimes.com」や「espn.com」のようなドメイン名を使用する。

Webブラウザーは、 Internet Protocolインターネットプロトコル(IP)で通信を行う。DNSは、ブラウザがインターネットリソースを読み込めるように、ドメイン名をIPアドレスに変換する。DNS サーバーはドメイン名を IP アドレスに変換することで、エンドユーザーがウェブブラウザにドメイン名を入力した際、どのサーバーにつながるかを管理する。このリクエストを【クエリ】と呼ぶ。

IPとは、インターネットでデータをやりとりするために定められた手順や規約、信号の電気的規則、通信における送受信の手順などの「定められたた規格」を意味する。データパケットがネットワークを経由して正しい宛先に到達できるように、データパケットを異なるメーカーのソフトウエアやハードウエア同士でも、共通のプロトコルに従うことによって、正しい通信が可能になる。インターネットを通過するデータは、パケットと呼ばれる小さな断片に分割される。IP情報は各パケットに添付され、この情報はルーターがパケットを適切な場所に送信するのに役立つ。インターネットに接続するすべてのデバイスまたはドメインにはIPアドレスが割り当てられ、パケットが接続されたIPアドレスに向けられると、データが必要な場所に到着できる。)

ファイアウォールfirewallとは、インターネットと企業内LANの間に設置され、事前に決められたルールを通してよい情報かを判断し、不正アクセスやサイバー攻撃を防ぐ仕組みである。Windowsをはじめ多くのPCでは、最初から本体にファイアウォール機能が搭載されている。これはパーソナルファイアウォールと呼ばれ、インターネットからパソコンへの不正なアクセスやウイルスの侵入を防ぐ効果があるが、企業内のネットワーク全体を防御するためにはファイアウォール製品の導入が必要となる。

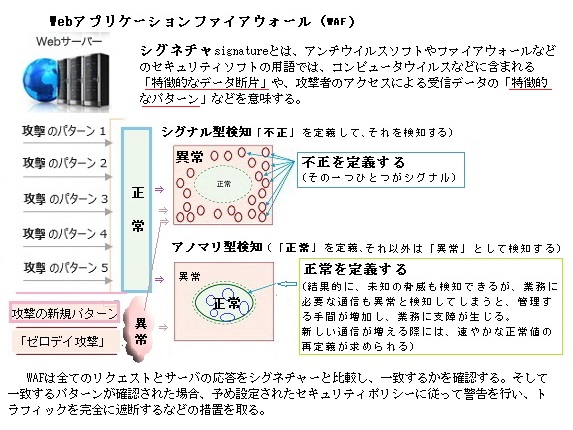

脅威インテリジェンスによって、ファイアウォール、Webアプリケーションファイアウォール(WAF)、セキュリティ情報およびイベント管理(SIEM)システムなどは、その他のセキュリティ製品に当てはめることで、より効果的な脅威を特定しブロックできるようになる。組織がより大きな戦略的決定を下すのに役立つ。Web Application Firewall(WAF)とはWebアプリケーションへの不正なWeb攻撃を防ぐために開発された専用防御ツールである。

このリアルタイムの脅威フィードとの統合により、新しいタイプの攻撃シグニチャーをブロックまたは検知できるようになる。

シグネチャsignatureとは、通常「署名」を意味する。アンチウイルスソフトやファイアウォールなどのセキュリティソフトでは、コンピュータウイルスなどに含まれる「特徴的なデータ断片」や、攻撃者のアクセスによる受信データの「特徴的なパターン」などを意味する。またこれらのパターンを集約したファイルを「シグネチャ ファイル」、シグネチャを利用して攻撃を検知し防御する機能を「シグネチャ機能」と呼ぶ。

現在販売されている大半のWAFは「シグネチャー」からの攻撃を検知し遮断する。各シグネチャーには既に知られた攻撃の構成要素である「パターン」が含まれている。 WAFは全てのリクエストとサーバの応答をシグネチャーと比較し、一致するかを確認する。そして一致するパターンが確認された場合、予め設定されたセキュリティポリシーに従って警告を行い、トラフィックtrafficを完全に遮断するなどの措置を取る。 Webサーバー分野でのトラフィックとしては、外部からの接続要求数やアクセス数、サイト内のWebページを移動する閲覧者の流れなどを指す。

Webアプリケーションは高度化・複雑化している。現状では問題のないプログラムでも、他システムとの連動によってセキュリティの脆弱性が発生し、攻撃の対象となる可能性が生じる。こうしたWebアプリケーションの脆弱性に対処するためにも、ますますWAFを導入する必要性が高まる。

シグネチャー方式のデメリットは、新たな攻撃が発見される度にシグネチャーを追加しなければならないため、頻繁なアップデートが必要になる。最近では一時ごとに新たなシグネチャーが発見されている。そのため、多数の「シグネチャー型検知」が必要となる。しかし、WAFだけで全ての攻撃を記録し、対応するのは事実上不可能である。 しかも、膨大にサーバのリソースを占有するとなれば、Webアプリケーションの全体の性能を大きく落とすことになる。また、未だシグネチャーが対策が作成されていない「ゼロデイ攻撃」などに対応できない。やがて、不要なシグネチャーの数が増えるにつれ、正常なトラフィックまでも遮断する可能性が高くなる。これは誤検知率の上昇に繋がる。そのため、不要なシグネチャー対策を削除する必要があるのだが、すべてのシグネチャーのパターン解析ができるのか、という疑念・危険が想定できる。 このような問題を解決するため、一部のITベンダー(システムやソフトウェアなどのIT製品を提供・販売する会社)は、初段階から数週間程度の機械学習過程の導入などのアプリケーション開発を進めている。

ルールベース(ロジック分析エンジン)による検知方法、つまりロジックベースのWAFは、「事前に定めたルール、つまりロジックをベースに攻撃を検知する方法」である。あらかじめプログラミングされた多種類の攻撃検知エンジンに集約されている。また、個々が独立することで処理の高速化と運用の簡素化を実現している。シグネチャー方式に比べ人手がほとんど掛からず、その一方、テクノロジーを一段と高める技法である。

一般的にシグネチャーは「攻撃のソースコード」で構成されるが、「ルール基盤検知」を活用するWAFは、攻撃パターンを記録せず、その代わりに、様々な攻撃パターンから一定のルールを導き出す。そのロジックベースの検知エンジンを通して「攻撃のソースコード」のパターンを分析し、主に含まれている共通しているコードを探し出す。その結果、数百のシグネチャーが含む多数の攻撃パターンを、一つのパターンに集約することが可能になる。つまり、ルールとは「パターンの更なるパターン化」だと言える。

(IT用語のエンジンengineとは、インターネット上にあふれるWebサイトの中から、ユーザーが探したい情報を見つけるための特定の機能やサービスを提供する「検索窓口」.「画像処理エンジン」.「データベースエンジン」などソフトウェアやシステムなどのプログラムを指すことが多いが、ユーザーの要求仕様に合わせて特定の用途・生産のために開発、設計・製造するカスタムIC【特注の集積回路】などのハードウェアを指す場合もある。

特に、それを利用することが最終目的ではなく、何かをする時に便利となるシステムや、単体では機能・起動せず外部のソフトウェアなどに組み込まれて機能を発揮するような部品化されたソフトウェアなどのことを「エンジン」と呼ぶ傾向がある。

例えば、レンダリングエンジンrendering engineは、画面にテキストと画像を描画するソフトウェアであり、画像を構成する要素やその関連性、描画ルールなどを特定の形式や書式で記述したデータを入力すると、これに従って描画処理が行われて画像が出力される。時系列に連続的に描画を繰り返して動画【アニメーション】を生成することもできる。「render」には「表現する、翻訳する、脚本などを上演するなどの意味がある。)

目次へ

AI活用の準備段階で、実現可能性を確かめる「概念実証Proof of Concept(PoC⇒読み:ピーオーシー/ポック)」と呼ぶ工程がある。「PoC貧乏」「PoC止まり」という言葉に象徴されるように、PoCが頓挫するケースが少なくない。

日本語では「概念実証」と訳されるが、新しい手法などの実現可能性を見出すために、試作開発に入る前に検証に入ることを意味する。実現したいサービスやプロダクトproductの簡易版を作り、実際に使用してみるPoCを繰り返すことで、立てた仮説の実現可能性と有効性・採算性など具体的な検証が行える。検証は、製品の実現性を探るとともに開発時の改善点を洗い出すほか、「開発経費をまかなえる売上予想」などのビジネス的な観点からも重要視される。

(IT用語では、productには、ソフトウェアやデータなど、それ自体には物理的実体のないパッケージ化あるいは標準化されたサービスや、ソフトウェアによって提供されるオンラインサービスのことをある種の商品とみなしてproductに含める。また、オープンソースソフトウェアのように商業ベースでない製作物や提供物などを含む。)

実現できるかどうか分からない製品やサービスの開発に巨額な開発費用や時間を掛けて、結果、失敗したとなれば大きな経営リスクとなる。実現したい製品やサービスの簡易版を作成し、小規模で仮説検証を行うPoCを実施することにより、早い段階で実現可能かどうかの判断ができれば、開発リスクは相当回避できる。

実現できるかどうか分からない製品やサービスの開発に巨額な開発費用や時間を掛けて、結果、失敗したとなれば大きな経営リスクとなる。実現したい製品やサービスの簡易版を作成し、小規模で仮説検証を行うPoCを実施することにより、早い段階で実現可能かどうかの判断ができれば、開発リスクは相当回避できる。

例えば、プリント基板を製造するには、配線としてパターン(銅箔)を形成させたい部分と、絶縁部分とを分ける必要がある。プリント基板は絶縁層の上に薄い銅箔などの導電層で覆い、次のプリント基板上に導電性の配線を形成するパターニング工程で、銅などの導電部分と樹脂などの絶縁部分とに分ける。この分離を行う作業をエッチングetchingと言う。必要のない銅泊部分を除去し、これにより、電気を通さない材料の上に、電気的に繋げたい場所の間を結ぶ配線をはわせることができる。半導体用語では、半導体集積回路などの微細回路を作製する際、不必要な部分を腐食・分解して取り去ることetchingと言う。

エッチングでは、化学薬品などによる腐食作用を利用して表面加工をする。主に金属やガラス、半導体などに、酸・アルカリやイオンの腐食作用を利用して表面を一部削る表面加工をする。この際に配線パターン(銅箔)として残す導電部分などに腐食する薬剤が接触しないようにする工程をレジストresistと言う。実は、レジストとは、基板の表面に薄く塗られている緑色のインクである。基板本来の色は、薄黄色や茶色、パターン部分(銅箔)が銅色である。 その上に緑色のインクを薄く塗る。被処理物表面の一部を樹脂などで保護し、処理をしたあとに保護膜を剥離することで、被処理物の所定の部分のみを処理することができる。

レジストが塗られた部分のはんだsolderははじくので、レジストではんだの載る範囲を限定する。レジストの一番の役割は、はんだ付けの際に余分なはんだが付くのを防ぐことにある。

特段の理由がない限り、レジストは塗っておくほうが良いと言われている。レジストは湿気や空気中のほこりからパターンを守る役割もある。パターン(銅箔)が長年にわたって湿気に晒される、やがて腐食していく。最終的には配線パターン間が短絡(ショート)する。このレジスト手法による保護膜で、短絡リスクをレジストresistする。

半導体製造の前工程におけるエッチングによって、精密な電路を作るため、ウェーハ上に設計どおりの寸法・形状の加工が施される。非常に緻密かつ繊細な電路の作成などが正確に加工できるのは、エッチングならではの生産技法の成果である。

半導体の製造工程に欠かせないフォトレジストphotoresistは、光に反応して変化する感光性材料である。半導体の配線の製造工程では、薄い円盤状の土台、シリコンウェハーにフォトレジストを塗布する。フォトレジストとはPhoto(光)とResist(耐える)の2単語から成る造語で、光に反応してエッチングに耐える性能を持つ、ポリマー・感光剤・溶剤を主成分とする液状の化学薬剤である。フォトレジスト材料は、光を利用して微細な加工を行うフォトリソグラフィ工程で使われる高純度化学薬品であるため、多様な条件に適応する多様な材料が提供されている。その装置も各種提供されている。

感光性のフォトレジストをプリント基板に塗布し、フォトリソグラフィと呼ばれる作業によって、写真を印画紙に焼き付けるように、フォトマスクphotomask(設計図)をフォトレジストに転写する。写真と同様に、現像することで露光した設計図のフォトレジストパターンを形成する。

パターン形成光によって、化学反応した部分を選択的に取り除き(または残し)、光のイメージどおりのパターンを作る。現在は主に希アルカリ水溶液が現像液として用いられる。露光部が溶けるのがポジ型レジスト、未露光部が溶けるのがネガ型レジストという。設計図のパターンを形成するために、各種タイプのフォトレジストに対応した専用現像液に浸漬するなどの方法で不要な部分のレジストを溶解させ除去する。この手法で使われる保護膜をレジストと呼ぶこともある。現像で形成したフォトレジストパターンを保護膜として、フォトレジストのない部分や不要になったフォトレジストを除去するためエッチングする。そのためエッチングを食刻とも言う。その不純物を拡散させる拡散料を塗布したのち、ウェハーを高温で焼成することにより、半導体領域を形成する。その後、洗浄・検査が行われる。

高精度な加工を実現できるエッチングにより、切削やプレス打ち抜きなどの機械成形とは異なり、小型かつ複雑な設計に基づき、非常に繊細で緻密な加工が行える。それは、現代の半導体製造においては、なくてはならない技術と言える。

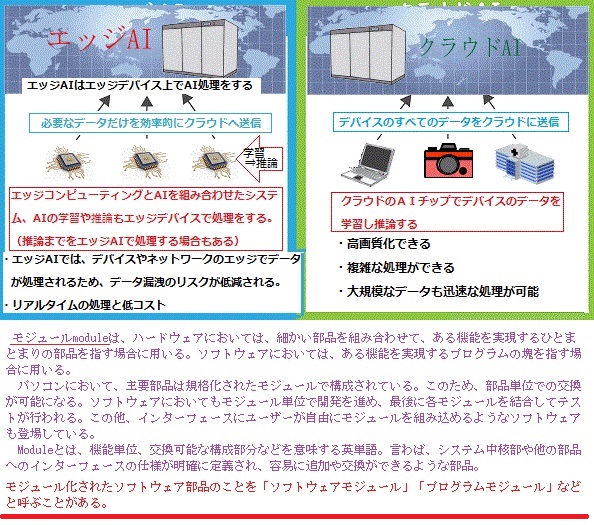

現在のAIは、一般的に、情報を活用する現場(エッジ側)と、クラウド側のサーバーから構成されるInternet of Things(IoT)システムへの実装が前提となっている。通常、AIの「学習」と「判断」の機能は、工場や病院といった現場(エッジ側)から遠く離れたデータセンター内の高性能サーバーの中にある。その一方、エッジ側で収集したデータはネットワーク経由でサーバーに伝送され、膨大なデータがクラウド側のサーバーに蓄積されている。

こうしたクラウド型のAIシステムには、用途の拡大を阻む3つの壁、「データ量の壁」・「エネルギーの壁」・「リアルタイム性の壁」が深刻な課題になっている。

今後10年間に生み出されるデータ量は、現在生産可能なストレージ機器の蓄積容量の10倍以上に達すると予測されている。これが「データ量の壁」である。

ストレージStorageとは、「保管」「倉庫」「貯蔵」を意味する単語、IT用語としては、プログラムやデータを長期にわたり保存、管理するための記憶装置を指す。ストレージの種類としては、USBメモリはもとより、PCに搭載されている「磁気ヘッドを用いて磁気ディスクにデータを記憶する装置hard disk drive(HDD)」や「データの保存場所だけでなく、コンピュータシステムを管理しているOperating System(OS)や各種プログラムなどのインストール先としても用いられる半導体メモリを用いた記憶装置solid state drive (SSD)」などがよく知られている。

電気の力でデータを記録するフラッシュメモリのSSDは、磁気の力で円盤にデータを記録する磁気ディスクのHDDと比べて高速性と静音性に優れているため、使用頻度の高いアプリケーションをインストールするメインドライブには最適である。

HDDは円盤を物理的に高速回転させて磁気ヘッドで円盤上のデータにアクセスする仕組みに違い、SSDではメモリチップ上のデータに直接アクセスする仕組みなため、物理的・機械的な駆動時間が不要になり、データの読み出しにかかる時間が大幅に短縮される。

HDDの駆動部分が、は円盤を回転させるといった物理的動作が必要であるに対して、SSDはフラッシュメモリのため稼働部分がなく、モーターの回転音や読み取り時のシーク音seek sound(カリカリ音)がなくほぼ無音に近い。

また、SSDにはモーターなどの駆動部分がないため、消費電力や故障が少ない。そのため HDDと比べて発熱も低く抑えられ、耐衝撃性にも優れている 。SSDは駆動部品がないため衝撃や振動による耐性が強く、HDDにみられるような故障がない。また、軽量で小型なので、持ち運びの多いモバイル環境に適したストレージである。

価格が比較的高いSSDは、データの読み書きにSDカードsecure digital cardなどと同様の仕組みが使われているが、大容量のデータの記録は難しい。そのため、データ量あたりの単価で、はHDDと比較すると高く、しかも容量自体も多くはない。SSDは大事なデータを安心して長く保管できるのでデータ用に、HDDは一時保存用などに使い分ける事が推奨されている。

Solid stateとは、「固体状態」を意味するが、それが固体状の物質内部で起こる電子現象を利用した半導体や回路を指し、それらの装置を利用した半導体を用いて機械的な可動部やPCで何らかのデータをダウンロードし、保存するとき使用されるのがストレージと言い、ここにデータを格納することで、いつでも必要に応じて呼び出せる機器全般を含むようになった。近年では、オンラインストレージを利用する個人や企業も増えてきた。こちらでは、クラウド上のデータ格納スペースを集中的に利用する。そのこと自体が、「クラウド」が期待するレベルを、遥かに超える現状に至った。

2019年、「国立研究開発法人科学技術振興機構低炭素社会戦略センター」は、情報通信技術Information and Communication Technology(ICT)の利用が活発化し、トラフィックtraffic(インターネット・LAN・電話回線などの回線利用量あるいは送られる情報量)が増加する一方で、ICT関連機器などの電力消費量は益々増加するばかりで、世界のデータセンターの電力消費量は、世界全体の電力消費量の1~2%程度という試算を発表した。

日本のIPトラフィックInternet Protocol traffic(一定時間内に通信回線を経由してやりとりされるデータ量。Protocolとは、インターネットでデータを送受信する際の、定められた手順や規約、それは通信信号の電気的規則や通信における送受信の手順などの規格となる。 これにより、異なるメーカーのソフトウエアやハードウエア同士でも、共通のProtocolに従うことにより、通信が可能になる。)の増加に伴い消費電力が比例するため、2030年にはICT関連機器だけで、現在の年間使用電力量の倍近い電力が消費されると予測されている。今後も消費電力量の爆発的増加が必至となれば、地球温暖化は一段と加速される。これが「エネルギーの壁」として立ちはだかる。

世界のデータセンターの電力消費量は、さまざまな消費領域の中でも最大で、世界の電力の1~2%程度を消費しており、航空業界全体とほぼ同量と見られている。しかも、その電力消費量は、4年ごとに倍増し続けている。特に、IT関連の産業は、中でもCO2排出を急増する分野であり、依然として増加させている。

IoTからAIエッジ・スマートシティー・自動運転車に至るデータ集約型のワークロードworkloadの拡大により、2025年までに1日に463エクサバイトEB(2011年に全世界で生成・複製・保存された情報は1,800EB。地球上のすべての砂浜の砂粒も1,800EB。)が毎日生成されるという現在の予測値は、さらなる拍車が掛かることが指摘がされている。ケンブリッジ大学の分析によると、ビットコインの取引だけで、その電力の消費量はアルゼンチン全土の年間消費量に匹敵すると言う。これが現代社会の実情である。

IoTからAIエッジ・スマートシティー・自動運転車に至るデータ集約型のワークロードworkloadの拡大により、2025年までに1日に463エクサバイトEB(2011年に全世界で生成・複製・保存された情報は1,800EB。地球上のすべての砂浜の砂粒も1,800EB。)が毎日生成されるという現在の予測値は、さらなる拍車が掛かることが指摘がされている。ケンブリッジ大学の分析によると、ビットコインの取引だけで、その電力の消費量はアルゼンチン全土の年間消費量に匹敵すると言う。これが現代社会の実情である。負荷の高いアプリケーションはデータセンターで処理されいるが、AIだけ見ても、世界のデータセンターの電力使用量を2%~10%、さらには15%まで押し上げる可能性があると予測される。かつてないほど接続が増え続ける今日、データを移動させるだけでも多くの電力が必要になっている。

データセンターの総電力量の約30~50%が、冷却のために消費されている。データセンターを冷却するために、通常は、平均温度が20~26.6℃の間に保たれている。モバイルネットワーク事業者ボーダフォンVodafoneは、冷涼なアイスランドの首都レイキャビクにデータセンターを開設した。多くのクラウド企業は、北欧諸国のような再生可能なエネルギー源が豊富で、しかも寒冷な土地にデータセンターを移転し、しかもフィンランドや、デンマーク・スウェーデンなどに風力発電や太陽光発電のエネルギーハブを建設している。

エッジ側とAI機能を実装したサーバーが離れていると、通信速度がボトルネックになる「データ量の壁」、エッジ側で起きた出来事に瞬時に処理できない「リアルタイム性の壁」。

完全自動運転車や二足歩行ロボットのように、エッジ側の状況が目まぐるしく変わる中で、高度な判断を瞬息に下すことが絶対条件であれば、1ミリ秒(1/1,000秒)を超える遅延も許されない。

目次へ

上記の3つの壁は、エッジ側に学習と推論・判断ができるAI機能を置くことができれば打破できる。しかし、既存のマイクロプロセッサーやGPUを使ったソフトウエアベースのAIでは実現できない。要求性能が高すぎて、現在のエッジ側の機器の実装可能な消費電力と大きさのレベルには収まらないからだ。

上記の3つの壁は、エッジ側に学習と推論・判断ができるAI機能を置くことができれば打破できる。しかし、既存のマイクロプロセッサーやGPUを使ったソフトウエアベースのAIでは実現できない。要求性能が高すぎて、現在のエッジ側の機器の実装可能な消費電力と大きさのレベルには収まらないからだ。そこで注目されているのが、AI機能のハードウエア化である。

IBM社、Google社、Apple社、Samsung Electronics社、NEC、富士通など世界中の名だたる企業が、AIチップの開発に注力している。そして世界のトップ囲碁棋士を破って名を馳せたAI「AlphaGo」の実装に利用された「TPU(Tensor Processing Unit)」のような画期的なチップも登場してきた。ただし、先に述べた「3つの壁」を打ち破り、今後数十年間のAIの進化を支えるような決定的な技術は未だ登場していない。

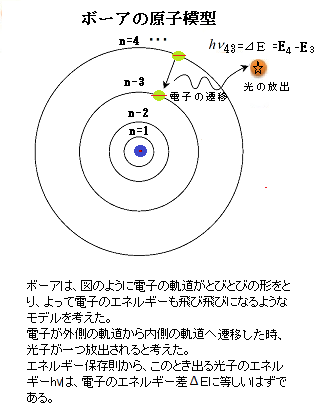

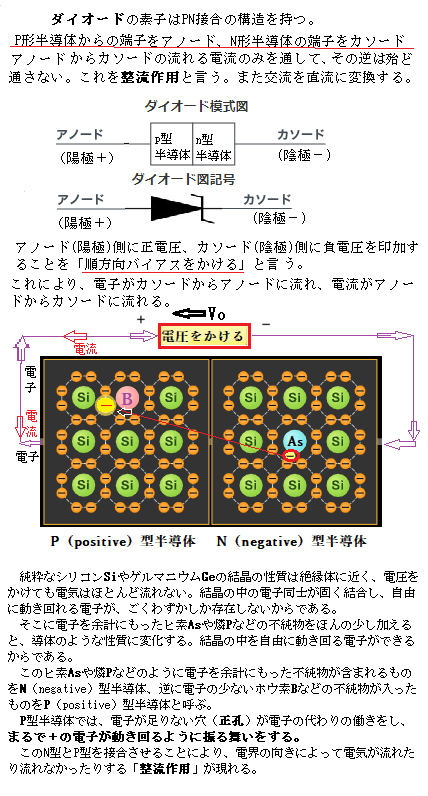

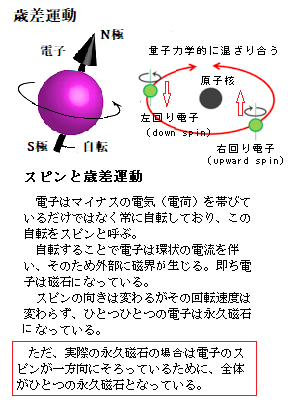

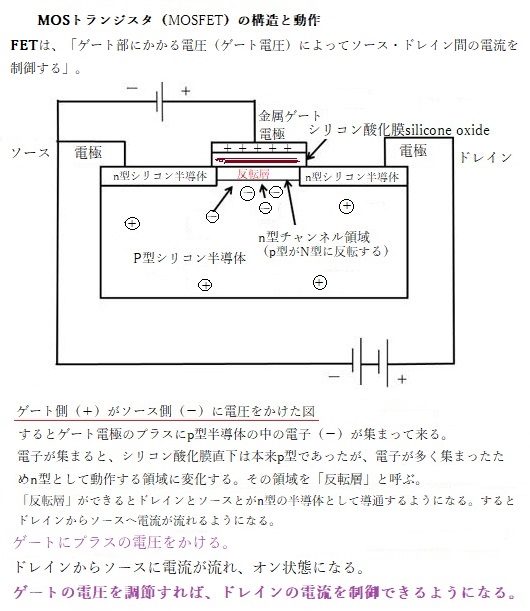

そもそも物質が磁性を持つ根源は、物質中の電子にある。原子核を中心にして、そのまわりを原子番号(陽子の数)に等しい個数の電子が回っている。

陽子と電子は自転している。量子力学では、それをスピンと呼ぶ。それぞれの電子は右回りか左回りに自転をしている。このスピンの角運動量は固定している。

量子力学的には、右回りの電子を「上向きスピンupward spin【up】」、左回りの電子を「下向きスピンdown spin【down】」と呼ぶ。上向きスピンと下向きスピンの角運動量は、お互いを打ち消し合う。この時、「角運動量保存則」により、電子が自転に関わる磁気モーメントを持つと考えられている。しかも、打ち消す相手がいない場合、その原子自体が磁性を持つ。例えば、鉄の中のFe原子は26個の電子のうち、平均として上向きスピンが約14個、下向きスピンが約12個あり、差し引き約2個、上向きスピンが多く存在する。

計算上、1cm3のサイコロくらいの鉄のかたまりの中に、2×1023個のペア相手のいない上向きスピンがあることになる。この上向きスピンによって、鉄は磁性を持つ。このようにスピンの数に差がある物質、すなわち磁性体は稀である。私たちの体内にも数え切れないほどの電子が存在するが、生体内には反磁性体(水・皮膚・内蔵が代表例)、常磁性体(酸素・血液・骨など)が各種存在する。細胞内 の構成成分から推 察する と90%以上が反磁性体 という ことになる。

エレクトロニクスは電流や電圧を信号や情報として利用する技術である。電流・電圧は電子の持つ「電荷」から生じるものであるが、電子は電気を帯びている電荷のほかに内部自由度である「スピン」をもっている。「スピン」には「up」と「down」という2つの状態がある。金や水など、身の回りの多くの物質中には2つのスピン状態が同じ量だけ存在しているが、鉄やニッケルなど、片方のスピンが多く集まる物質は「磁石」と呼ばれている。 つまり、スピンは微小な磁気モーメントとして振る舞うため、スピンの向きも信号・情報として利用できるはず。 その電荷だけでなくスピンも利用したエレクトロニクスをスピン・エレクトロニクス、あるいはスピントロニクスspintronicsと呼ぶ。

近年、実際にスピンを利用した電子デバイスが多く提案され試作されている。スピントロニクスは次世代エレクトロニクスの候補として注目されている。

(2012年1月、金にも磁石になる性質、常磁性があることを発見された。金に非常に強い磁場をかけたときに、上向きスピンの数がわずかに多くなるという現象が測定された。ただ「金がもつ常磁性の性質はとても弱いので、反磁性に覆い隠されていた」と言う。

東京大学は2023年8月1日、強磁性の半導体量子井戸構造semiconductor quantum wellに、大型放射光施設【SPring-8】によるパルスレーザー光を照射し、超高速で瞬時に磁化を増大させることに成功した。新しい磁化制御法は、半導体トランジスタ技術に応用しやすく、半導体と磁性体の異なる特長と機能を融合する半導体スピンデバイスにて、入出力を超高速かつ低消費電力で制御する新たな道を開いたことになる。)

既に、電子工学は半導体と磁性体によって支えられている。これらは、かつては、別々に使われてきたが、半導体の世界と磁性体の世界に橋が架かることにより、新しい世界が拡がった。これは電子のもつ電荷だけではなく磁性の元となるスピンの特性を利用するスピントロニクスが、これまでになかった全く新しい現象や素材を開発したり応用したりする研究分野として大きく成長したことによる。両者を物質レベルで融合し、磁性を持つ半導体を作成することに成功している。

既に、電子工学は半導体と磁性体によって支えられている。これらは、かつては、別々に使われてきたが、半導体の世界と磁性体の世界に橋が架かることにより、新しい世界が拡がった。これは電子のもつ電荷だけではなく磁性の元となるスピンの特性を利用するスピントロニクスが、これまでになかった全く新しい現象や素材を開発したり応用したりする研究分野として大きく成長したことによる。両者を物質レベルで融合し、磁性を持つ半導体を作成することに成功している。ヒ化ガリウム(GaAs)やインジウムヒ素(InAs)などの磁性を帯びないIII-V族化合物半導体(さんごぞくかごうぶつはんどうたい)が、高速トランジスタやレーザに使われている。

これに磁性不純物であるマンガン(Mn)を高い濃度まで添加すると、自然界にはない強磁性を示す半導体ができることが発見された。つまり、普通の半導体が磁石にもなることが示されたのである。そしてこの現象により、半導体において電子が不足した状態でありながら、キャリア(正孔)の濃度によって、強磁性相互作用が決まると言う理論が明らかになった。これをキャリア誘起強磁性と言う。

(「III-V族化合物」とはIII族元素【周期表において第13族に属する元素の総称】とV族元素【周期表において第15族に属する】で構成される化合物。III族元素にはホウ素B、アルミニウムAl、ガリウムGa、インジウムInなどがある。化合物半導体を構成するのは主にAlとGa、Inであり、特にGaが使われることが多い。V族元素には窒素N、リンP、ヒ素As、アンチモンSbなどがある。化合物半導体を構成するのは主にNとP、As、まれにSbが使われる。

初期半導体に使われるのは、ゲルマニウムGeとケイ素Siは、IV族【周期表において第14族に属する元素】)に含まれる)

その後、電界(電圧がかかっている空間の状態)により、キャリア濃度を増減させられる電界効果素子構造を用いて、強磁性半導体中のキャリア濃度を変化させ、同じ温度のまま強磁性-常磁性相転移のどちらの方向にも転移できる電界制御を可能にした。

また保磁力や 磁化ベクトルの方向も電界で制御できることが示された。磁性体の磁気的性質を、温度を変えることなく可逆的に変化させられる。これは紀元前数世紀にギリシャで天然磁石が発見されてから、現在に至る長い磁性体の歴史の中で、初めて実現した現象であった。

物質は電子を通す「導体」と電子を通さない「絶縁体」、そして、ある条件によっては電子を通す「半導体」とに分かれる。

電気を通す、通さないは電子が移動することができるかどうかによる。バンドギャップとは電子が存在することのできない領域(禁制帯)のことである。バンドギャップが無い「導体」の代表は、鉄・銅・銀・金・アルミニウムなど金属系の物質である。電子が簡単に移動できるため、電気を通すことができる。

逆にバンドギャップが大きい「絶縁体」を、油・ガラス・ゴム・セラミックなどが代表する。バンドギャップが大きいため、電子が移動できず、電気が流れない。

「半導体」はバンドギャップが小さく、その「半導体」に不純物を混ぜることで電子や正孔の流れを制御することができる。

物質は電子を通す「導体」と電子を通さない「絶縁体」、そして、ある条件によって電子を通す「半導体」に分かれる。「導体」「絶縁体」「半導体」の違いは、バンドギャップの幅の違いによる。「半導体」はバンドギャップが小さく、「半導体」に不純物を混ぜることで電子や空孔(正孔)の流れを制御することができる。

量子井戸quantum wellとは、分子線エピタキシーepitaxy(超高真空下で成分元素または構成分子を分子線として結晶基板上に真空蒸着させる。これにより原子一層の精度で製膜する。)などの方法で、母体の半導体に層状に埋め込んだ構造を周期的につくると、バンド・ギャップの異なる半導体同士の半導体超格子となる。その層は、垂直方向で井戸型ポテンシャルとなり、その自由度によりエネルギーは量子化する一方、層の面内方向は自由運動なので、一種の2次元電子系となる。

量子井戸quantum wellとは、分子線エピタキシーepitaxy(超高真空下で成分元素または構成分子を分子線として結晶基板上に真空蒸着させる。これにより原子一層の精度で製膜する。)などの方法で、母体の半導体に層状に埋め込んだ構造を周期的につくると、バンド・ギャップの異なる半導体同士の半導体超格子となる。その層は、垂直方向で井戸型ポテンシャルとなり、その自由度によりエネルギーは量子化する一方、層の面内方向は自由運動なので、一種の2次元電子系となる。高輝度で高い色純度の光を発光させられる量子ドットquantum dotの実体は、硫化カドミウムCdSやセレン化カドミウムCdSeに代表される直径数nmの半導体微粒子である。

最近は、粒子の中心部と外層で元素の組成が変わるコアシェル型と呼ばれるタイプも増えている。その色は量子ドットの寸法を変えることでさまざまに変えられる。これは、量子ドットの「バンドギャップ」と呼ばれる半導体の性質が、その粒子の寸法によって変わることに起因する。

異なる半導体の境界面に存在する2次元電子系に対して、周りを削って柱状になる井戸の厚さやドットの直径をnm程度にすると、量子効果が顕著になり、特異な電子の輸送、電子相関効果や光物性(2次元励起子を用いた量子井戸レーザーなど)が生じるので、基礎物理だけでなく半導体デバイスにも広く用いられている。

それは、電子を数㎚程度の半導体の薄膜のヘテロ接合hetero-junctionによって閉じ込めた構造を持つ。ヘテロheteroとは、「他のor 異なった」などの意味であるから、「ヘテロ接合」とは 「異なった物質間の接合」である。通常、「ヘテロ接合」と言うと異なった半導体同士の接合を指す。「ヘテロ接合」には、p-n、n-p、p-p、n-nの4種類がある。

「ヘテロ接合」によるキャリアの閉じ込め効果を、積極的に量子面・量子細線・量子箱それぞれに閉じ込まれた電子を、新しい電子デバイスとして、積極的に研究開発されている。

「量子井戸」も「ヘテロ接合」の利用である。現在、開発されている量子効果デバイスは、すべて「ヘテロ接合」が利用されている。

半導体中のキャリアの速度は、印加電界が低 いときには電界に比例する。しかし、電 界が高くな るに従 い、速度の増加率は衰え、十分に高い電界領域では、速度は、電界領域に依存せず一定値となり、その値が飽和速度になる。GaAs(ガリウム砒素)はIII / V族半導体の一種であり、シリコンに比べて高い電子移動度と高い飽和電子速度を備えている。バンドギャップが広く、高い動作周波数であても、シリコンデバイスよりもノイズが少なく、高周波デバイスとして多用されている。例えばご く薄 い2種類の半導体結晶を規則正 しい周期 で交互に積み重ねた構造を持つ半導体超格子 、例えば、GaAs薄層(数nm)の両側をAIAs(ヒ化アルミニウムガリウムAIGaAs)で 挟むと、GaAsの伝導帯に「量子井戸」が形成される。

複数の元素を組み合わせた化合物半導体という材料がある。例えば、GaAs(ガリウム砒素)を含む化合物半導体は、単結晶の単元素半導体と比べると、結晶欠陥が多く割れ易いため、半導体の材料になる板 (ウェハ) を大口径化するのが困難である。また、Siに比べるとと、原材料や製造のコストが高くなるいうデメリットもある。

しかし、そんな化合物半導体には、高速信号処理が可能という大きな利点が生じる。電子の移動度が高い事から、高周波信号を扱う通信機器の高性能化を図るのに適している。このため、携帯電話や基地局、衛星通信といった通信装置にはGaAs半導体が多く使用されている。

電子は薄膜の面の垂直方向に自由に移動できず、特定の離散的なエネルギー状態をとる。この厚さを変えたり、複数重ねたりすることによって新しい機能をもつ素材を作ることができる。青色発光ダイオードや半導体レーザーなどに利用される。

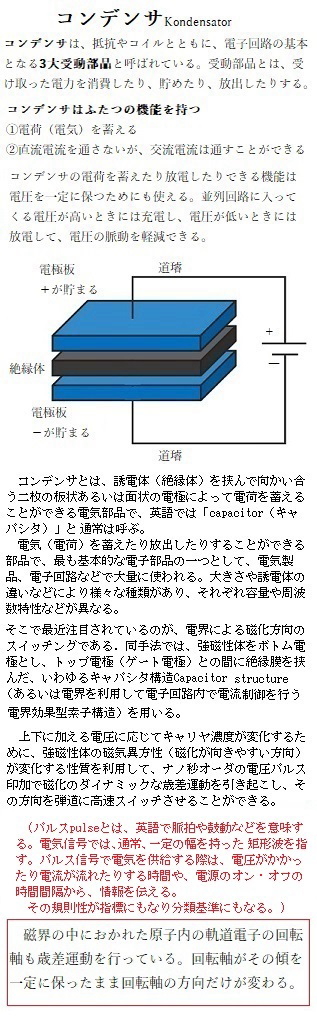

キャパシタ構造

集積回路や発光素子などに使われている半導体は、本来磁石の性質を持たない材料であるが、磁性原子を添加することによって磁石になる「強磁性半導体」を作製することができる。

集積回路や発光素子などに使われている半導体は、本来磁石の性質を持たない材料であるが、磁性原子を添加することによって磁石になる「強磁性半導体」を作製することができる。強磁性半導体の有する磁石としての性質は、正孔密度に強く依存することが明らかになった。強磁性半導体をキャパシタ構造に加工して電圧を印加することで正孔密度を変化させ、磁石の状態(強磁性)と磁石ではない状態(常磁性)を切り替えることができる。近年では、金属材料においても磁石の性質が電圧印加により変化することが見出され、室温動作可能な超低消費電力メモリデバイスの実現に向けて盛んに研究が行われている。

強磁性体ではり隣合った原子の間に磁気モーメントの向きをそろえようとする相互作用が働く。 そのため、各原子の磁気モーメントの向きが自発的にそろい、磁場をかけなくても磁化を持つ。これを自発磁化と言う。

ただ、強磁性体は自身で磁束からなる複数の還流磁区構造を作り、磁種から生じた磁気の漏れを防ぐ。そのため外部に磁極を露出できないから磁束も発生できない。しかし、外部磁場が加わると磁壁が移動して磁区の方向がそろい、初めて磁極ができて磁石になる。強磁性体が必要とされている最も大きな理由は、自発磁化を持つためである。自発磁化の向きは、ハードディスクや磁気抵抗メモリなどで情報のビット(bit)として用いられ、その大きさすなわち磁力は、例えばモータの性能を決める重要な要素となる。したがって、磁化の向きや磁力を制御する手法の効率化は、強磁性体を用いたデバイスの高性能化につながる。

磁化方向の制御には、外部から磁界を加える手法や、上向きスピンと下向きスピンの差がスピン偏極した電流を注入する手法がある。どちらも、磁気抵抗メモリの書き込み動作においては、非常に高い密度の電流を導線や素子自身に加える必要があり、その低減は 1 つの重要課題といえる。そこで最近注 目されているのが、電界による磁化方向のスイッチングである。同手法では、強磁性体をボトム電極とし、トップ電極(ゲート電極)との間に絶縁膜を挟んだ、いわゆるキャパシタ構造Capacitor structure(あるいは電界を利用して電子回路内で電流制御を行う電界効果型素子構造)を用いる。

上下に加える電圧に応じてキャリヤ濃度が変化するために、強磁性体の磁気異方性(磁化が向きやすい方向)が変化する性質を利用して、ナノ秒オーダの電圧パルス印加で磁化のダイナミックな歳差運動を引き起こし、その方向を弾道に高速スイッチさせることができる。

「磁気異方性が変化する」という意味は、電圧を加えているときだけ、その強磁性

体にとっての実効的な磁界(異方性磁場)の方向が変化(例えば、膜面垂直方向から面内方向などへ変化)するということである。この場合、磁化方向をスイッチングするために

は、キャパシタ構造に電圧を加えることによる電荷の充放電電流しか必要としないため、既存の手法に比べ、桁違いに低い消費電力での書き込み動作が期待される。

強磁性体をボトム電極にもつキャパシタ構造でも、ゲート電圧を加えることにより、絶縁膜に接した強磁性体表面で電荷の充放電(「充放電」は主にバッテリーに対して使われるもので、「充電」と「放電」をひとつにまとめた言葉)が起こり、キャリヤ濃度が増減する。キャリヤ濃度に磁気特性が依存する素子としてよく知られているのが強磁性半導体である。

III - V 族の化合物半導体に マンガン(Mn)をヘビードープheavy dope(dopeとは、半導体を製造するときに加える不純物)した強磁性半導体を用い、その強磁性・常磁性・保磁力・磁化方向などを電界制御することに成功している。半導体における磁性の電界効果 の研究は精力的に続いていた。その後、半導体よりも桁違いにキャリヤ濃度が高い強磁性金属材料においても、超薄膜において同様な電界効果が室温で観測されるにようになった。

(スピントロニクスの技術を用いて低消費電力化と高速化を両立させ、電源を切っても記憶した情報が消えない不揮発性メモリの実現が期待されている。USBメモリは、半導体メモリの一種で、電気的にデータの消去や書き換えができる不揮発性のメモリと言われている。SDカードやSSDなども同様である。

USBメモリは、メモリチップ内部に電子を保持して情報を記録している。乾電池が自然放電するように、保持した電子が少しずつ漏れ出すので、無通電の状態が長期間続くと記録した情報が消失していく。意外にも、USBのデータ保持期間は、一般的に5~10年と言われている。

ハードディスクHDDの保存期間は5~10年と言われるが、モーターや読み取りヘッドなど可動部品が多いため、保存環境による機械的故障のリスク方が高い)

そのメモリセルmemory cellとは、半導体メモリにおいて情報を記憶、読み書きする最小単位となる回路を構成する基本素子を指す。組合せ回路は、ある入力信号によって信号が出力され、入力信号が取り去られると元の状態に戻る。

フリップフロップflip-flop回路は、電気回路の一種で、入力信号を取り去っても、その出力状態を維持し続ける。フリップフロップ回路の中で最もシンプルなのが、コンピュータのデータで、すべて「0」と「1」を組み合わせた2進数の値として扱う。「0」と「1」の値によって1ビットの情報を表現し、それを保持する回路と言える。メモリセルではこれを電荷の有無など何らかの電気的あるいは磁気的な状態に対応付けて記憶する。つまり、メモリセルに対して、外部から配線を通じて供給される電力と電気信号によって記憶の保持や読み込み、書き換え、消去などを行うことができる。

フリップフロップflip-flopとは、元々、パタパタという擬音や「トンボ返り」という意味をもった英語である。

メモリチップは半導体基板上に微細な大量のメモリセルと配線を敷き詰めた構造となっている。数センチ角の半導体チップの内部に数百万から数十億にも及ぶメモリセルを配線とともに形成したものがメモリチップmemory chipで、そのチップを電子基板にいくつか並べて実装し配線したのがメモリモジュールmemory moduleとなる。それを一つの単位として、コンピュータの主基板(マザーボードmotherboard)などにある専用の差込口(メモリソケットmemory socket)に挿入して、プログラムやデータを一時的に蓄えておくための装置で、CPUの命令で直接アクセスできる装置メインメモリmain memoryどとして使用される。そのメインメモリがコンピュータのメモリ装置やストレージ装置の記憶媒体として用いられる。

メモリチップは半導体基板上に微細な大量のメモリセルと配線を敷き詰めた構造となっている。数センチ角の半導体チップの内部に数百万から数十億にも及ぶメモリセルを配線とともに形成したものがメモリチップmemory chipで、そのチップを電子基板にいくつか並べて実装し配線したのがメモリモジュールmemory moduleとなる。それを一つの単位として、コンピュータの主基板(マザーボードmotherboard)などにある専用の差込口(メモリソケットmemory socket)に挿入して、プログラムやデータを一時的に蓄えておくための装置で、CPUの命令で直接アクセスできる装置メインメモリmain memoryどとして使用される。そのメインメモリがコンピュータのメモリ装置やストレージ装置の記憶媒体として用いられる。(モジュールmoduleとは、機器やシステムの一部を構成するひとまとまりの特定の機能を持った部品で、システム中核部や他の部品へのインターフェースの仕様が明確に規格化され、容易に追加や交換ができる完成された重要部品である。

moduleとは、機能単位、交換可能な構成部分などを意味する英単語である。他の構成要素と繋いだり、組み合わせて使用するための規約や仕様が、要素自体の仕様とは別に独立して定義されている点も重要な特色である。

高度にモジュール化が進んだ工業製品の代表としてはパソコンがあり、CPUやメインメモリ、マザーボード、ストレージ、入出力装置といった機能単位ごとに専門のメーカーがいくつもあり、購入時に適合部品を選んで組み合わせたり、後から最新の部品に交換して機能や性能を向上させることもできる。

このような重要な構成部品を組み合わせて全体を構成する手法を「モジュラー型」設計と言う。)

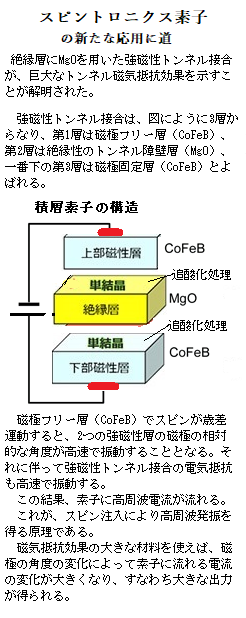

磁気トンネル接合magnetic tunnel junctionとは、2つの磁性体の層(磁性層magnetic layer)の間に非常に薄い絶縁層を挟んだ構造を取る。スピントロニクスの応用分野の一つスピントロニクスデバイス構造の一つである。電子には、電荷を持つという性質の他に、「スピン」という磁石の性質も持つ。これらの二つの性質を両方とも利用した工学応用や新しい物理現象を研究する分野が、「スピントロニクス」である。

東北大学大学院安藤研究室は、1994年に、「世界で最初に室温で大きなトンネル磁気抵抗効果Tunnel Magneto Resistance Effect(TMR効果)」を観測した。「TMR効果」とは、2つの強磁性体電極と薄い絶縁膜(トンネル障壁)からなる素子(TMR 素子)に磁界を加えると素子抵抗が変化する現象で、電子の持つ電荷とスピン(磁気)の両方を活用する「スピン トロニクス」分野の最重要技術に成長した。この発見が契機となり、トンネル磁気抵抗素子をHDD用の磁気ヘッドや磁気メモリー(MRAM)に応用するための研究が急速に進展したと言われる。この現象に代表されるように、電子の電荷とスピンの性質を最大限に利用して、新しい電子デバイスの創出を目指す分野がスピンエレクトロニクス (スピントロニクス) と呼ばれる。

電子の持つスピンと電荷を同時に利用して高機能な素子の開発を行うスピントロニクスという研究分野が急速に発展している。磁性体でもある電子による歳差運動によるマイクロ波に対応する周波数振動を、高周波技術へ応用することが期待されている。既に、巨大磁気抵抗素子による高周波の発振は観測されている。しかし、出力が1nW以下と小さく、現状での実用化には画題が多い。

磁気抵抗効果とは、試料に磁場を印加した時に(例えば磁石を近づけた時に)、試料の電気抵抗が変化する(電気の流れ易さが変わる)現象を指す。磁気抵抗効果が発現する原因は、アップスピンとダウンスピンで電子の運動(抵抗)が異なるためである。アップスピン電子は、電気が流れ易い、つまり動き易い。ダウンスピン電子は、電気が流れ難い、つまり動き難い。

電極の間に電圧をかけると、障壁を超えて電子が流れ込んでいくトンネル効果tunnel effect という現象があるが、二つの磁性層の磁化方向が平行ではない場合には、平行な場合に比べ、絶縁層を通したトンネル抵抗が大きくなる。このトンネル磁気抵抗効果tunneling magneto resistance(TMR)を利用して、メモリーデバイスを構成することができる。

非常に薄い絶縁体の薄膜を2枚の強磁性体で挟んだ素子は強磁性トンネル接合 (TMR素子) では、その量子トンネル効果によって電子が薄い絶縁体を透過 (トンネル) し、電流が流れる。強磁性トンネル接合では、アップスピンとダウンスピンで電子が絶縁体を透過する(トンネルする)確率が異なることにより、2枚の強磁性体の「磁化の向きが平行のときに電流が流れやすく」、「反平行のときに流れにくく」なる性質として現れる。この現象が「TMR効果」で、電流の流れやすさの変化率はトンネル磁気抵抗比Tunnel magnetoresistance ratio(TMR)と呼ばれ、強磁性トンネル接合素子の最も重要な性能指数となる。

2009年頃、磁性層や絶縁層の堆積技術の進歩、特に酸化マグネシウム絶縁層により、この特性が大幅に改善された。磁気トンネル接合は微細化も可能で、磁気ランダムアクセスメモリーmagnetic random access memory(MRAM)に組み込むことによってその性能を向上させたことから、次世代不揮発性記憶素子non volatile memory deviceの本命として、研究開発が盛んに行われている。

磁性層に磁化方向を書き込む方法としては、ワード線word line(配列されたメモリーを制御するための信号を担う配線)に電流を流し、その磁場で書き込む従来の方法に加えて、一定方向の電子スピンを有する電流を注入して、そのスピントロニクスspin torqueを応用分野の一つとしてスピントロニクスデバイスを完成させる。

Spin torqueの活用分野が急速に広がっている。2つの強磁性体で絶縁体を挟んだ構造から成り、強磁性体の磁化の相対角によって抵抗値が変化する特性を示すため、抵抗値の違いをビット情報に割り当てることでメモリとしての応用が可能となる。ギガビット級メモリの安定・高速・低電力動作の実現を目指し、磁気ンネル接合に用いる材料およびデバイス特性に関する研究が蓄積され、世界最高のトンネル磁気抵抗(TMR)比(電流の流れやすさの変化率であるため高速性の指標となる)を示す、直径11 nmの磁気トンネル接合素子の作製(世界最小)に成功している。

物質・材料研究機構(NIMS)は2023年4月、素子界面を精密に制御することで、室温トンネル磁気抵抗(TMR)比が世界最高となる631%に達したと発表した。この成果は、磁気センサーの高感度化や磁気ランダムアクセスメモリー(MRAM)の大容量化につながるとみられている。トンネル磁気抵抗(TMR)比は、素子における抵抗変化の大きさを示し、この値が大きいほどセンサーの感度やメモリの集積度を高めることができる。ところが、2008年に公表された604%を最後に、室温TMR比の値は更新されていなかった。

物質・材料研究機構(NIMS)は2023年4月、素子界面を精密に制御することで、室温トンネル磁気抵抗(TMR)比が世界最高となる631%に達したと発表した。この成果は、磁気センサーの高感度化や磁気ランダムアクセスメモリー(MRAM)の大容量化につながるとみられている。トンネル磁気抵抗(TMR)比は、素子における抵抗変化の大きさを示し、この値が大きいほどセンサーの感度やメモリの集積度を高めることができる。ところが、2008年に公表された604%を最後に、室温TMR比の値は更新されていなかった。NIMSの研究グループは、磁性層と絶縁層の界面を精密に制御することで、従来の課題を解決した。まず、全ての層を単結晶で作製し、磁性層と絶縁層との界面に極めて薄い金属マグネシウムを挿入した。具体的に磁性層はコバルト鉄合金を用いるスパッタリング法sputtering methodで作製した。

(「スパッタsputter」という言葉は、1590年代、「閃光を発する、爆音を立てて吐き出す」という意味であった。オランダ語の sputterenも同源になる。金属同士をアーク溶接によって接合するとき、小さな金属の粒が火花となって飛び散るが、この小さな金属の粒もスパッタと呼ばれている。つまり、スパッタには小さな粒子が飛び散る様子を表現する言葉で、スパッタリング法も同じように小さな粒子を弾き飛ばすことによって皮膜材料を飛ばし、皮膜を作る。

1970 年に、Peter J. Clarkeが、電子とイオンの衝突を利用して原子スケールのコーティングをターゲット表面に堆積させる最初のスパッタデバイスを発表した。

スパッタリング法では、密閉空間にコーティングしたい物質と、皮膜材料(ターゲット材料)を設置し真空にする。この状態でAr(アルゴン)ガスを導入し、ターゲット材料をマイナス電極としてグロー放電glow dischargeすることでArをイオン化する。 イオン化したArはプラスの電気を帯びているため、マイナス電極のターゲット材料に急速に引き寄せられ激しく衝突する。このとき、Arイオンの衝突によってターゲット材料の原子を弾き飛ばす。弾き飛ばされたターゲット材料の原子は、コーティング対象の物質に付着しながら堆積していき、皮膜を形成する。これがスパッタリング法によって皮膜を形成する原理である。

グロー放電は、低圧気体中で生じる持続的な放電の現象で、放電管【ガラス管】の両端に電極を封入し、放電管内の気圧を低圧【数パスカルPa】にして、電極間に高電圧を印加すると、グロー放電が生じる。

1 Paは、1 m2の床の上に、約100gのリンゴが置かれているくらいの力 )

一方、絶縁層は酸化マグネシウムMgOを用い、電子線蒸着法で作製した。材料に応じた手法を用いることで、絶縁層内原子による磁性層の汚染を抑えることに成功した。

絶縁層にも工夫を加えた。下界面には厚みが0.6nmという極薄の金属マグネシウムを挿入した。上界面には上部磁性層を積層する直前に、微量の酸素ガスを吹き付けた。こうした制御によって、上下界面における酸素の量が適切に調整され、急峻な界面を実現することができた。

また、今回開発した最高性能を示した素子では、絶縁層の膜厚によって室温トンネル磁気抵抗(TMR)比が振動して変化する、「TMR振動」が現れることも確認した。今回得られた室温のTMR振動幅は141%で、従来よりも極めて大きいと言う。

この現象はトンネル磁気抵抗素子の基本技術を一層進展させるヒントとなり、この成果は磁気センサーの高感度化や磁気抵抗メモリの大容量化の筋道を拓くことになる。

本研究は、主に国立研究開発法人新エネルギー・産業技術総合開発機構 (NEDO) による「電圧駆動不揮発性メモリを用いた超省電力ブレインモルフィックシステムの研究開発」の委託業務の一環として得られたと言う。

強磁性体中の磁区と磁区の間には磁化の向きが遷移する領域に、磁壁が形成されいる。電流を流すと、電流を担う伝導電子と磁化を担う局在電子間でスピンの角運動量が受け渡されて、電子が流れる方向に磁壁を移動させることができる。

この電流誘起磁壁移動を用いて不揮発性メモリに応用したものが磁壁移動デバイスで、読み書きに用いる電流経路が異なることから、安定・高速動作が期待されている。このようなデバイス応用を念頭に、磁壁移動の物理と集積化技術に関する研究を行われている。

半導体微細加工技術を用いて、電流を印加して作製した磁性細線は、その長さ方向に電流を流すことで情報を記録した磁区を高速で移動させることができる。磁性細線のこの特性を利用することで記録デバイスの小型・軽量化や高速化が実現できると期待されている。

磁性細線の厚さ方向にN極とS極が生じる材料を用いて作製した垂直磁化磁性細線では、ある磁区から漏れた磁力線は隣接する逆向きの磁区へそのまま入り、閉じたループを形成する。このような磁力線は磁区を極めて安定に保つことができる。また、記録密度を高くしても、隣接する異なる磁極の磁区が近くになり、磁力線がより小さな閉ループを形成するため、磁区の相互間がより強固になる。安定性は一段と向上する。

垂直磁化を示す材料は、コバルト/白金・コバルト/パラジウム・コバルト/ニッケルなどの積層膜か、コバルト-クロム合金・テルビウム-鉄-コバルト合金などのコバルト系合金か、酸化鉄を主成分にする一部のフェライトなどに限られている。

物質・材料研究機構は、垂直容易磁化材料であるCo/Ni(コバルト・ニッケル合金)を用いて、線幅20nmの磁性細線による磁壁移動を観測している。

半導体を用いたスピントロニクスspintronicsは、非磁性の半導体に磁性をもつ遷移金属イオンを希薄にドープdope(不純物を注入)した「希薄磁性半導体」の研究に端を発する。 80年代末から90年代初頭にかけて、ガリウムヒ素などの半導体にマンガンをドープした希薄磁性半導体が強磁性を示すことが日本の研究者によって発見され、半導体スピントロニクスが新しい実験物理学分野として一気に開花した。

最近の新しい展開としては、非磁性物質におけるスピンの振る舞いが興味を集めている。 磁性イオンも、強磁性体も、磁場もなくても、電子が運動すればスピン-軌道相互作用により「有効磁場」を感じ、上向きスピンの電子と下向きスピンの電子は逆方向の力を受ける。

このため、電流を流すと電流とは垂直方向に、電荷の流れを伴わない「スピン流」が生じ、これをスピンホール効果と呼ぶ。

最近の新しい展開としては、非磁性物質におけるスピンの振る舞いが興味を集めている。 磁性イオンも、強磁性体も、磁場もなくても、電子が運動すればスピン-軌道相互作用により「有効磁場」を感じ、上向きスピンの電子と下向きスピンの電子は逆方向の力を受ける。

このため、電流を流すと電流とは垂直方向に、電荷の流れを伴わない「スピン流」が生じ、これをスピンホール効果と呼ぶ。 スピン流やスピン-軌道相互作用に起因する物理の研究はここ数年、トポロジカル絶縁体の研究、スピンゼーベック効果を用いた横型熱電発電素子の研究なども含めて急速に発展しており、その振舞いや機構などの理解がますます深まり、スピントロニクスの実用化の段階に至った。

トポロジカル絶縁体とは、物質の内部は絶縁体なのに、その「エッジ」、つまり2次元系なら端、3次元系なら表面に金属状態が必ず存在する。トポロジカル絶縁体は、従来の絶縁体・半導体・金属という分類の枠に当てはまらない、表面は導電体、中は絶縁体という新物質として注目を集めている。

ドイツの物理学者トーマス・ヨハン・ゼーベックThomas Johann Seebeckは、1821年、2つの異なる金属を使った回路で、金属同士の2箇所の接点に温度差を設けると、方位磁針が振れることを発見した。温度差によって電位差(電圧)が生じ、それによって閉回路に電流が流れたのである。今日ではこれをゼーベック効果Seebeck effectと呼ぶ。

スピンゼーベック効果は、スピン流(電子が持つ磁気的性質であるスピン【角運動量】の流れ)を利用した新たな熱電変換現象であり、そのスピンゼーベック効果を用いた新しい形の熱電発電素子が開発された。

ゼーベック効果は、熱電効果の一種で、異なった2種の金属導線を連結し、二つの接点を異なる温度に保ったとき、両接点間に電位差が発生する。この熱起電力現象をゼーベック効果と呼ぶ。

この素子の高温側は太陽光で加熱され、低温側は放射冷却で冷やされる。生じた温度勾配によりスピン流(磁気の流れ)が生じ、温度勾配の垂直方向に起電力が発生する。放射冷却は夜間でも有効であるため、定常的に温度勾配が維持され、発電が継続できる。

スピントロニクスを応用したメモリー素子である磁気トンネル接合magnetic tunnel junction(MTJ)素子を採用したAIチップが開発された。MTJは、 磁性体(磁化固定層)/ 絶縁体 / 磁性体(磁化自由層)の三層構造からなる接合で、二つの磁性層magnetic layerの間に非常に薄い絶縁層を挟んだ構造で、抵抗が二つの磁性体の磁化の相対的な向きにより変化するメモリ素子である。

磁化が平行な場合、抵抗が小さく、磁化が反平行な場合、抵抗が大きくなる。電極の間に電圧をかけると、障壁を超えて電子が流れ込んでいくトンネル効果tunnel effect という現象が生じるが、二つの磁性層の磁化方向が平行ではない場合には、平行な場合に比べ、絶縁層を通したトンネル抵抗が大きくなる。このトンネル磁気抵抗効果tunneling magnetoresistance effect(TMR効果)を利用して、メモリーデバイスを作製することができる。

つまり、抵抗値を測定することによって、1ビットのデータを読み出すことができる。また、磁化自由層の向きを反転させることによって、データを書き込むことができる。記憶・学習処理に適した磁気トンネル接合MTJと、判断処理に適した相補型金属酸化膜半導体complementary metal oxide semiconductor (CMOS)とを組み合わせることによって、これまでに企業が開発したAIチップよりも高性能かつ低消費電力を実現している。

真のAI時代を迎える突破口となるかと、今後の開発の成果が期待されている。

(CMOSの回路構造で最も基本的な「インバーターInverter回路」では、0を入力すると1、1を入力すると0を出力する。このCMOSは消費電力が小さく高速動作が可能であることから、スマホやデジカメなどのカメラの目となるイメージセンサーに使用されている。

直流から交流に変換するインバータは、交流から直流に変換する整流回路Converter【順変換回路】とは対の存在と言える。インバータは、半導体素子のスイッチング動作によって直流の極性を、そのタイミングで切り換えることで、正負両方の値をもつ交流に変換する仕組みである。)

世界中を飛び回るデータは今後も指数関数的に増えていく。2020年には35ZB(ゼタバイトzetta bytes)になると予想されている。ゼタzetta(記号: Z)は、10の21乗倍を示す。

その何割かは保管しなければならないから、ハードディスクの高密度化・大容量化が求められている。

目次へ