量子コンピューター

リンク

| TOP | 車山高原お知らせ | 車山高原ブログ | 歴史散歩 | 旅ネット信州 |

『古事記』は偽書にあらず

古代メソポタミア

古代メソポタミア史

ヒッタイト古王国時代

ヒッタイトと古代エジプト

ギリシア都市国家の興亡

細胞化学

DNA

遺伝子発現の仕組み

ファンデルワールス力

生命の起源

アポミクシス

植物の色素

植物の運動力

遺伝子の発現(1)

遺伝子の発現(2)

元素の周期表

デモクリトスの原子論

相対性理論「重力」

相対性理論「宇宙論」

相対性理論「光と電子」

素粒子の標準理論

太陽系の物理

半導体

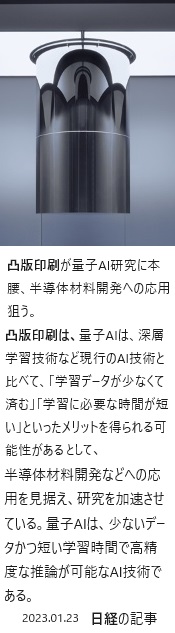

AI半導体

AIチップ

機械学習

植物の進化史

量子コンピューター

が

| 「車山山頂」から蓼科山と白樺湖を見下ろす秋景色 | ||

|

|

|

| 車山高原のススキ野を散策し、白樺とナナカマドの紅葉の森で遊ぶ | ||

| 目次 |  |

| 1)次元の異なる量子コンピュータとは? | |

| 2)量子コンピューターの大きすぎる課題 | |

| 3)「量子誤り訂正符号」と「量子誤り抑制(ノイズ補償)手法」 | |

| 4)「重ね合わせ」と「量子もつれ」 | |

| 5)従来と量子コンピューターが未来を切り開く | |

| 6)ハイブリッド量子アニーリング | |

| 7)量子と古典とのハイブリッドが未来の都市を作る | |

| |

|

ビッグデータ解析や深層学習など多量のデータから知見を引き出す技術は、AI活用の原動力となっている。しかし、有用な知見を導き出すためには、膨大となる可能性の高いデータの組合せを調べる必要がある。コンピューターの計算において、問題を解く上で必要な条件や要素の組み合わせが増加することで、計算量や計算時間が、問題の規模により指数関数または階乗(1 からある数までの連続する整数の積を計算)に比例して大きくなるため、有限時間内で解けなくなる場合が生じる。この組み合わせ的爆発に対して現在最高性能のコンピューターでも、その組合せの全てを効率的に解析することが困難になっている。この「組合せ爆発combinatorial explosion」の対策に期待されるのが、量子力学の原理をフルに活用する量子コンピューターの存在である。

IBMは、実際の量子システム上で実行するための量子回路から量子プログラムやアルゴリズムの開発まで、量子コンピューティングの基本的な構成要素を解読し、改良している。2017年5月に最先端の量子コンピューター「IBM Quantum Computing(IBM Q )システム」を公開すると同時に、商用向けの量子コンピューターのプロトタイプprototype(試作モデル)を構築すべく新たなロードマップを策定した。

その一般公開されている「IBM Q システム」が、ハードにおいては量子コンピューターの中でもっとも性能が高いようで、東大は2021年7月、国内初となる汎用型のIBM製量子コンピューターを川崎市内の施設に導入した。また2023年の今秋にも、川崎市内の研究施設に米IBM製の最新鋭の量子コンピューターを設置する。性能の目安となる「量子ビットqubit」の数は127で、国内に置かれるものとしては最高となる。バッテリー開発などへの応用が期待され、トヨタ自動車や三菱ケミカルグループなどが参加する産学協議会が利用する。実用化に向けた研究が国内で一段と進む。

その一般公開されている「IBM Q システム」が、ハードにおいては量子コンピューターの中でもっとも性能が高いようで、東大は2021年7月、国内初となる汎用型のIBM製量子コンピューターを川崎市内の施設に導入した。また2023年の今秋にも、川崎市内の研究施設に米IBM製の最新鋭の量子コンピューターを設置する。性能の目安となる「量子ビットqubit」の数は127で、国内に置かれるものとしては最高となる。バッテリー開発などへの応用が期待され、トヨタ自動車や三菱ケミカルグループなどが参加する産学協議会が利用する。実用化に向けた研究が国内で一段と進む。IBMの開発者は、分子そのものの挙動をシミュレーションsimulation(実物による実験が様々な要因により不可能か困難な場合、あるいは長い期間や多くの費用を要する場合などに、コンピュータによる数値計算や情報処理を用いて複雑な物理現象や人工物の振る舞いなどを再現するコンピュータシミュレーションcomputer simulationを言う)できる効率的なアルゴリズムを英科学誌ネイチャーに発表している。複雑な化学反応のシミュレーションや最適化を通して、医薬品や材料、エネルギー分野などでの応用が期待されている。この実機により、量子コンピューターがシミュレートできる最大の分子の最高記録を達成した。

「IBM Q」の登場によって長らく理論の領域にとどまっていた量子コンピューターが、漸く実用化に向かい、今まで計算できなかった様々な問題の解析が進展すれば、新たな突破口となり、AI活用の領域などに、更なる拡大が期待できる。

中長期的な応用としては最適化や機械学習がある。特に「組合せ最適化問題」は、交通・情報通信・製造・金融・製薬といった実社会の様々な業種において多大な功績をもたらす。

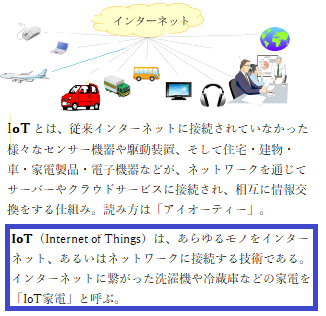

そのため、IoT社会やサイバー空間と現実空間を高度に融合させるシステムにより、経済発展と社会的課題の解決が両立する人間中心の社会(Society5.0)の実現と、IT・デジタル技術の発展により、これまで提供できなかった新しい価値が次々と創起され、競争上の優位性を確立することや、ビッグデータなどのデータとAIやIoTを始めとするデジタル技術を活用して、製品やサービス、業務を改善していく。さらにビジネスモデルそのものを変革するとともに、競争上の優位性を確立するDigital Transformation(DX)の推進などにより、組合せ最適化高速処理技術が革新されていく。

(「DX」とは「Digital Transformation」と表記される。また「trans」には「cross」、つまり「交差する」の意味があり、「cross」を略して「X」と書かれるようになった。)

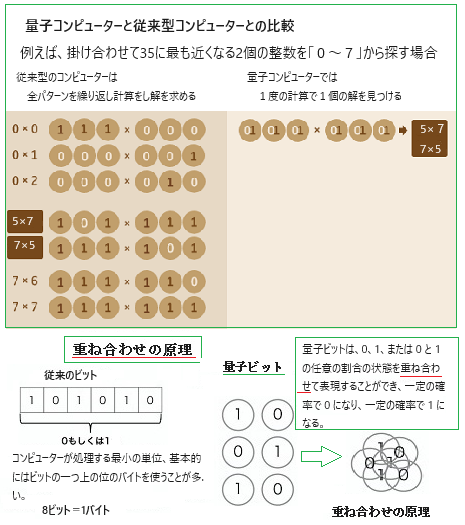

従来のコンピューターのアルゴリズムよりも、ほとんどの場合、量子アルゴリズムの方が高速に処理できると期待されている。量子アルゴリズムとは、量子力学の原理を使って問題を解く方法であり、量子力学という物理を使うことによって、かつては計算が難しかった問題が、少ない計算量で解けるようになる。そのような高速化を可能にしたのは、量子コンピューター特有の「量子重ね合わせ」と「量子もつれ」の効果である。

この「重ね合わせの原理」が量子コンピューターの基本的な原理となっているが、量子力学でも基本原理としても認識されている。

この「重ね合わせの原理」が量子コンピューターの基本的な原理となっているが、量子力学でも基本原理としても認識されている。量子コンピューターは既に稼働している。IBMクラウドサービスが2017年に提供した世界で初めての量子計算プラットフォームがIBM Quantum Computing(IBM Q)と呼ばれるサービスがある。ニューヨーク州にある大規模な冷却施設で管理されるこの量子コンピュータは無料で誰でも使うことができる。IBM Quantum Computingは、シミュレーターsimulatorと量子コンピューターへのアクセスは、パルスPulse・回路やアルゴリズムalgorithmのレベルで、IBM Cloudを介して容易に利用できる。

IBM Quantum Networkには、日本をはじめとする世界中の企業や研究所・研究施設、そしてスタートアップ企業が参画し協力している。IBMが提供する量子コンピューター「IBM Q」は世界最大規模のネットワークを形成する。

JSR株式会社、株式会社三菱UFJ銀行、株式会社みずほフィナンシャルグループ、三菱ケミカル株式会社、慶應義塾大学、東京大学など、100社を超えるIBM Quantum Networkコミュニティのメンバーが、この量子システムを利用して、金融サービス、材料開発、物流、化学などの分野で、これまで想像もできなかったような方法で難問に取り組んでいる。

IBM Quantum Networkでは、30台以上の量子コンピューターが既に稼働している。商用環境では最大かつ最強の環境と言える。これは、未だシステムを1,000量子ビット以上にスケールアップするための、開発途上にある過ぎないことを示す。

カナダブリティッシュコロンビア州バーナビーを拠点とする量子コンピュータ企業のD-Wave社の量子アニーリングマシンでは、2021年現在、5000量子ビットの実装までできている。

古典的なコンピューターのビットは、「0」か「1」の値で認識するが、量子ビットは「0」でもあり「1」でもあるという認識、つまり「重ね合わせ状態」で、計算量と能力を飛躍的に増大させる。

(東京大学は、NTTや情報通信研究機構、理化学研究所の研究チームと共同で、量子光のパルス波形を自在に制御する新たな手法を開発した。

量子は、非常に小さな電子や光子、もしくはそのような素粒子がもつエネルギーの単位であり、その量子も当然、粒子と波の性質を併せ持つが、加えて複数の物理的状態や挙動が共存するような「重ね合わせ」や「量子もつれ」など非自明性nontriviaを示す。

このような量子特有の性質を強く示すような光子を量子光と呼ぶ。これに対し、レーザーなど従来の光源が発する【電磁場の波動】は古典的な光と呼ぶ。)

アルゴリズムとは、「問題を解決するための手順や計算方法」を指す。「算法」と呼ばれることもあり、解を求めるときの手順を具体的かつ明確に公式として示したものと言える。つまり、アルゴリズムとは、その手順に沿っていれば誰でも同じ解が得られるものを指す。

アルゴリズムを実現すれば、量子コンピューターは大量で複雑に入り組んだ計算を高速に処理できる。その処理手順を少し変えるだけでも、処理時間が大幅に短縮できる可能性を秘めている。これが量子コンピューターのアルゴリズムに注目が集まる理由になっているが?

理化学研究所(理研)が2023年3月27日に、量子コンピューターの国産初号機の稼働を開始した。この理研の初号機の開発には富士通やNTTも参加し、政府も国費を投じて支援してきた。

インターネット上のクラウドサービスで公開している。企業や大学などに利用してもらい、将来の産業応用に向けた知見を蓄積していく方針による。

量子コンピューターは米中が先行している。日本も開発競争に名乗りを上げ、巻き返しを狙う。2025年度には、100(2100)量子ビット超の次号機の開発を予定している。

国内では2021年に神奈川県・川崎市に米IBM製の量子コンピューターを設置しているが、国産機の設置・稼働は最初となる。性能の目安となる「量子ビット」は理研製が64で、IBM製の27量子ビットを上回っている。64量子ビットは2の64乗の計算ができるということを意味する。

量子コンピューターには、未だ大きな課題と壁が立ちはだかる。計算の際にエラーが生じることなど、米中も技術的な課題を抱えている。その一方で、複雑な問題をスーパーコンピューターの1億倍以上のスピードで解く可能性を秘めている。

量子コンピューターの用途には、化学・素材開発(半導体材料・人工光合成・太陽光発電など)、自動車・物流(EV用電池の高性能化や走行ルートの最適化、自動運転など)、金融(ポートフォリオの最適化やリスク評価)、製薬(画期的な新薬開発)など期待は大きい。

目次へ

量子コンピューターの開発が、世界的に加速している。先行するのは米IBMや米Google、そして理化学研究所などが手掛ける超電導方式だが、日本でも様々な研究機関や企業が、多方式の量子コンピューターの研究開発を進めている。

しかし、超伝導方式などの既存の各ハードウェア方式では、量子ビット数の大規模化に対応できる新しいハードウェア方式の開発が困難となっている。既存のハードウェア方式では、単ユニットで106~108物理量子ビットの規模まで拡大すると極めて困難となるため、スケーラブルな分散型量子コンピューティング方式の開発が必要になると想定されている。

2019年に、IBMは世界初の統合された量子コンピューティング・システム、IBM Quantum System Oneを発表した。その後、IBMはこれらのシステムをクラウド経由で利用可能なIBM

Quantumサービスを提供すると共に、ドイツのフラウンホーファー研究機構や日本の東京大学向けに稼働させていた。フラウンホーファー研究機構は、この量子コンピューティング・システムが、新しい将来の産業応用への道を開くと考えた。

2019年に、IBMは世界初の統合された量子コンピューティング・システム、IBM Quantum System Oneを発表した。その後、IBMはこれらのシステムをクラウド経由で利用可能なIBM

Quantumサービスを提供すると共に、ドイツのフラウンホーファー研究機構や日本の東京大学向けに稼働させていた。フラウンホーファー研究機構は、この量子コンピューティング・システムが、新しい将来の産業応用への道を開くと考えた。2021年11月16日、IBMは、量子計算・量子通信・量子計測に関する量子エコシステムの領域拡大を紹介するための年次イベントIBM Quantum Summit 2021において、新しい127量子ビットの「Eagle」プロセッサーを発表した。「Eagle」は量子物理学に基づいたデバイスで、大規模な計算も可能となる画期的なプロセッサーになると表明した。

2023年4月21日、東京大学とIBMは、127量子ビットのプロセッサーを搭載した量子コンピューター「IBM Quantum System One with Eagleプロセッサー」を、本年中に「新川崎・創造のもり かわさき新産業創造センター(以下、KBIC)」にて稼働開始予定であると発表した。127量子ビットのEagleプロセッサーを搭載した量子コンピューター「IBM Quantum System One」が、北米以外の地域で初めて稼働する。

IBMは2022年5月、超電導量子コンピューターの規模拡大の具体的な道筋を示すロードマップを発表していた。ロードマップによると、IBMは今後1枚のチップに搭載する量子ビットの数を増やすとともに、モジュール化した複数のチップの接続によるネットワークによって、2025年には4158量子ビットを実現すると発表した。

量子コンピューティングでは、量子状態ベクトルのベクトル空間の次元が量子ビットの数と共に指数関数的に増大するため、計算能力が著しく向上する。しかしながら、1 個の量子ビットは簡単にモデル化できるが、50量子ビットの量子計算をシミュレートすると、おそらく既存のスーパーコンピューターの限界を超えほどになる。

1つの新たな量子ビットだけ増やすと、状態の格納に必要なメモリが2倍になり、計算時間が約2倍になる。比較的少数の量子ビットを使用する量子コンピューターが、今現在、また将来の最も強力なスーパーコンピューターをはるかに超えることが期待されているのも、この急速な計算能力の増加力による。

(観測とは、観測者が対象の物理量の一時の1つの値を得る行為にすぎない。それでも、量子論では、このとき初めて粒子の物理量の値が確定すると言う。だが、量子の本質により、ゆらぎを含むので厳密な測定値は必ずしも得られない。粒子の座標や運動量を測定する場合でも、試行回数を増やしてその平均値から推定するしかない。

粒子の物理量を観測すると、確かなその値が得られたという古典的な描像とは大きく異なり、量子論では、電子の位置・運動量を観測しても、それは、「ある瞬間の位置・運動量を測定するということ」であれば、その後の時間発展は確率分布で捉えことになる。その後の物理量の正確な値は、その都度ごとの測定により与えられる。

しかし、量子論における確率分布は確定できる。それでも、量子論では、物理量・測定値・系の状態を分離してとらえたことにする。)

Googleは2021年5月に発表したロードマップで、2029年までに100万量子ビットを搭載した「量子誤り訂正」ができる量子コンピューターを開発するとした。巨大な希釈冷凍機内に100万量子ビットを格納し、1,000個の物理量子ビットで1つの論理量子ビットを作り出すことで、実用性を備えた1,000論理量子ビットの量子コンピューターを開発する計画と言う。

データセンターのサーバーや宇宙探査機などのあらゆる通信技術には、誤り訂正が必要となっている。クオンティニュアムQuantinuum(世界最大級の量子コンピューティング企業)やその他の量子コンピューティング企業にとって、量子誤り訂正は、その技術開発における最も重要な達成目標のひとつでる。エラーが生じれば、当然ながら量子コンピュータに対する信頼性が失われる。

Quantinuumの研究員は、誤り訂正やエラーを目標レベルまで抑制するという画期的な新技術・新製品などの開発を目指している。

量子の基本的な物理的性質から、ほとんどの古典的な誤り訂正の原理は、量子コンピュータには適応できないと言われている。ノイズを非常に小さなレベルまで抑制することは、極めて困難であるが、量子計算の開発には避けて通れない重要課題である。最も有望な解決案は、量子誤り訂正で、物理量子ビットを、論理量子ビットにすることにある。

論理量子ビットは、計算を実行するために連携する物理量子ビットのグループである。計算で使用される各物理量子ビットに対して、他の補助的量子ビットが、発生したエラーの発見や修正など、さまざまなタスクを実行する。

2021年の論理量子ビットを用いた研究をベースでの最新の研究では、量子誤り訂正と2つの論理量子ビットを用いたQuantinuumの研究チームが成果を上げている。

量子コンピューターや量子ネットワーク実現のために、もっとも必須となるのが「量子誤り訂正」の技術である。量子情報処理と既存の古典情報処理で起き得るノイズ量には莫大な差がある。従来の古典情報処理ではエラーが起きる頻度が極めて小さいため、それほどエラーを気にせず多くの情報処理が可能であった。

量子情報処理の方では、エラーが起きる頻度が多すぎるため、エラー対策なしで行える計算は小さな規模のものでしかない。今後は、量子情報処理の性能や機能を柔軟に向上させ、有用なさまざまな計算能力を高め、大きなネットワーク化を実現することが、必須条件となって立ちはだかって来る。

量子の持続時間とは、量子ビットの状態をどれだけ持続出来るかの時間を示す。これをコヒーレンス時間coherence timeと呼び、計算処理がその時間内に完了しなければ、量子状態が崩れてノイズ発生の原因となり、計算精度が低下する。量子コンピュータでは、ちょっとしたノイズやエラーで計算結果が狂うので、それが重要な性能指標となる。

(量子ビットの状態はノイズに弱く、とても壊れやすい。一定時間経つと、量子ビットの重ね合わせの状態が全て壊されてしまう。 量子コンピューターが、量子ビットの重ね合わせ状態を失うと、確率的に0か1のどちらかしか取らない古典コンピュータのビットと同じようになり、量子コンピューターたらしめる特性を失う。この量子性を保つ時間をコヒーレンス時間という。)

量子情報の誤り耐性処理を行い、エラーやノイズから量子情報を強固に保護できるアーキテクチャarchitectureが、量子コンピューティング技術およびネットワーク技術の根幹部分となっている。

量子情報処理のための誤り対処法としては大きく分けて2つの手法がある。それが「量子誤り訂正符号」と「量子誤り抑制(ノイズ補償)手法」である。「量子誤り訂正符号」は、量子ビットを冗長に符号化することによって、一部にエラーが起きても復号して訂正が可能となる手法である。この手法は多数のファイルや多数のユーザ、多種多様なアプリケーションに対応できる、スケーラブルscalableな誤り耐性処理が可能となる唯一の手法であり、将来的に規模の大きな量子情報処理の実用化のために必須な技術となる。

しかし、符号化のために必要な量子ビット数や処理数の増加がネックとなり、これによる誤り耐性処理の実現が少し先になると考えられている。そのため、それまでに開発必要な1つの技術として注目されているのが「量子誤り抑制(ノイズ補償)手法」である。これは量子ビット数にオーバヘッドoverheadが生じない正しい計算結果を予測することで、計算結果から誤りを取り除こうとする技術である。この誤りのない計算結果の予測のために計算処理のコストが増加し、スケーラブルほどにならないか、量子ビット数のオーバヘッドに至らないか、未だ量子情報処理の規模が小さい間における重要な開発技術と目されている。一方で、実装する要素技術そのものが可能な限り精度が高いことや、ネットワーク処理や分散処理における機能が高いことも重要である。

(overheadとは、プログラミングや計算機科学分野では、何らかの処理を行う際、その処理を行うために必要となる間接的な処理や手続き、またそれに要する機器やシステムへの負荷、新たに費やされる処理時間なども指す)

量子コンピューターは物質の「重ね合わせ状態」を利用して、さまざまな情報処理を可能にするが、その代償としてノイズに対して脆弱となる。

量子コンピュータの「重ね合わせ状態」を使い、さまざまな未来のシナリオを同時に計算しようという目標が基本的なアプローチの.先にある。ただ、現在の量子コンピュータは、そのノイズの影響を受け、量子ビットにエラーが発生する。このエラーを解消する訂正技術が未完成であるため、エラーのない理想的な量子コンピュータを前提にした量子アルゴリズムをそのまま使っても本来の性能は発揮されない。

また、理論上は圧倒的な処理能力を持つと言われ、本格導入に向けた研究が進むが、これまでに開発された中規模の量子コンピューターの単位命令あたりの量子ビット数なども考えると、実用レベルに達するのは数十年先とまで言われている。

また、従来型と比べると量子型は開発製造コストが高く、実際問題として従来型で対応できないほどの計算を必要とする機関自体も少なく、未だ特殊な機関や一部企業に限定的に導入されている。

量子情報処理においても、いかに効率的に優れた「誤り耐性処理」を行うかという観点から、誤り耐性量子計算のソフトウェアの開発研究が続けられている。また、設備実装のアーキテクチャ自体の精度を高め、効率を良くし、いかに機能を拡大するかという観点からの開発も進められている。それでも、十分な規模の大きさと「誤り耐性量子コンピューター」の最終的な実現は、未だ遠い未来の彼方にあると予想されている。

スーパーコンピューターは、従来のノイマン型コンピューターvon Neumann architectureの最高峰にあるが、別名プログラム内蔵方式ノイマン型コンピューターstored-program computerと呼ばれる。プログラムをデータとして記憶装置に格納し、これを順番に読み込んで実行するコンピュータであり、基本構成は普及品のパソコンと同じである。言わば、計算手順や入力値をハードウェア本体から独立させてデータとして外部から与え、汎用の回路群でこれを処理する方式を採用している。これによりコンピュータプログラム(ソフトウェア)という概念が誕生した。

ノイマン型コンピュータでは、現代ではCPUとして単一の装置になっている演算装置および制御装置と主記憶装置main storageの間の伝送路(バスbus)を通じて命令やデータを運んでおり、その律速が性能の隘路bottleneckになりやすい。

単にバスといった場合はCPUなどのICチップ内部やチップ間、電子基板上のデータ伝送回路を指すことが多いが、コンピュータ本体と周辺機器の接続や、コンピュータ間の接続についても、一つの伝送経路を複数の機器で共有する方式をバス型接続、バス型ネットワークと言うことがある。

ノイマン型コンピュータでは主記憶装置に命令が置かれているため、次の命令を実行するためには必ずバスを通じて主記憶装置から命令を取り出さなければならない。CPU内部の処理性能がいくら向上しても、主記憶装置からの読み込み速度が追いつかなければ読み込み待ち時間が長くなるだけで性能の向上には繋がらない。

現代のコンピュータではこの問題を緩和するため、CPU内部に高速に読み書きできる少容量のキャッシュメモリcache memoryを内蔵し、これをさらに何段階も階層的に設ける(1次キャッシュ/2次キャッシュ/3次キャッシュなど)。これは、CPUの処理速度を低下させないために、メインメモリmain storageにあるデータをあらかじめいくつかのキャッシュメモリに移して置くことで、高速のデータ入出力を可能にする。これにより、さまざまな命令やデータを何度も繰り返し主記憶装置から取り出ことによるに律速性能を弱める隘路の発生 を回避する。

一方、量子コンピュータは、従来型とは全く異なる原理で構成されている。それぞれに得手、不得手があり、現段階では量子コンピュータの能力が発揮できるのは特定の計算処理に限られている。また、量子素子はきわめて脆弱で、演算を繰り返すうちにエラーが生じやすい大きな欠陥がある。これを解決するには20年はかかるといわれており、「組み合わせ最適化問題」に特化した「量子アニーリングマシン」を除いては実用化の見通しはたっていない。その一方で、スーパーコンピュータにはあらゆる分野に対応できる優れモノで、既に多方面で活用されている。

それでも、量子コンピュータは小型で、冷却装置を含めても電力消費が極めて小さいというメリットがあり、環境性能という観点からも量子コンピュータの実用化が望まれている。

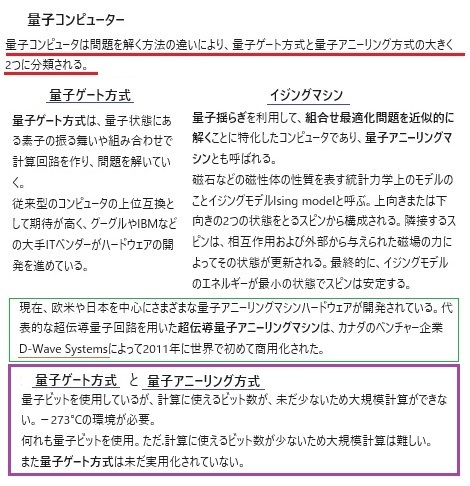

量子コンピュータには、「ゲート方式」と「アニーリング方式quantum annealing method」がある。その中でも、量子アニーリングマシンは組合せ最適化問題に特化したマシンである。

量子コンピュータには、「ゲート方式」と「アニーリング方式quantum annealing method」がある。その中でも、量子アニーリングマシンは組合せ最適化問題に特化したマシンである。企業では人員配置やシフトの割り当て、スケジュール、生産計画の最適化などは永遠のテーマとも言える。

量子アニーリングマシンの出現により、デジタル化への大きな画期となり、最適化というキーワードが、非効率だった仕事のターゲットの数を減らすことで、アニーリングによる成果を評価しやすくもする。

量子アニーリングマシンの登場により、意外な発想から、あらためて組み合わせ最適化問題を解くことの有効性が、近年ビジネスシーンで大きな関心を集めるようになった。

最近では、組み合わせ最適化問題以外に量子アニーリングマシンの応用範囲が拡大し、材料開発・創薬・製造・交通・物流・金融などの分野で注目されている。

そもそも最適化とは、数多くの候補から一定の基準で正解を探す。しかも、正解があるかどうか分からないまま探索していく。その過程で、新たな発見につながるかもしれない。

例えば、現在のネット広告では、顧客が過去に購入し、興味を示した商品・サービスに関連するものを提示することが主流のようだ。仮に、今までのパターンに当てはまらない、顧客に潜在する嗜好に沿う商品・サービスを提示できれば、新たな需要を掘り起こせる。量子アニーリングマシンは、新しい提案型の装置として使えるのでは?

量子アニーリングマシンの分野では、1999年設立の比較的新しい企業であるカナダのD-Wave Systems社がトップを走っている。2,020年10月には、驚異の5000量子ビットを超えるスケールの最新機種D-Wave Advantageをリリースした。次は7000量子ビットを超えてくると、期待注目されている。D-Wave Systems社は量子アニーリングマシンに続き、2021年秋には、汎用性が高いプログラミングが可能な「量子ゲート方式」の量子コンピュータ開発にも着手することを発表した。「量子ゲート方式」はあらゆる量子計算を構築する目的で作られ、量子効果を自由で積極的に活用することで量子計算の強さを引き出しやすくすると言う。

量子アニーリング方式は、組み合わせ最適化問題を解くことに特化している。多数の選択肢があるなかで、もっとも良い組み合わせを選ぶことが可能なうえに、高速で解くことができると期待されている。量子ゲート方式と比較するとシンプルな構造であるため、ハードウェアの開発がしやすいと言う。

東北大学発ベンチャー企業の株式会社シグマアイとD-Waveは、デンソーや京セラなどの企業と参画し、津波などの災害時の避難経路の最適化といった量子アニーリングの応用研究を進めている。

産業応用をさらに推し進めるため、2019年6月に東京都にD-Wave Japan株式会社を設立した。世界で唯一量子コンピューターを販売している会社である。公表された顧客には、リクルート・コミュニケーションズ、豊田通商株式会社、デンソー、早稲田大学、東北大学が含まれいる。

目次へ

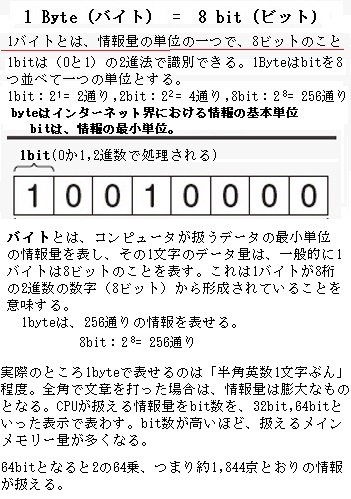

量子ビットqubitには、量子力学が働くから、従来コンピュータの「ビット」とは、その物理的な振る舞いは互いに相当異なる。従来コンピュータは、CPUの中にあるトランジスタという電気的なスイッチを使用して計算を行う。スイッチには、電流を流すONの状態と電流を流さないOFFの状態があり、このONとOFFを2進数の「0」か「1」の数字に置き換え、情報の最小単位「ビット」として計算処理を行う。

量子ビットも「ビット」と同様に、何らかの物理的な素子の状態を使って0、1の情報を表現する。「ビット」と異なる点として量子ビットは、「量子重ね合わせ」と「量子もつれ」と呼ばれる「二つの量子性」を持つ。量子コンピュータはこの2つの量子の性質を利用したアルゴリズムに基づいて処理するため、従来コンピュータの計算処理と比較して計算ステップ数を大幅に減らすことができると言う考え方である。しかし、量子性を保ちながら安定性を維持することができる量子ビットを作ることは非常に難しく、現在も世界中で量子ビットに関する研究開発が行われている。まさにその途上にある。

量子ビットも「ビット」と同様に、何らかの物理的な素子の状態を使って0、1の情報を表現する。「ビット」と異なる点として量子ビットは、「量子重ね合わせ」と「量子もつれ」と呼ばれる「二つの量子性」を持つ。量子コンピュータはこの2つの量子の性質を利用したアルゴリズムに基づいて処理するため、従来コンピュータの計算処理と比較して計算ステップ数を大幅に減らすことができると言う考え方である。しかし、量子性を保ちながら安定性を維持することができる量子ビットを作ることは非常に難しく、現在も世界中で量子ビットに関する研究開発が行われている。まさにその途上にある。量子は、我々が良く知る日常の世界とは異なる物理現象が引き起こす。それが「量子力学」として体系的に整理されている。この量子を観測すると、一つの状態だけではなく、同時に複数の状態を取る可能性があたりまえのようにある。これが「量子重ね合わせ」と呼ばれる。

「量子コンピューター」を例にすると、1ビットは通常0もしくは1のどちらかの状態になるが、量子の世界では、0でもあり1でもあり測定してみなければわからない、ということが寧ろ「当たり前」となる。つまり、量子は、0という状態と1という状態を同時に取り得る量子の世界である。

「量子の物理法則は、それが実体であるとしか言えない」。つまり、実験により証明された物理現象であるが、論理的に説明しかねる世界である。普段、身の回りにある物理法則(ニュートン力学や電磁気学)は通用せず、「量子力学」と呼ぶ不思議な法則に従っている。

「量子もつれ」は、量子同士の強い結びつきから生じる現象である。一旦、二つの量子に「量子もつれ」の関係が生じると、どんなに遠く引き離されても、なぜかその関係が維持される。例えば、片方の量子の状態が変化すると、それに応じてもう一方の量子も瞬時に変化することが観察されている。

オーストリアの物理学者アントン・ツァイリンガーAnton Zeilinger博士は、1997年、量子が通じ合う「光子の量子もつれ」を利用し、ある素粒子の状態を、離れた場所にある別の素粒子に「瞬間移動」すことを「量子テレポーテーション」の実験により証明した。それは量子自体の「瞬間移動」ではなく、遠く離れた別の量子に、その瞬間ごとに自己の状態を「瞬間移動」させているとしか思えない特殊な現象であった。

「量子の世界」では、光子や電子など量子同士は、非常に強力な相関関係を維持している。一方の粒子の性質が観測によって確定すると、もう一つの粒子の性質も、どんなに離れていても瞬時に連動する。これが、双子のペアのように、二つの粒子の間で互いに関係しあう「量子もつれ」という不思議な現象であった。

例えば、素粒子のスピンや運動量などの状態をまるで「コインの裏表」のように共有し、一方の粒子を観測したときのスピンが上向きであれば、もう一方は瞬時に下向きになる。

翌1998年には、2つの「量子もつれ」状態にあるペア粒子の一方同士を一緒にすると、もう一方同士も「量子もつれ」が生じることも実験で示した。

ツァイリンガーは、この「量子もつれ」という現象を使って、第3の粒子に記録した情報を、遠方に転送する「量子テレポーテーション」技術の開発に取り組んだ。これにより、量子情報科学分野を切り開いた。大量の量子ビッドを用いる量子テレポーテーションにより、遠く離れたところに量子暗号を送ることが可能となれば、量子コンピューターの実現につながる基本原理となる。

2022年「光子の量子もつれを用いて、ベルの不等式の破れを示した実験と量子情報科学の先駆的研究」の業績で、ノーベル物理学賞が「量子もつれ」を研究してきた仏サクレー大学のアラン・アスペ博士、米クラウザー研究所のジョン・クラウザー博士、オーストリア・ウィーン大学のアントン・ツァイリンガー博士の3氏に贈られた。

国立情報学研究所の添田彬仁准教授(量子情報)は「量子コンピューターで計算途中の情報を受け渡しするのに欠かせない」能力の証明と言う。そのため、量子コンピューターは、これまでの計算機とは桁違いの速さで計算できることが期待されている。添田彬仁准教授は「物理法則がそういうものだったとしか言えない」。実験を受け入れるしかないようだ。

量子コンピュータは「物質の重ね合わせ状態」を利用しさまざまな情報処理を行う。その代償が量子状態の崩れによるノイズであり、単位命令のスループットthroughput(コンピュータが単位時間あたりに処理できるデータ量。その数値がデータ処理能力やデータ転送速度をも示す)の悪化である。

既存のパソコンの主記憶装置揮発性半導体Dynamic Random Access Memory(ディーラムDRAM半導体)は、電荷を蓄えたキャパシタcapacitor(電池と比べて容量は小さいものの、一般的に電気的挙動がコンデンサ使用で容量が大きいものをキャパシタと呼ぶことが多い)の充電・放電で0・1を表しため、自然放電で電荷がなくなると記憶内容が消えるため、使用中は定期的に記憶保持のために電荷を与えて再書き込みをし直すリフレッシュrefreshを行う必要がある。

これに比べ、量子コンピュータは、物理的な構成要素であり情報の最小単位でもある「量子ビット」の状態を制御することで計算を行う。

量子ビットも従来コンピュータの「ビット」と同様に、何らかの物理的な素子の状態を使って0、1の情報を表現する。「ビット」とは異なる「量子ビット」は、「重ね合わせ」と「量子もつれ」と呼ばれる2つの量子性を持ち、量子コンピュータはこの2つの量子の性質を利用したアルゴリズムに基づいて計算を行うことで、従来コンピュータの計算処理と比較して計算ステップ数number of calculation stepsを大幅に減らすことができると言われている。

しかし量子性の特性を生かし、安定した状態を保持することが可能な量子ビットを作ることは非常に難しく、現在でも世界中で量子ビットに関する研究開発が直面する課題は尽きそうもない。

(ステップ数number of stepsとは、コンピュータプログラムの規模を測る指標の一つで、何らかの意味のある処理を行っているソースコードの行数のことで、最も単純な基準として採用し、プログラミング言語で書かれたソースコードの一行を一単位として、プログラム全体が何行で構成されているかを数える。

ステップ数の算出は容易で、誰が書いても似たようなプログラムになるような環境で、開発に参加するプログラマの技能水準が高レベルであれば、精度よく規模を推定できる。ただ、ステップ数を単純に開発者の評価や報酬に結びつけるような使い方をすると、わざと冗長に記述して規模を水増し、その一方、高い技能を持つ技術者がコードを簡潔に記述すると、正当に評価されないといった残念な事態が生じている)

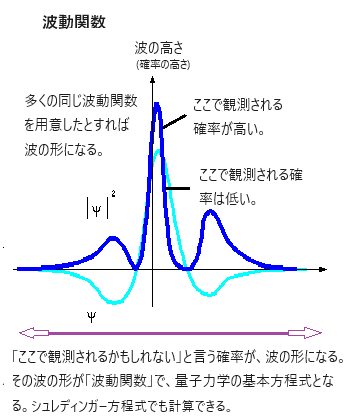

従来のコンピュータではビットの値は必ず0か1、電流がONかOFFかで決まる。しかし量子ビットは、0でもあり1でもある状態を取る。これを状態の「重ね合わせ」と言う。この現象は、量子が波の性質を持つことに由来する。波は通常、複数の状態の波が同じ場所に共存して影響を及ぼし合う。そのため波の性質を持つ量子も複数の量子が共存するという現象が起こる。しかし、量子の状態は最終的に0か1かのどちらかに決まる。それがいつの状態かというと、量子の状態を観測した瞬間ごとに量子の状態が確定する、としか言えない。

量子は粒子でもある。つまり、量子を素粒子として「観測」すると、途端に波が1点に集まって素粒子として振る舞う。量子はどちらの状態も取りうるけれど、観測した瞬間に量子の状態が確定する。これを「波束の収縮reduction of wave packet」と言う。

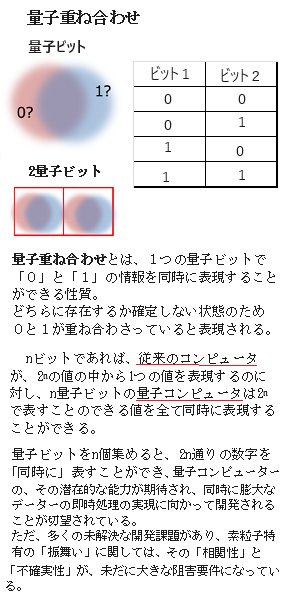

量子力学は測定値の確率分布を予言する理論である。量子力学の基本的な性質の1つである「量子重ね合わせ」とは、1つの量子ビットで「0」と「1」の情報を同時に表現することができる。しかも、どちらに存在するか確定できないため、0と1が「重ね合わせ」られていると表現する。つまり、その存在が確定しない状態を「量子重ね合わせ」と言う。

「量子もつれ」とは複数の量子間に生じる現象で、1つの量子状態が確定すると、他の量子の状態にも影響が及ぼす。隣のビットが0から1に変わると、量子の相関関係から自分に影響が及ぶ。量子ビットではそんな現象のつながりが起こる。量子学の創始者による、かなりの手探りと推測に満ちている非自明性の「力学」と言える。「量子」開発の現実では、そういう素粒子の相関性を受け入れるしかない。

「量子重ね合わせ」と「量子もつれ」の2つの現象は「量子力学の公理axioms of quantum mechanics」と言われが、その「力学」の実態は説明できない。量子力学の公理は試行と、その多くは錯誤の長い過程を経て導かれてきた。

目次へ

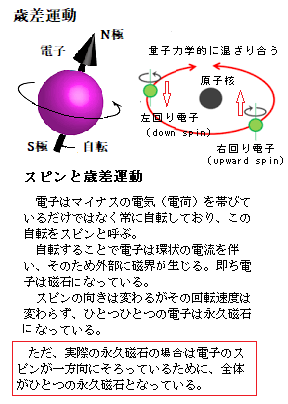

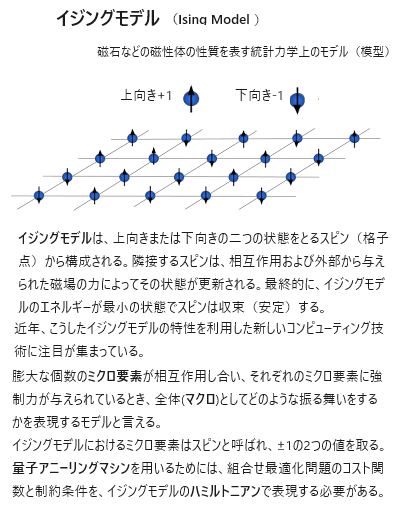

「重ね合わせquantum superposition」と「量子もつれquantum entanglement」により、一度に何通りもの計算が可能になる。「重ね合わせ」を利用すれば、1度に複数の状態を作り出すことができる。例えば2つの量子ビットを考えると、それぞれの量子ビットが0と1の2つの状態の重ね合わせを取ることができるため全体では、上図のような4つの状態となる。

これが10個になると1,024通り、30個では1,073,741,824通りとなる。重ね合わせを利用することで膨大な数の状態を一度に表現できることになる。この状態で演算を行うことで一度に何通りもの計算が可能となる。

量子コンピューターの量子ビットよって、複数の状態が同時に表現できる。「量子重ね合わせ」により、nビットの従来のコンピューターが、2nの値の中から1つの値を表現するのに対し、n量子ビットの量子コンピュータは2nで表すことのできる値を全て同時に表現することができる。

「この宇宙では真空中の光速度よりも速く情報が伝わることは無い」

「情報が伝わるスピードの最大値が真空中の光速である」

ところが

「宇宙誕生の初期の宇宙の膨張スピードは光速よりも遙かに速い。また、地球から遠い果てでは、現在の宇宙の【地球から遠ざかる】膨張スピードは光速を越えている」

光速を超えて遠ざかっているため、その星々の光を含めあらゆる情報が届かない。地球からは観測できない多くの星々がある。この宇宙では真空中の光速度よりも速く情報が地球に伝わることが無いにしても、光速よりも速い物があってこそ宇宙は存在できているようだ。

光速を超えて遠ざかっているため、その星々の光を含めあらゆる情報が届かない。地球からは観測できない多くの星々がある。この宇宙では真空中の光速度よりも速く情報が地球に伝わることが無いにしても、光速よりも速い物があってこそ宇宙は存在できているようだ。実験室では、「量子もつれ」による量子相互の情報が伝わる速度は光速を越えている。最近では、地上と人工衛星との間でも、その観測実験が成功している。

2つの量子のスピン情報が、なぜ光速を越えて一瞬で伝わるのか? またどうやって伝わっているのか?

それは現代の物理学では解明されていない。

「量子もつれ」によるテレポーテーションが、素粒子より大きい物質にも応用できれば、例えば250万光年離れたアンドロメダ銀河にも、一瞬で行ける。飛行機もロケットも必要としない。

量子コンピューターでは、この「量子もつれ」が核心となる。光より速く情報が伝わるのなら高速通信にもこの原理が使える。

この「量子もつれ」を利用した技術を使えば、正にSFを超えた未来が待っている。

さらに「量子もつれ」を利用することで一方の状態が確定するともう一方の状態も確定する状況を作り出するため、その分、計算処理を減らすことができると考えられている。

上記の2つの現象は、量子コンピュータの高速計算処理において重要な役割を果たす。量子コンピュータは量子ビットを使って計算することで桁違いの処理能力を発揮し、その速度は従来のコンピュータの実に約1億倍と言われている。しかも、量子コンピュータは電力消費が極めて小さいという大きなメリットがある。カナダのD-Wave Systemsが開発した量子アニーリング(QA)マシン「D-Wave」では、最初の量子ビット開発から16年間、量子ビット数を増やし続け、現在は5,640量子ビットを集積したチップを実用化している。「D-Wave」では、冷却装置によりごく低温で動作し、その消費電力は冷却装置も含めて25kW 以下だとされている。

ただし、その能力は全結合型でない。例えば、「D-Wave」を、「組合せ最適化問題」に使おうとするとすぐ大きな課題に直面する。全結合かそれに近い結合性が前提となる「組合せ最適化問題」では、依然として解ける問題の規模が極めて小さいと言う。これは、量子ビット間の結合が実装上の制約から全結合化にほど遠く、D-Wave2000Qなどで使われた「キメラグラフ」、また約5000量子ビットを備える最新のD-Wave Advantageに採用された「ペガサスグラフ」では、まばらな結合(疎結合)になっていることに起因する。全結合の問題を解くのに、「キメラグラフ」が実質64量子ビット、「ペガサスグラフ」が実質74量子ビットという。

カナダD-Wave Systemsは、2017年1月24日、量子アニーリング方式の量子コンピュータ「D-Wave 2000Q」を発売した。量子ビットを従来モデルの2倍となる2000個に増やした。米国のテクノロジ セキュリティ パラダイムを設計するセキュリティ企業であるTemporal Defense Systemsが新モデルの購入を発表している。

従来のコンピュータでは、AIモジュールの処理速度の高速化やビッグデータの解析などで、はや限界にきている。従来のコンピュータでは成し得ないレベルの計算、例えば数えきれないほどのパターンから、新薬開発のために行われる膨大な数の素材の組み合わせ演算や、複数のチェックポイントを経由する交通ルートや交通システムの改善、車の自動運転に欠かせないAIデバイスの即時処理能力の向上など、最適なパターンを一つ検出するといった計算を瞬時に行える量子コンピューターの開発が期待されている。

騒音の中でも、互いの話し相手の声が聞こえる。それは波同士が独立しているからで、波は一つ一つが独立しるため、2つの波は合体しても1つにならないばかりか、その後分裂して2つになることもない。これが「波の独立性」である。

量子は粒子であり、波の一であるから、独立性を保っている。混在はするが、混ざり合わないのは、量子が独立性を持っているからである。

量子相互の波は、互いに跳ね返ることはなく、重なり合うだけである。重なり合った波は変位するので、変位した同士が変位したまま、変位を足し合わせたものになる。ちなみにこの波は独立性を有するので、2つの波は通り過ぎれば元の波の形に戻る。

波と波が重なった時、合成される波の変位は重なった波の変位を合わせたものになる(重ね合わせの原理)。

「重ね合わせの原理」とは、量子は、複数の独立した排他的な状態にあり、それぞれが固有値を保持したままの重ね合わせで表されることを言う。観測した場合は、どれか1つの固有値のみが観測される。これを「波束の収縮 reduction of wave packet」と呼ぶ。まさに量子の非自明性であ。

目次へ

量子コンピュータが精妙に動作するための、それを支える周辺ハードウェアの技術開発が未だ達成できていない。多くの場合、これらの素子はカスタム設計されているが、実用レベルに達するためには、かなりの広範な研究と技術開発の蓄積が必要で、到達点は遥か彼方にある。例えば、インターネット上で使われている素因数分解(「正の整数(自然数)」は「1」以上の数を指す。このとき、マイナスになる数や「0」は正の整数ではない。その正の整数を素数のかけ算で表す。「素数」とは「1」とその数自身以外に約数を持たない数を指す)を用いた暗号を一瞬で解けるような量子コンピュータの実用化には何十年かかるか分からないという意見がある。それでも、完成すれば圧倒的な性能を引き出せるという理論的保証はあると言われている。

量子ビットを正確に制御することは難しいため、まだ100量子ビット未満の実装であるが、「量子アニーリング方式」は完全な量子制御を敢えて行わず、量子ビット自体の自然な状態変化を利用し、「量子アニーリング」という量子アルゴリズムに特化したマシンである。「量子アニーリング」自体は、量子ゲート方式でも実装され研究がされているが、量子効果を積極的に使えるため、量子ビット数で見れば量子アニーリングマシンの方がより大きな問題処理能力あると見られている。

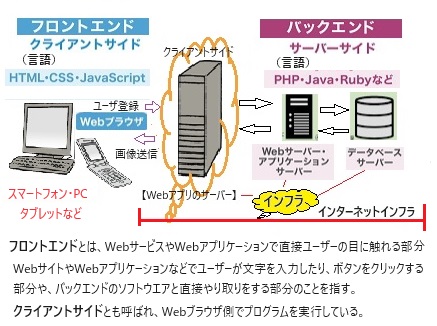

D-Wave社の量子アニーリングマシンでは、現在5,000量子ビットまで実装していると言う。従来型のスーパーコンピューターは大量の電力を消費し大量の熱を発生させるが、D-Waveシステムが消費する電力は25kW以下で、そのほとんどは冷却装置とフロントエンド・サーバーの作動のために使われている。

フロントエンド・サーバーとは、Webアプリケーションなどで、ユーザーが、PCやスマホのブラウザ上に描画するためのファイルを生成するためのサーバーで、JavaScript(JS)では、HTMLの一部を動かしたり、CSS(Webページの文字の色や大きさ・背景・配置などを設定する言語)を動的に追加したりできる。例えば、領域を増やしたり、各種色を変化させたりもできる。

量子アニーリングは、先述したように「組み合わせ最適化問題」を解くための量子アルゴリズムである。実社会での幅広い応用が想定される「組み合わせ最適化問題」は、従来のコンピュータでは膨大な数の組み合わせから逐次確認と選択を行いながら問題を解くが、量子アニーリングでは「量子もつれ」を利用しながら「量子ゆらぎ」を用いて最速に最適解に近づける。ただ、「組み合わせ最適化問題」は、量子アニーリングよりも、従来のコンピューターの方が効率的に解ける問題も多いという。

量子アニーリングマシンによる計算だけで、何かができるわけではない。実用段階では、現場にある課題のどのような側面に「組み合わせ最適化問題」を適用できるかを見極める必要があり、また従来のコンピューターをベースとした最適化計算を行いつつ、その上でどの部分に量子アニーリングによる計算を組み込むかを考えなければならない。

実際のところ量子アニーリングマシンに送る情報をどのように準備するか、最適化演算の結果をどう処理するかなどの領域は、従来のコンピューターによるプログラミングによりほぼ網羅されている。しかも、「組み合わせ最適化問題」は、量子アニーリングよりも、従来のコンピューターの方が効率的で、適していると言われている。そのためもあり、従来のコンピューターをよく理解しているソフトウェアエンジニアの方が、現段階では即戦力になる。

目次へ

2020年に、量子アニーリングマシンD-Wave 2000Qによる計算結果がある。

2020年に、量子アニーリングマシンD-Wave 2000Qによる計算結果がある。「20台の車で160人の乗客を10分単位、複数の時間帯指定がランダムに設定されている。全部で29の時間枠で、5時間内で送るという配車経路問題であった。」

車20台、顧客160人となれば1つのタクシー会社の拠点くらいの事業規模が想定される。これを問題にしたのは、量子アニーリングマシンの性能が上がり、同時にアルゴリズムをアップグレードしたようだ。

2020年当時、D-Wave社がリリースした最新のD-Wave Leap Hybrid Solver (version 2)で解くことができる最大サイズであった。しかし、この程度のサイズなら従来型のコンピューターでは一瞬に解答する。

(ソルバーSolverとは、表計算ソフトの一種でもあり、複数の変数を含む数式において、目的とする解を得るための最適な変数の値を求めることができる。

ソルバーでは、複数の変数の値を変化させながら、変数の相互関係を判断し最適な解を算出する。ある変数に特定の制約条件をつけたり、あるいは特定の変数が最大値・最小値を得るために他の変数の値を変化させたりすることもできる。また連立方程式の解や、複数の項目が連動する事業計画の試算といった複雑な演算能力も実装する。

ソルバーに時間がかかりすぎる理由は、大規模アルゴリズムを使用している場合や、さまざまなアルゴリズムオプションの試行などがあるためなので、何より高速な解法を有効にする必要がある)

2019年当時の量子アニーリングマシンでは、単独の計算であれば、小さな問題しか算出できなかった。2020年の「version 2」では、従来型コンピューターベースの計算法と量子アニーリングを組み合わせることで規模の大きな問題も効率よく扱えるようになった。

問題の規模が大きくなればなるほど量子アニーリングでは、有効な解が得づらくなる。今の量子アニーリングの計算でも、単独では完全な最短ルートを算出することはできない。それでも従来型コンピューターベースの計算法と組み合わせられれば、最良解が算出できるのは、ソルバーsolver性能(複数の変数を含む数式において、目標とする値を得るための、最適な変数の値を求めることができる機能)が上がっていなくても最良解が取り出せるようなったのは、新たなアルゴリズムが工夫されたからである。

全ての問題を量子コンピューティングで計算すればよいというものではなく、量子コンピューティングはあくまでも「難しい問題」を解く方法である。一番難しいのは「一様にランダムな問題」であれば、量子コンピューターの性能が高ければ遺憾なくその能力を発揮できる。

|

実社会におけるビッグデータを扱うとなれば、複雑に混在する問題の方が圧倒的に多いはずである。そのため、従来型コンピューターによって問題を解きつつ、難しい問題を取り出すという選択が前段階で必要となる。

量子アニーリングquantum annealingは「組合せ最適化処理」を高速かつ高精度に実行することが期待されている計算技術であるが、近年の量子アニーリングマシンの登場により、量子アニーリングの実用的な利用法が広く開発され始めている。しかし、量子ビット数やノイズの対策は未だ不十分で、現状の量子アニーリングマシンでは大規模な問題を高精度に解くことができない。そこで、大規模性能を補完する方法の一つとして、量子アニーリングマシンによる小規模な最適化を古典的手法と組み合わせる「ハイブリッド方式hybrid method」の開発である。

2020年に、古典的手法である分子動力学法molecular dynamics(MD)を、量子アニーリングの前処理に用いる古典・量子ハイブリッド方式が提案された。それがハイブリッド量子アニーリングHybrid Quantum Annealing (HQA)という仕組みである。

(物質のマクロな性質、例えば密度・硬さ・内部エネルギー・磁性などは、それを形成する原子核 ・電子・原子の配置の仕方・運動の仕方・エネルギー分布・スピンなどのミクロ現象によって決まる。分子動力学法は、その全ての素粒子の運動を時系列で調査し、物質全体としての性質を導きだす計算機シミュレーションと言える。)

量子アニーリングマシンとして、カナダ最西部に位置するブリティッシュコロンビア州バーナビーを拠点とする量子コンピュータ企業ディー・ウェイブ・システムズD-Wave Systems, Inc.が開発したのが、 D-Waveの量子コンピューター(量子アニーリング)である。

量子コンピュータ関連ビジネスを手掛ける(株)グルーヴノーツ(本社:福岡市、代表取締役社長:最首 英裕)は、清水建設(株)と土木工事の生産性向上を目的に、量子コンピューターの「情報通信技術Information and Communication Technology(ICT)」を活用して、建設発生土砂のダンプトラックによる運搬計画を最適化する共同検証を行った。

清水建設による土木工事の土砂運搬ルートに量子コンピューターを適用したシミュレーションでは、走行台数を変えずに1日当たりの運搬量を約10%増加できたと公表した。

(これまでデジタルデータを扱う技術やモノを「情報技術Information Technology【IT】」と表現することが主流であったが、近年では、デジタルデータの通信量が膨大になったため、現在では、情報通信技術を表す「ICT」に移行しつつある)

しかし、現状の D-Wave マシンは、測定ごとに回折データの値が少しずつ異なる値をとるノイズ対策や、最適化問題では、解ける問題の規模が極めて狭いなど、それに加えて量子ビット数に限界があるため、変数の数が多い規模の大きな最適化問題の解を正確に算出するのは難しい。そこで、量子アニーリングの前処理として分子動力学法Molecular Dynamics(MD)を用いることにより、量子アニーリングによる解の領域を絞り込む工夫を行っている。

原子・分子の動きをコンピューターの中で再現するために使われる手法が「分子動力学シミュレーション」である。分子動力学(MD)シミュレーションとは、経験的なポテンシャル(力場)の下に、古典力学の優れた業績「ニュートン方程式」による数値解析により解くことで、 注目する物質の時間発展time evolutionを観測し、その系の動的過程を解析する手法である。しかし、量子力学において電子の位置や運動量は特定され るものではなく、ある領域に存在する確率やある範囲の運動量をとる確率しか示さない。ただ、存在確率の高い領域を調べることは出来る。 また水溶液中におけるタンパク質のMDシミュレーションには膨大な計算が必要なため、通常はスーパーコンピューターを用いる。

現在でも分子動力学法(MD)により、分子や原子といった粒子を運動方程式で数値的に解く場合、多数の粒子の運動を追跡する手法をとる。生体分子を構成する原子の解析や、液体中の衝撃波に関する実験などに、計算機シミュレーションは様々な分野で利用されている。

MDでは粒子それぞれを運動方程式で繰り返し解くが、それは古典ハミルトニアンの正準方程式で解くことと等価であることが知られている。

この手法では、

① 観測データなどをもとに原子の最初の配置を決める。

② そして、1個の原子に他の原子から及ぶ力を計算する。

原子同士の間に働く力には、原子が分子をつくるときの化学結合の力や、原子の中の電子がプラスやマイナスの電気と磁気力を帯びていることによる静電気力、そして分子同士の間に働くファンデルワールス力や水素結合などがある。これらをすべて合計する。

③ その力を受けた原子がどのように運動するかをニュートンの運動方程式に基づいて計算する。

これにより、最初の配置から一定の時間が経過ごとに、原子の配置がどう変わったかが分かる。この配置を新たな出発点として、また②と③の計算を行う。非常に短い時間の刻みでこれを繰り返すと、原子が徐々に動いていくようすを再現できる。

この分子動力学シミュレーションでは、何万個もの原子の1 個1個について同時に②と③の計算を行う。

通常、量子の世界の時間の刻みは1フェムト秒(フェムトは10-15乗;1,000兆分の1秒)程度であれば、数十ナノ秒(ナノは10-9乗)の現象を再現するだけでも、数千万回の計算が必要となる。そのため、「京」の計算能力が期待されている。

この手法により、タンパク質と薬の候補化合物が結合するようすを再現できる。また「結合の強さ(エネルギー)」などの値を求めることもできる。

19世紀イギリスの物理学者ウィリアム・ローワン・ハミルトンWilliam Rowan Hamilton(1805年-1865年)が創始した正準方程式Hamilton's canonical equation(正準方程式とは、「運動エネルギーとポテンシャルエネルギーの差」を示すラグランジュ値を解く方程式【微分方程式】を、座標で表したものにほかならない)は、統計力学や物理学などの広い分野に及び、理論の枠組の拡張を可能にし、特に微分微積分と分析幾何学に関する多くの精巧な論文の主要な要素となった。

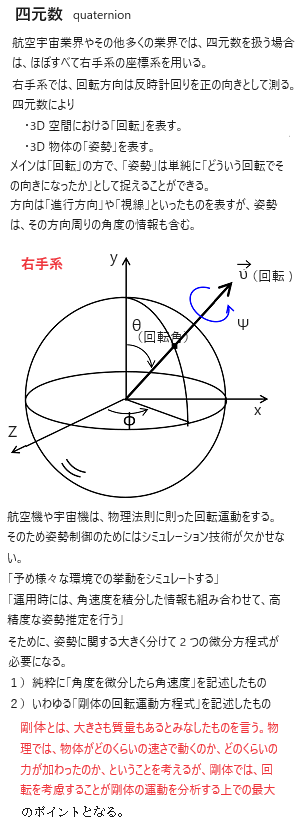

19世紀イギリスの物理学者ウィリアム・ローワン・ハミルトンWilliam Rowan Hamilton(1805年-1865年)が創始した正準方程式Hamilton's canonical equation(正準方程式とは、「運動エネルギーとポテンシャルエネルギーの差」を示すラグランジュ値を解く方程式【微分方程式】を、座標で表したものにほかならない)は、統計力学や物理学などの広い分野に及び、理論の枠組の拡張を可能にし、特に微分微積分と分析幾何学に関する多くの精巧な論文の主要な要素となった。最も重要な発見が、3次元幾何学を理解するのに役立つ「四元数の代数」であった。量子力学など現代物理学への橋渡しにも重要な役割を果たした。量子力学で使用される基本的な概念の多くは、ハミルトンの功績を称え「ハミルトニアンHamiltonian」と呼ぶ。「ハミルトニアン」は、ラグランジュ力学よりも、多様な変数変換に対して共変となるため、系を記述する独立変数のとり方に大幅な自由度が得ら、任意の物理量の時間微分を容易に求めることができる。ニュートン力学では 運動方程式の導出が難しい場合でも、ラグランジュの運動方程式ではいとも簡単に導出される。しかも、ラグランジュの方程式は、ニュートンの運動方程式と 同等でありながら、運動量と座標を対称的に取り扱うことができため、力学の動的な構造が深く理解できる。

ハミルトンは、数学に「四元数quaternion(しげんすう)」の概念を導入した。その生涯の最後の22年間は、「四元数の要素」に関する研究を進展させ続けた。これは、逝去する数日前に完成した。死因はアル中の果ての痛風発作、享年60歳。20紀も後半になって、全然関係ない工学分野で突如再評価され、今では確固たる地位を築いている。

「大きさとその向きを持つ量」を示すベクトルVektor(独語、英語: vector)は、元天文系の用語であったが、その力や速度の物理量を数学に用いたのはハミルトンが初出であった。長さ・力・速度・温度などの物理量の「大きさだけをもつ量」を示すスカラーscalarや、物理における多くの自然現象を整合的に、またその空間の性質を数学的表現するテンソルtensorはいずれもハミルトンの造語である。

(テンソルには、膨大な「数値の種類【次元/軸の数など】」がある。しかも「1種類あたり多項目」が基本情報に加わるため、膨大な数値の集まりとなり、それを整理する必要がある。

テンソルは「ベクトル」や「行列」といった特殊な形の情報もまとめて扱うことができる。

そのため、ベクトルは1列の数字だけなので「1種類【1次元】のテンソル」として示せるが、行列は行と列で2種類の要素があるので、「2種類【2次元】のテンソル」になる。その上に、各種類あたりに、それぞに必要な項目数が付け加わわれば、【2種類で3項目】と【3種類4項目】のテンソルになれば【3行4列の行列】となる。

「名前が変わっただけ」であれば、そのベクトルや行列を計算するためのアルゴリズムを使えばいい。

ただ、複雑で大規模なニューラルネットワーク【人間の脳のようなニューロンneuroに似た層構造で相互接続し、学習を行うシステム】となれば、次元数が大きくなり、計算が難解となる多次元のテンソルにまで達する。実は、益々膨大化したテンソルの計算には通常レベルのコンピューターでは難しく、通常のCPUでは処理に時間がかかるため、並列計算に特化したGPUなどが使われている。

複雑で大規模なニューラルネットワークでは、次元数が大きく計算の難しい多次元のテンソルが使われている。それでも、近年はテンソル計算に特化したコンピュータやアルゴリズムが開発されており、コンピューターの「テンソルを扱う能力」は飛躍的に向上している。 )

「四元数」は、任意軸回転をキーワードとして、いかなる回転も三次元空間内に表現できることが強みである。

その発見が現代の物理学やベクトル解析の基礎となり、ひいてはラジオ・テレビ・レーダーの発明へとつながった。人気コンピューター・ゲーム『トゥームレイダーTomb Raider』のララ・クロフトの滑らかな動きも、この「四元数」を利用して作られている。

「四元数」を使って、3D 空間における「回転」を表し、3D 物体の「姿勢」を表す。「回転」がメインで、「姿勢」は「どういう回転でその向きがどうなっているか」を示す。そのため「姿勢」は、「方向」や「回転」よりも多くの情報を含んでいる。

航空機でいえば、機首が向く方向だけでなく、同時に機体の傾きが分って初めて機体の姿勢が明らかになる。数理的には、姿勢は最小3個のパラメータparameters(変数)で表せる。回転も姿勢と本質的に一体であれば、同様に3個のパラメータで表せる。例えば、剛体の運動を考えるとき、剛体が今どのような位置関係を持っているかを3つの角度を使って表現するオイラー角は 、3 個のパラメータで姿勢や回転を表す。3つの角度を表す記号として、φ・θ・ψを使う。

アインシュタインの特殊相対理論における四次元空間とは、普通の世界の空間には縦・横・高さがあり、時間が一方向に流れている、その面白い相対関係である。

「速度が増すと、質量が増大し、物差しの長さが長くなり、時間の進み方が遅くなる」などの、非自明な不思議な現象が起こる。

飛行機の運動を記述するには、位置( x,y,z )、速度( u,v,w ),回転運動( p,q,r )の変数が情報に含まれるので、9つも成分に生じる変数をベクトルの計算をする必要がある。つまり「九次元ベクトル」である。

アインシュタインは、3次元の計量空間と時間を4つセットにして計算し、物の長さと時間の相対性を示した。

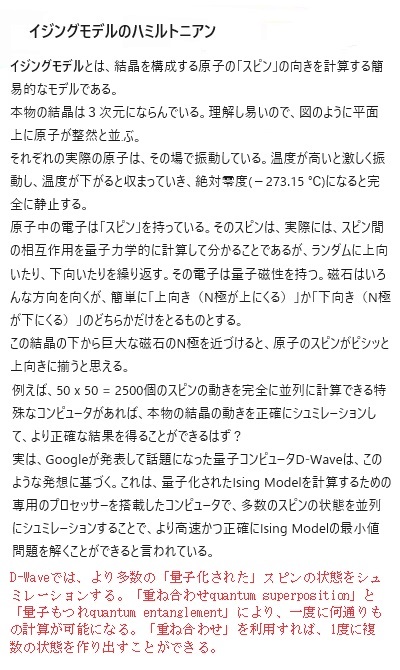

正準方程式canonical equationを繰り返し解いて粒子の時間発展を計算し、この「ハミルトニアン」を介して適切に設計することにより、エネルギーを最小化する。つまり、イジングモデルIsing modelの基底状態を探索するような「ハミルトニアン」を設計すれば、分子動力学法molecular dynamics(MD) によって組合せ最適化問題の解を求めることができる。そのような「ハミルトニアン」を設計することを目標とした。

イジングモデルIsing modelとは、磁性体の性質を表す統計力学上の簡易な模型で、そのモデルの格子点から上向きまたは下向きの二つの状態をとるスピンから構成される。隣接するスピンは、相互作用や外部から与えられた磁場の力によってその状態が更新されるが、最終的に、そのエネルギーが最小の状態でスピンは安定する。

量子コンピューティング技術、例えば2011年、D-Wave Systems Inc.は組合せ最適化問題をイジングモデルへと変換し、量子アニーリングを用いて問題を解く量子コンピュータを発表している。量子アニーリングを、イジングモデルの動作する半導体回路で擬似的に再現し、その「組合せ最適化問題」の実用解を、室温下で、効率良く解くことができる。

イジングモデルにより、量子アニーリングの2つの動作を模擬テストする。一つは、イジングモデルにおけるスピン間の相互作用を再現し、イジングモデル内のエネルギーを低下させていくテスト、もう一つは、スピンを再現している回路にノイズを注入し、わざとスピンの状態を破壊するテストをする。前者のテストだけでは、定型的になり、エネルギーが最小ではない部分で固定される局所解となるおそれがあるため、後者のテストによって局所解を回避し、可能なかぎりエネルギーが低い部分における実用解を求めていく。

分子運動のシミュレーションに対して、HQAを適用し、1万個ある配列のうち、古典コンピューティングで解が決定できた9600個と、量子アニーリングを使って処理する変数400個を分離することに成功した。

組み合わせ最適化問題の解法として、分子運動のシミュレーションを利用する方法で作ることができる。この方法は、従来型コンピュータによって量子アニーリングを模倣し、分子の自己組織化によって最適解に近い状態を導く。通常量子マシンであれば、計算の途中過程を見ることができない。それは観測することで量子状態を壊してしまうからである。しかし、量子アニーリングを古典コンピュータで模倣すると、途中の軌跡を見ることができる。その中で悩んでいる変数が従来型で3解くことが難しい変数であり、量子アニーリングマシンにより解くべき問題として演算される。

この過程は、混在する問題を遠心分離機にかけて変数を固定しつつ、従来型コンピュータが悩んでいる少数の変数を浮き上がらせるような仕組みである。この取り出された部分が「実問題に潜む一様にランダムな難しい問題」と言える。

(コンピューターの世界では、計算することを演算と言う。コンピューターでは、通常の四則計算以外にも、変数や定数を使ってさまざまな計算や制御を行い、「逆転項目」の導入で数値を逆転させたりするなど、いろいろな演算が行われる。特に、「0」と「1」の組み合わせによって定義された論理演算というものがある。これがコンピューターの根本的な機能になっている。

問題を解決するにあたり、複雑な状況を、可能な限りシンプルにすると見通せることが多い。このようなときに図式化や数式化を行うことをモデル化と言う。 モデル化により図式や数式が創出されたら、それに基づい想定される仮説をそれぞれ試してみる。

条件を少し変えて別の仮説でもうまくい くか試してみる操作を繰り返すことが必要で、この作業のことをシミュレーションと言う。ひとつのモデルに基づいて条件を少しずつ変えながら解決策に近づく作業である。

モデルが数式化されれば、コンピューターを利用したシミュレーションが行える。数式が複雑であってもコンピューターが正確に高速に処理するので、シミュ レーションを何度でも簡単に繰り返すことで演算ができる)

目次へ

今現在の量子コンピューターでは、量子自体を制御する技術が未完成であるため、素因数分解を一瞬で解くなどのような量子アルゴリズムはまだ実現されていない。

量子コンピュータの定義は、「量子ゲート方式」と「量子アニーリング方式」で代表される。全ての量子計算ができる「量子ゲート方式」に対し、「量子アニーリング方式」とは最適化計算に特化した方式である。そのため、「量子アニーリング方式」でできることは、「量子ゲート方式」でも実現できると見られている。しかし、現時点では量子ゲート方式に比べ量子アニーリング方式は開発が進んでおり、既に用途は限られるが実用化が始まっている状況である。

「量子ゲート方式」は、量子状態にある素子の動きや組み合わせによって任意の計算回路を組み、問題を解く方式である。任意の回路を組むことによって量子ビットの「重ね合わせ」状態を、量子系のパラメータparameter(ITの分野では、ソフトウェアやシステムの挙動に影響を与える、外部から投入される変数データなど)を断熱的に変化させてふたたび元に戻すなどの際に、量子の波動関数に加わる位相方向の特定領域だけを励起する制御ができるか否かの違いがある。あらゆる量子計算を構築する目的で作られ、量子効果を自由で積極的に活用することで量子計算の特性を引き出しやすくする。

「量子ゲート方式」は、量子状態にある素子の動きや組み合わせによって任意の計算回路を組み、問題を解く方式である。任意の回路を組むことによって量子ビットの「重ね合わせ」状態を、量子系のパラメータparameter(ITの分野では、ソフトウェアやシステムの挙動に影響を与える、外部から投入される変数データなど)を断熱的に変化させてふたたび元に戻すなどの際に、量子の波動関数に加わる位相方向の特定領域だけを励起する制御ができるか否かの違いがある。あらゆる量子計算を構築する目的で作られ、量子効果を自由で積極的に活用することで量子計算の特性を引き出しやすくする。その「量子ゲート方式」は、大規模な計算を精度よく実行でき、複雑なアルゴリズムを処理できる汎用型の量子コンピューターになりえるとして開発が進められている。現在GoogleやIBMなどの開発では、主流とされているものがゲート方式であり、従来のコンピュータの上位互換として開発が進められている(2023.03.14)。

量子ゲート方式の最大の課題は、「量子アニーリング方式」にも共通するが「誤り訂正の技術の確立」と、そのための「多数の安定した量子ビットの実現」である。

量子ビットの不確定性原理のために、情報のコピーできない。それにより誤りを訂正できないため量子コンピューターを実現することは不可能だと考えられてきた。

コヒーレンスcoherence時間や、その後の「量子もつれ」状態にある量子ビットを活用すれば、エラーそのものではなくエラーの原因を観測して確定させて、量子ビットのエラーを訂正する方式など、今では精力的に研究開発されている。この「誤り訂正」は、「量子もつれ」状態にある複数の量子ビットを生成し、それを適切に操作することで実現できるが、そのための必須な要件は、十分なコヒーレンスcoherence時間(「量子重ね合わせ」状態が安定的に持続できる時間)を持つ多数の量子ビットを扱えるようになることが重要である。加えて.、安定して動作できる誤り訂正の技術の確立が不可欠である。これらを実現さえすれば、量子コンピューターの実用化が本格化するが、その達成は未だ見通せない。

2017年、マサチューセッツ工科大学(MIT)の研究チームは、分子を極低温に冷却して作り出した「量子重ね合わせ」状態を、1秒間という長い時間スケール(従来比数百倍)にわたって持続させることに成功したと発表した。「量子重ね合わせ」状態が持続する時間の長さを「コヒーレンス時間coherence time」と呼ばれ、これを伸ばすことは量子コンピュータ実現の上で非常に重要な技術となる。 (coherence【koʊhí(ə)rəns】には、【結合】【密着】【纏まり】などの意味がある。接頭語の【co-】は、共同の、共通の、相互の意味、【here-nce】は、同調, 密着,干渉性などの意味) 一般に物理分野ではコヒーレンスの日本語訳は「可干渉性」と訳されることが多い。「互いに干渉することができる波動の性質」を示す。

|

| 「直感的に理解できる」ニュートンの運動方程式が基礎となっていた古典論と比べると、量子力学の真価が現れるような素粒子の世界ては「我々の直感と相当乖離」している。

実際、直感とはかけ離れた量子の物理現象を学ぶとなれば、実験事実により検証できない方程式や議論は研究対象になりえない。 空間的に広がりを持つ電子が観測により1点に見出される様子は「波動関数の収束」と呼ばれる。しかし、その素粒子を測定して結果を得た途端、その状態は瞬間に別な状態へと変化する。現在の量子力学は、「なぜ観測により波動関数が収束を起こすのか」とか、「観測しないときに電子はどの位置にあるのか」といった問いには答える術がない。 つまり「観測や実験によって検証できない命題」は、量子力学による研究対象になりえない。 |

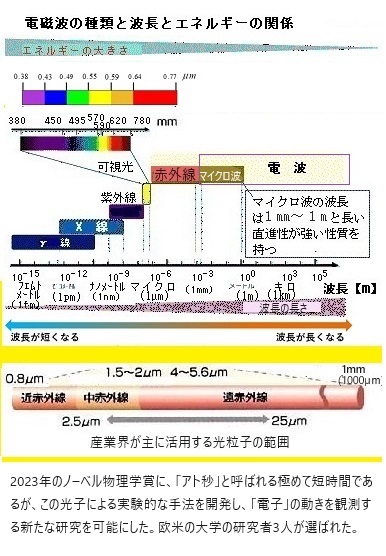

| 量子力学では、電子などの素粒子はその位置と運動量の両方を同時に正確に計測することができないと言う。しかも測定するまでは、その位置の予測もできないと言う【不確定性原理uncertainty principle】。1927年、ハイゼンベルグにより提唱された量子力学の根幹をなす素粒子そのものが持つ物理的性質である。 それでも、20世紀の初め頃から構築されてきた「量子力学」は、今や携帯電話やコンピュータをはじめめ、医療機器などのエレクトロニクス産業の重要な支柱となっている。そればかりか、非破壊分析が可能となり、考古学・医薬・環境などの分析法として蛍光X線分析・放射化分析、そして赤外分光分析などを開発してきた。 赤外分光法は、物質に赤外光を照射し、透過または反射した光のスペクトル情報を測定することで、試料の構造解析や定量を行う分析手法である。赤外光(2.5~25µm)は、紫外・可視光(0.2~0.78µm)よりも波長が長くエネルギーが小さいため、電子遷移には及ばず、分子振動のエネルギーに当る際の光や信号などの波の成分などを分析する。 電子の運動では、「位置」と「運動量」を同時に確定できないために、量子力学的な解析に頼る。 この電子の位置と運動量を同時に確定できない事情は、2つの物理量の不確定性と呼ばれる量子自体の基本的な性質による。その不確定性は、「そもそも量子の世界での測定とは何か」、「量子もつれと呼ばれる状態にある離れた2個の粒子の間の不思議な遠隔作用の問題」など、その非自明性のため実験物理学が主流となり、その結果、実用に直結する多大な成果を実現してきた。 「ゲート方式」は汎用型の量子コンピュータであるが、基本的な量子ゲートを組み合わせた【量子回路】を構築し計算を行う。 原子の位置は、測定により確定する。その一方では、「波動関数の崩壊」により量子状態を直接観測・制御することはできない、という量子力学の壁は克服されていない。 【量子の不確定性原理】では、現実、位置がはっきりと定まらない波動関数(粒子)のため、運動量は決まらないと言う。原子や電子などの量子の世界では、一つの粒子について、位置と運動量、時間とエネルギー、角度と角運動量などのように互いに関係ある物理量を、同時に確定することは不可能である。そのため波の位置は、その時々の観測に頼るざるを得ない。 素粒子を用いた二重スリットの実験でも、素粒子は波動として両方のスリットを同時に通過し、スリットの後方で干渉縞が形成・観察されている。 古典力学では、時間x と運動量 p を指定して、その後の運動が記述できるが、量子力学では、両方が決まっているような状態にならないため、確率と相関性に頼る。 |

ナトリウムとカリウムの2原子分子気体の極低温冷却にした真空チャンバー(真空を作り出すための容器)の開口部からレーザービームを照射して分子を捕捉し冷却する。

2原子分子が持っている量子情報には、構成原子の核スピンや電子スピンなど、そして分子の回転エネルギーや振動エネルギーなどがある。分子が極低温に冷却されることで回転および振動のエネルギー準位が最低状態に下がり、核スピンの方向も揃う。このような状態で核スピンのコヒーレンス時間を1秒という長時間に延ばすことに成功したという。これまで分子を用いた同じような実験では、回転エネルギーに関するコヒーレンス時間でミリ秒スケールの長さが報告されていたが、それを数百倍上回る長さを実現したことになる。

観測行為を行うまでは粒子のもっている量子情報が1つに確定せず、1つの粒子の中に異なった状態の量子情報が同時に存在するという量子力学的な性質を「量子重ね合わせ状態」と言う。コヒーレンス時間とは、量子的に重ね合わせられた2つの状態の素粒子間で干渉が続く時間のことであり、干渉が消えると量子重ね合わせ状態は失われ、粒子の状態はひとつに確定する。

この量子重ね合わせをデータの保存や計算処理に応用するのが量子コンピュータである。通常のコンピューターでは1ビット(情報の基本単位)が「0」か「1」どちらか一方の値を取るのに対して、量子コンピューターにおける1量子ビットは「0」と「1」がある確率で重ね合わされた状態になる。これを利用することで従来のコンピューターでは行えなかった高速の並列計算などが可能になると考えられている。

量子ビットの担い手として利用可能な物質には、電子・原子・分子などさまざまなレベルの粒子があるが、この中で2原子分子を使うことのメリットとして、1つには、 核スピン、分子の回転エネルギー、振動エネルギーなど、重ね合わせ状態にできる量子情報の種類が多いということがある。加えて、粒子同士やその粒子を外界と相互作用させたりするのが容易であることも分子の特徴であると研究チームは指摘する。

分子間の相互作用が容易だと何が良いかと言うと、複数の量子ビットを組み合わせて「量子ゲート」を作るのに適している。量子ゲートは、量子コンピュータによる演算処理を行う場合の基本操作であり、従来のコンピュータの「論理ゲート」に相当するものである。

論理ゲート

論理ゲートというのは、例えば入力[1,1]に対しては出力[1]を返す、それ以外の入力[0,0][0,1][1,0]に対しては出力[0]を返すというような単純な記号操作のルールである。いま挙げた例はAND(論理積)と呼ばれる論理ゲートだが、他にもOR、NOT、NAND、XORなどいくつかの種類のゲート操作があり、コンピュータ上では複雑な演算もこれらの単純な論理ゲートの組み合わせに還元して処理される。量子コンピュータの場合には、量子ビットの重ね合わせ状態を利用した並列処理可能なゲート操作を行うことになるので、これを「量子ゲート」と呼んでいる。

今回のような2原子分子による量子システムの最大の利点として研究チームが強調しているのは、量子ゲートを用いた演算処理と、データ保存のためのストレージ(補助記憶装置)という2つの異なる機能のために、同一の物理系が利用できるという点である。理想的な量子ビットに求められる条件は、量子ゲート操作を行うときには強く相互作用するが、ストレージとして情報を保存している間は相互作用が起きないという性質がある。今回のような双極性のある2原子分子は、核スピンの長いコヒーレンス時間という特徴からストレージ(補助記憶装置)用の量子ビットとして利用でき、その一方で、分子間の回転運動の相互作用に基づく量子ゲート操作にも適しているという。

2022年3月15日付で『npj Quantum Information』に掲載された。 「スイスのジュネーブ大学は、メモリーとして用いた結晶に量子ビットを20ミリ秒間保存することに成功したと発表した。固体状態の量子メモリー保存時間としては世界新記録となり、長距離量子通信ネットワークの開発に向けて大きな一歩を踏み出したといえる。」

20世紀に発展した量子物理学は、ある粒子が同時に複数の場所に存在する可能性を表す「重ね合わせ」や、2つの粒子が離れていても同時に影響を及ぼし合う能力を表し、アインシュタインが「不気味な遠隔作用」と呼んでいた「量子もつれ」など、マクロな世界にはない現象を導入した。そして量子物理学は、コンピューター・スマートフォン・GPSなど、さまざまな技術の発展を可能にしてきた。

現在では、非常に安全な通信ネットワークの構築を目指して、メッセージ暗号化技術に関する分野で、量子論は暗号技術研究の中心となっている。量子論は、通信している両者間で情報(量子ビット)を光ファイバー内の光子が伝送する際に、情報の完全な真正性と機密性を保証することを可能にする。「重ね合わせ」現象によって、送信者はメッセージを運ぶ光子が傍受されたかどうかを即座に知ることができるのだ。

しかし、長距離量子通信システムの開発には、光ファイバーの中を数百km進むと、量子ビットを運ぶ光子が消滅してしまうという問題がある。信号のコピーや増幅ができないため、信号の機密性を保証する量子状態が失われてしまう。そのため、伝送される信号を再生および中継するための装置、「量子メモリーベースの中継器repeater」を作ることで、信号を変化させずに中継する方法を見つけることが重要な課題となっている。

研究チームは2015年に、光子によって運ばれた量子ビットを0.5ミリ秒間、結晶に保存することに成功した。このとき、光子は結晶の原子に自身の量子状態を転写してから消滅した。

今回の研究では、この持続時間を大幅に伸ばし、20ミリ秒間、量子ビットを保存できた。さらに、わずかに忠実度は低下したが100ミリ秒の大台も達成した。以前の研究と同様、光を吸収して再放出できる希土類金属を添加dopeした結晶を用いており、今回は希土類金属にユウロピウム(原子番号63,元素記号Eu)を使用した。この結晶は、絶対零度(マイナス273.15℃)に保たれていた。絶対零度より10℃以上高くなると、結晶の熱擾乱によって原子の量子もつれが破壊されるからだ。

この結晶に1000分の1テスラteslaといった微小な磁場をかけ、強い周波数を結晶に送る動的デカップリングdecoupling法を用いた。これらの技術により、希土類イオンを環境の摂動から切り離し、長いコヒーレンス時間を伸ばしたままストレージ性能を従来の約40倍に高めることができた。

(動詞coupleは「連動する、連結する」ことを意味し、これに否定を表す接頭辞のde-が付く「デカップル(Decouple)」は、「切り離す、分離する」という意味になる。)

この成果は、長距離量子通信ネットワーク開発にとって大きな前進となった。現在の課題も、保存時間をさらに延ばすことにある。また、1度に1個以上の光子が保存でき、機密保持を保証する量子もつれ状態にある複数の光子を保持できるメモリーを設計する方法を開発しなければならな。目標は、これら全ての点で高い性能を発揮し、10年以内に市場に出せるようなシステムを開発することにある。

隣接する分子同士の相互作用を利用する量子ゲート操作は、マイクロ波などを照射して分子の回転準位を制御することによって可能になるとされている。1回の量子ゲート操作を行うために必要な時間は1000分の1秒以下という短時間なので、今回のように数百個程度の分子クラスターclusterで1秒間のコヒーレンス時間が維持できれば、その間に1万回から10万回くらいのゲート操作が可能となると研究チームは説明する。

おそらくこのような分子1000個からなる配列を使えば、従来型のコンピューターで行っているような論理ゲート(与えられた論理式に対応する演算を行う電子回路を示す)による演算処理を、量子コンピュータの量子ゲートで実現できると考えられている。従来型コンピューターと比べて、量子コンピューターのほうが常に計算が高速になり、従来解けなかった問題が量子コンピューターにより何でも解けるようになるわけではないが、ある種の問題に対しては、量子コンピューターの実現によって圧倒的な高速処理が可能になることはわかっている。

その代表例が、大きな数の素因数分解の計算である。ある整数Nを素因数分解するためのアルゴリズムを考えると、従来型コンピュータでは解を得るために必要なアルゴリズム実行回数は、Nの桁数の指数関数となる。このため整数Nの桁数が大きくなるにつれて、アルゴリズム実行回数は指数関数的に増大していき、現実的な時間内に問題を解くことが事実上不可能になる。

現代のRSA暗号システム(桁数が大きい自然数の素因数分解の難しさを利用した暗号アルゴリズム。1977年に発明され、発明者3人の名前の頭文字をつなげて呼ばれる)は、このような大きな数の素因数分解の難しさに依拠して暗号の安全性を保障している。

(RSA暗号とは、素因数分解の難しさを利用した暗号アルゴリズム。大きな数字を素因数分解するのは困難で、総当たりする以外に素因数を見つけ出す方法がない。したがって、コンピュータで素因数分解しようとしても、大きな数であれば膨大な時間がかかる。RSAは発明した3人の名前R. L. Rivest、A. Shamir、L. Adlemanに由来する。)

一方、量子コンピュータの場合、整数Nを素因数分解するためのアルゴリズム実行回数は、Nの桁数に比例したオーダーになる。また、この問題を解くために必要な量子ゲートの個数も、同じくNの桁数に比例したオーダーとなる。

例えば、Nの桁数が1000倍に増えても計算量は高々1000倍にしかならないので、これまで宇宙の寿命を使い切っても解けなかったような巨大な数の素因数分解がほとんど一瞬で解けるようになると考えられている。このため、量子コンピュータの登場によって、現在のRSA暗号の安全性は成り立たなくなると指摘されている。

日本電気株式会社(NEC)は、2019年1月16日、説明会を開き、2023年にも実用化する量子アニーリングマシンの開発状況について説明した。NECが開発した超伝導パラメトロン素子の強みとして、早ければ量子の重ね合わせ状態が持続するコヒーレンス時間を1ms(=0.001秒;ミリ秒)に保てるため、10-50の試行ができると、目標を示した。また、量子アニーリングマシンを使いこなせるソフトウェアの開発を行ない、多分野で活用できる環境を提供する、と発表した。

(パラメトロンparametronは、1950年代に東京大学で開発された計算機の演算素子である。1954 年、酸化鉄を主成分とする硬磁性体のフェライトを コアに使った LC 回路【"L" で表されるコイルと "C" で表されるコンデンサのみが導線でつながれた回路】の 1/2 分周波発振が記憶に使える のではないかと考え、これを論理回路として使った素子を まとめて「パラメトロン」と命名した。フェライトコイルから形成されたパラメトロンを用いた計算機はパラメトロン計算機と呼ばれ、日本で商用化された。その後トランジスタの普及し、パラメトロン計算機は衰退した。しかし、近年、さまざまな物理系でパラメトロンが実現され、基礎物理だけでなく、新たな計算機への応用の観点からも再び注目を集めている。

超伝導パラメトロンは、ジョセフソン素子Josephson device【低温で動作するスイッチング素子】とキャパシタ【蓄電装置】で構成される超伝導共振回路である。回路を共振周波数の約2倍の周波数で変調することにより、0またはπの位相で発振する。これらの位相の異なる発振状態の重ね合わせを量子ビットとして使用することができる。磁束量子ビットと比較して、量子ビットの寿命で、高速演算が可能な時間の上限が決まるまで桁違いに長いため、一定時間内における計算精度の向上が見込める。)

NECが、日立製作所や富士通のようなデジタル回路による方式ではなく、カナダのD-Wave Systemsと同様に、専用の超伝導量子回路に超電導パラメトロン素子を使うのは、量子アニーリングマシンの性能に関する4つのパラメータである、量子ビット数・量子重ね合わせ時間(コヒーレンシ時間)・結合度・解像度を同時に向上できるからと説明する。超伝導パラメトロン素子は、外部から大きなエネルギーを与えて量子状態を作るので、ノイズの影響を最小限にとどめられ、2023年の実用化の段階では、1msというコヒーレンシ時間の目標が試行できると言う。

量子回路を使う場合、処理を終えるまで量子の重ね合わせ状態のコヒーレンシ時間が持続すれば、、コンピューターとしての能力が向上する。その状態が持続していれば、量子アニーリングで解を導き、時間が過ぎれば古典的アニーリングの計算で解を導くことができる。コヒーレンシ時間が持続すれば、実際の問題解決にあたり、古典的アニーリングの時間を短くして量子アニーリングの時間を増やせので高速化が可能になる。

量子コンピューティングの開発当初、最も注力したのが量子ビットの実現だった。従来のコンピューターのビットは「0」か「1」を基本原理とするが、量子ビットは、「0」か「1」の2つの状態を同時に表すことができる「重ね合わせ」の原理が働く。現在でも、インテルIntelなどの複数の組織が、電子スピンの特性を活用した量子プロセッサの開発に取り組んでいる。現代主流となっている開発領域は、あらゆる「重ね合わせ」時間の無限大と言える。

量子状態の持続時間を飛躍的に伸ばすことが、量子コンピューターの実現への第一歩である。「重ね合わせ」や「量子もつれ」を基本原理として活用すれば、同時に多くの計算を実行できるが、その際に過剰な熱が発生する。このため、効果を発揮するには、絶対零度に近い温度(-273.15℃に非常に近い温度)で稼働する必要がある。

開発途上にある量子コンピュータ-の多くの場合カスタム設計されているが、量子プロセッサを制御する極低温冷蔵庫から張り出された数百本のケーブルが必要になるため、多くの量子コンピューティングシステムは、ケーブルが四方八方から飛び出す奇妙マシンのようになる。

Intelは量子ハードウェア開発の初期段階でテストと特性評価を行う中で、商用規模の量子処理の実現を阻む重大なボトルネックは、相互接続と制御エレクトロニクスと言う。

目次へ